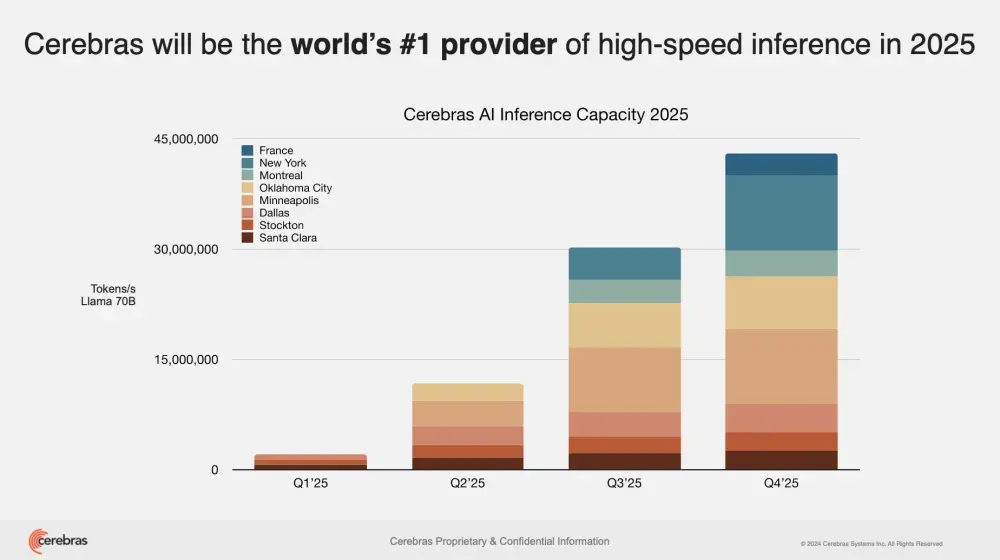

Cerebras Systems,一家致力于挑战英伟达在AI市场主导地位的初创公司,于周二宣布了一项重大扩展计划:在全球新增六个AI数据中心。此举不仅将大幅提升其推理能力,还将与关键行业伙伴建立合作关系,进一步巩固其作为高速AI推理服务领先提供者的地位。

数据中心扩展与性能提升

Cerebras将在北美和欧洲新增六个AI数据中心,使公司的推理能力提高20倍,达到每秒处理超过4000万tokens的能力。新设施位于达拉斯、明尼阿波利斯、俄克拉荷马城、蒙特利尔、纽约以及法国。其中85%的数据中心容量位于美国,旨在满足日益增长的AI推理需求,并为即将到来的Llama 4和DeepSeek模型做好准备。

Cerebras产品营销总监James Wang指出:“我们预计随着新模型的上线,市场需求将持续增长。这是我们今年的重要举措之一,以应对几乎无限增长的推理令牌需求。”

战略合作加速AI应用

除了基础设施的扩展,Cerebras还宣布了两项重要合作:

- Hugging Face:通过这一合作,Cerebras的高速AI推理服务将直接面向Hugging Face平台上的500万开发者开放,简化了开源AI模型(如Llama 3.3 70B)的访问流程。

- AlphaSense:Cerebras为这个金融情报平台提供了10倍的速度提升,显著增强了其基于AI的市场情报搜索功能。

高速AI推理的竞争优势

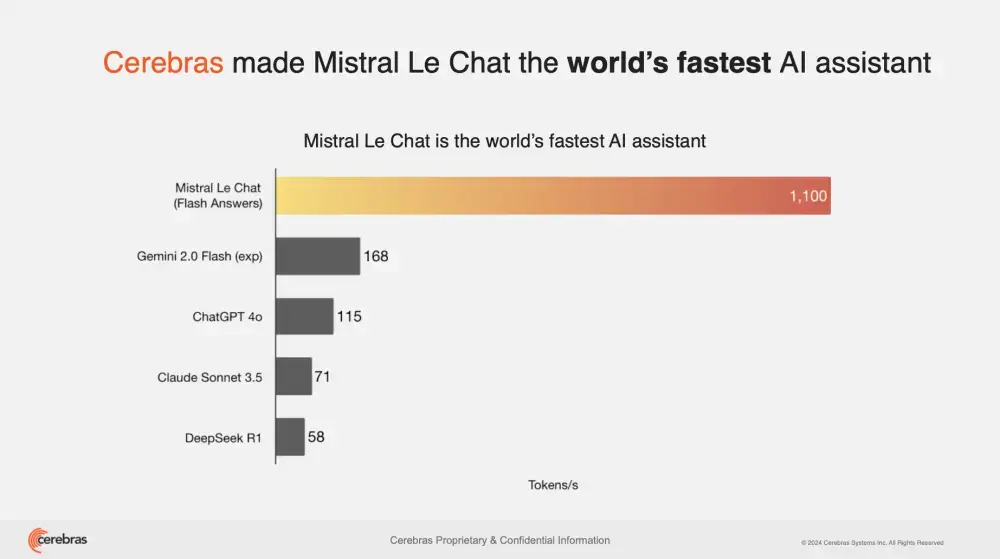

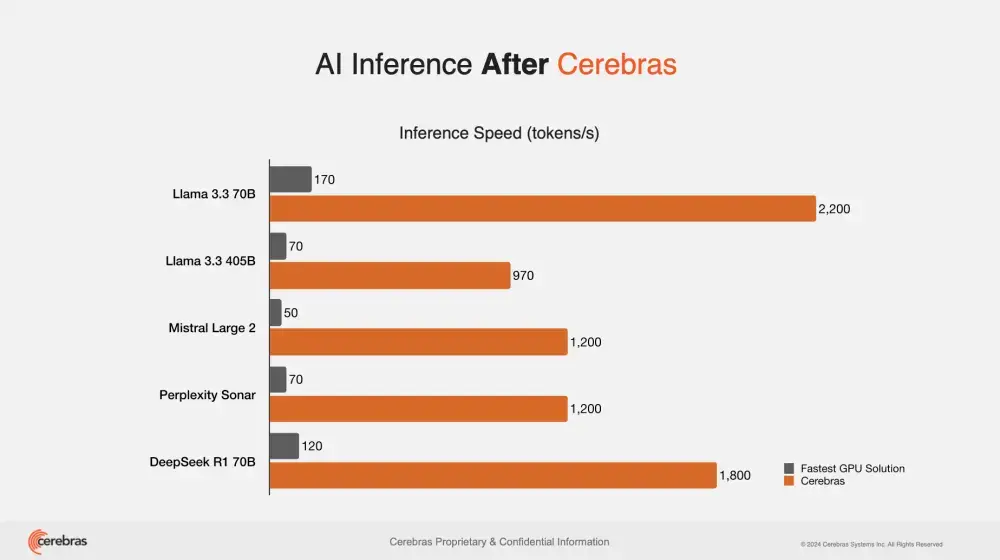

Cerebras的Wafer-Scale Engine (WSE-3)处理器以其卓越的速度著称,比基于GPU的解决方案快10到70倍。随着AI模型变得越来越复杂,这种速度优势变得尤为关键。Cerebras不仅帮助Perplexity AI成为世界上最快的AI搜索引擎,也为Mistral AI等公司提供了强大的支持。

经济效益与技术韧性

Cerebras强调其解决方案不仅能大幅降低成本(例如,运行Llama 3.3 70B的成本约为GPT-4的六分之一),还能显著提高处理速度。此外,公司在基础设施韧性方面也进行了大量投资,如俄克拉荷马城的新设施设计可抵御极端天气事件,确保持续的服务可靠性。(来源)

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...