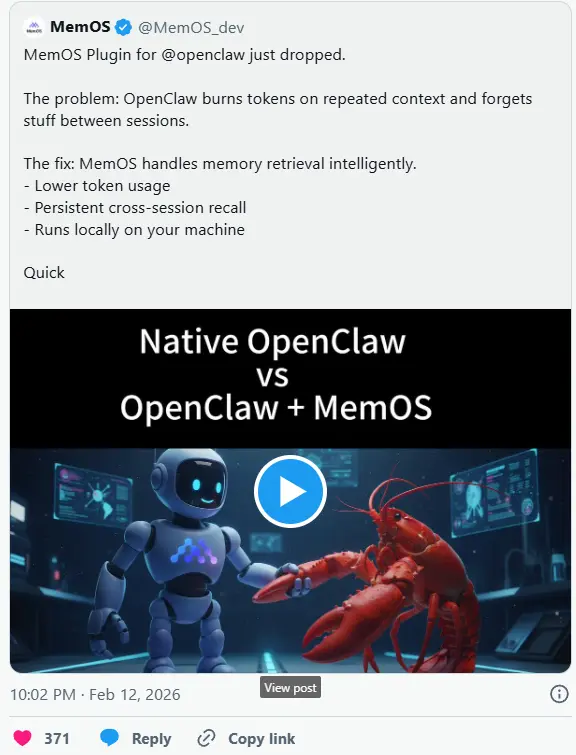

MemOS 正式推出专为 OpenClaw 打造的专属插件,这款即插即用的共享内存层,核心价值在于为使用 OpenClaw 构建应用的团队,解决两大核心痛点——大幅降低令牌成本,同时确保多智能体协作时的上下文一致性,让长期运行的智能体工作流更具经济性和实用性。

与原生 OpenClaw 内存流程相比,MemOS OpenClaw 插件的优势十分明确:它无需让智能体反复重新加载庞大的上下文窗口,而是将需要存储和召回的内容,转移到专用的共享内存层中,实现内存的复用与高效管理。根据 MemOS 官方基准测试数据,该插件可将令牌使用量削减 60% 至 70%,这一优化在智能体每日持续运行、处理多步骤复杂任务,或是嵌入到付费产品(每额外消耗一个令牌都对应实际成本)的场景中,显得尤为关键——毕竟随着 OpenClaw 广泛应用,令牌消耗过高已成为许多团队的核心负担,甚至影响智能体工作流的规模化落地。

多智能体协作的核心痛点:孤立内存导致的低效与浪费

当前多智能体协作已成为 AI 领域的热门方向,无论是 AutoGen、CrewAI,还是近期大热的 OpenClaw,行业都在积极探索多智能体协同工作的最优路径,试图通过分工协作提升复杂任务的处理效率。但在实际落地过程中,多智能体协作始终面临一个突出难题:每个智能体都携带一个孤立的“大脑”,即独立的内存空间,彼此无法共享信息,也不知道其他智能体的工作进度与成果。

这种孤立内存模式,直接导致三大问题:一是重复劳动,多个智能体可能针对同一任务环节反复处理,浪费算力与令牌资源;二是上下文不匹配,智能体之间的信息无法同步,容易出现工作衔接断层、结果偏差;三是信息交接繁琐,需要人工通过复制粘贴等方式传递信息,大幅降低协作效率,也增加了人工成本。

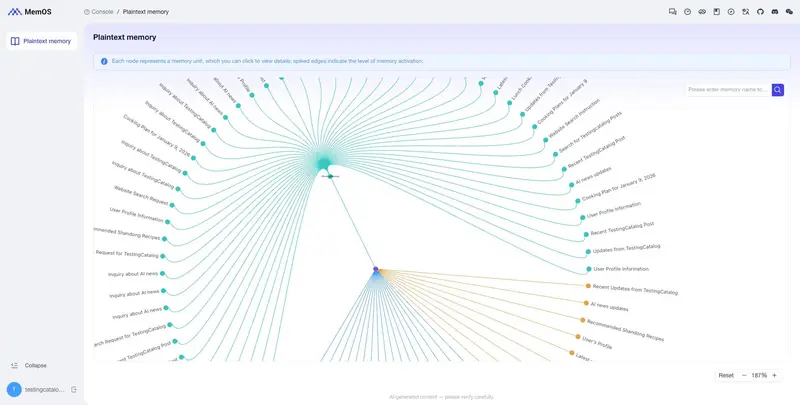

MemOS OpenClaw 插件的核心设计初衷,就是破解这一协作困境。它为多个 OpenClaw 智能体搭建了一个统一的共享内存池,替代了以往每个智能体独立维护内存的模式——整个智能体团队可共同向这个统一空间写入信息、读取数据,智能体 A 产生的工作结果,智能体 B 可直接访问、复用,无需人工介入传递,从根本上避免了重复劳动与上下文错配,让多智能体协作更顺畅、更高效。

目标受众与便捷可用性

MemOS OpenClaw 插件的目标受众定位清晰,主要覆盖四类群体:B2B 智能体构建者、开发工具团队、企业内部智能副驾驶开发者,以及所有在交付智能体工作流时,面临内存成本过高、上下文一致性不足瓶颈的从业者。这类群体的核心需求的是“降本增效”,既希望控制令牌消耗带来的成本压力,也需要解决多智能体协作的低效问题,而该插件恰好精准匹配了这些需求。

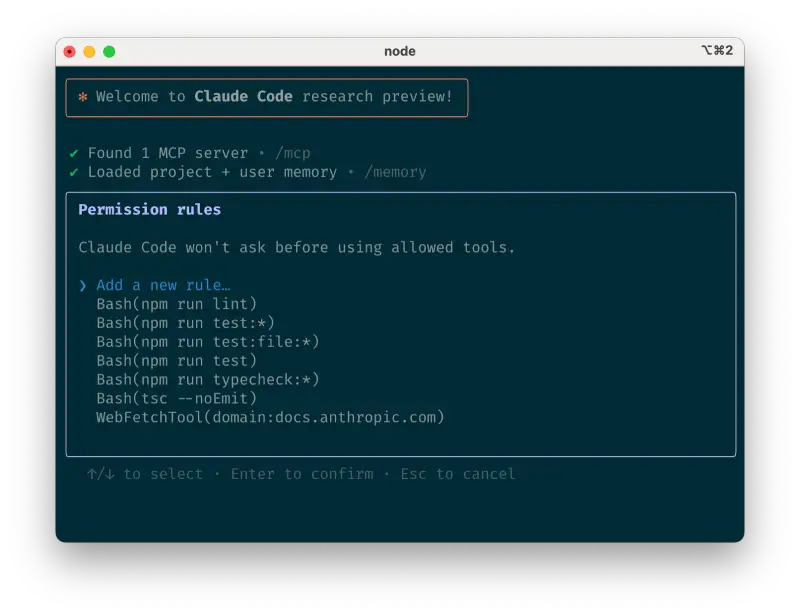

在可用性方面,该插件采用极简设计,无需复杂的配置流程,完全支持即插即用:插件通过 GitHub 分发,开发者可直接获取并无缝接入自身正在运行的任何 OpenClaw 环境,无需修改核心代码、无需额外部署组件,大幅降低了接入门槛,让不同技术水平的开发者都能快速上手使用。

值得注意的是,该插件的发布,正值内存工具成为智能体堆栈核心竞争战场的关键节点。目前市场上已有 mem0、supermemory、memU 等多款同类产品同台竞技,其中 mem0 主打极简主义,是第一代轻量级抽取插件,完成了内存优化概念的早期验证;memU 则专注垂直深耕,提供结构化记忆的专业化解决方案;而 MemOS 则走出了差异化路线,其核心观点是:内存不应被视为临时附加的提示技巧,而应作为智能体堆栈中一个独立的操作系统层,实现更高效、更灵活的内存管理与复用。

关于 MemOS:面向智能体的“内存操作系统”

推出这款 OpenClaw 插件的 MemOS,本身定位为面向 AI 应用和智能体的“内存操作系统”,也是当前神经记忆(Neural Memory)路线的前沿探索者之一,与 EverMemOS、Zep 等产品并列为记忆系统领域的代表性项目——其中 EverMemOS 主打生态完整性,致力于构建下一代 Memory OS 完整生态;Zep 则追求工业级水准,打造企业级 Memory Server 的稳定性标杆,而 MemOS 则聚焦神经记忆方向,持续探索内存优化的全新可能。

MemOS 拥有独立的官方网站、操作仪表盘,并且在 MemTensor 组织下拥有更广泛的开源足迹,具备成熟的技术积累和完善的产品布局。此次推出 OpenClaw 插件,是 MemOS 推进其核心愿景的最新举措:将内存推入一个可重用、可共享的独立层,让这一层能够在不同智能体、不同会话之间实现共享、持久化和重复利用,最终解决长期运行的智能体工作流中,因反复加载上下文而导致的令牌成本过高问题,推动智能体技术的规模化、低成本落地。

相关文章