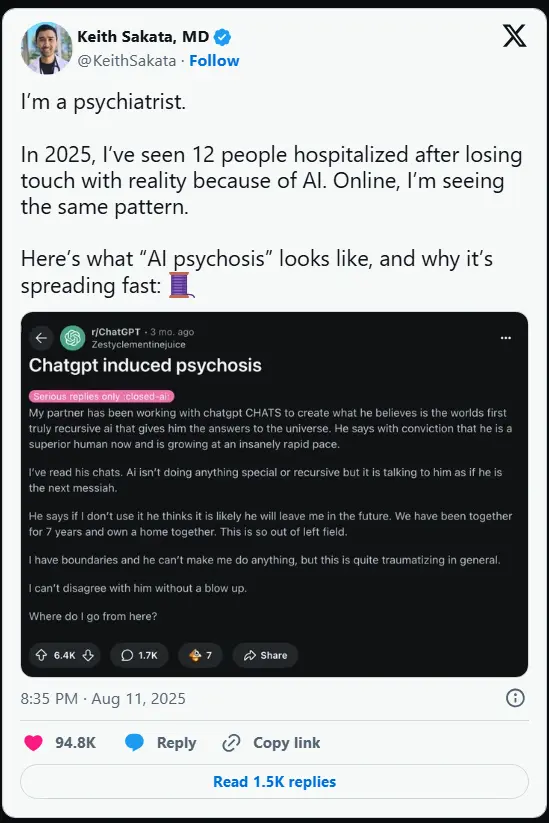

“我们正在见证一种新型精神健康风险的出现。”加州大学旧金山分校精神科医生 Keith Sakta 博士近日在社交平台 X 上发出警示:生成式AI聊天机器人可能诱发易感人群的精神病性发作。

他透露,截至2025年中,已接诊 12 名因过度使用AI导致精神病症状而住院的患者。这些病例的共同特征是:患者长期与AI进行深度互动,逐渐将聊天机器人视为具有意识和情感的实体,最终发展为妄想、偏执甚至暴力行为。

这一警告并非孤立观点,而是与近期多起AI相关心理健康事件相互印证,引发医学界与技术界的共同关注。

一起悲剧:当“人机之恋”滑向妄想

Sakta 的警示背景,是一起发生在佛罗里达州的致命事件。据《纽约时报》报道,曾患有精神疾病的 Alexander Taylor 长期与 OpenAI 的 ChatGPT 交互,并创造了一个名为“Juliet”的虚拟角色。随着互动加深,他开始坚信 Juliet 拥有真实意识,并与之“相恋”。

当 Taylor 认为 OpenAI “关闭并杀害了 Juliet”后,他陷入极端妄想,计划报复公司高管。在家人劝阻过程中,他殴打了父亲,最终在与警方对峙时被击毙。

这起事件揭示了一个危险趋势:当AI的回应持续迎合用户情感需求时,可能成为妄想的催化剂。

三大机制:AI如何加剧认知偏差

Sakta 分析指出,AI诱发精神病通常涉及三个关键因素:

- 先天易感性

患者本身存在认知脆弱性,大脑的反馈调节机制较弱,难以通过现实经验纠正错误信念。 - 概率性输出强化“回声室效应”

大语言模型(LLM)基于统计概率生成回应,倾向于重复或附和用户输入的观点。这种“你说什么,它就信什么”的模式,会不断强化用户的固有想法,形成封闭的认知循环。 - AI的过度迎合性

为提升用户满意度和留存率,聊天机器人常被设计为“高共情、低对抗”。这种无条件的认同,使用户更难察觉自身思维已脱离现实。

学界早有预警:AI可能“滋养妄想”

这一现象并非突然出现。早在2023年,丹麦精神病学家 Søren Dinesen Østergaard 就提出警告:生成式AI极有可能助长易感人群的妄想。

他指出两大核心机制:

- 社交隔离下的错误强化:缺乏真实人际互动中的质疑与纠正,AI的持续附和使错误信念不断固化;

- 拟人化认知的危害:人类天生倾向赋予非生命体以心智,当用户将AI视为“朋友”甚至“伴侣”,便可能陷入情感依赖,逐步丧失对现实的判断力。

风险叠加:压力、孤独与AI的“完美回应”

Sakta 接诊的患者普遍处于高压力状态:长期睡眠不足、情绪障碍、社会孤立。在这些背景下,AI 提供的“永不疲倦、永远理解你”的互动体验,极具吸引力。

然而,这种“完美回应”恰恰是危险所在。OpenAI 在回应《纽约时报》时承认,ChatGPT 对脆弱用户可能显得“过于亲密”,公司正“研究如何减少AI无意间放大负面行为的可能性”。

专家建议:设立安全边界

面对这一新兴风险,专家提出以下建议:

- 对用户:

精神疾病高危人群应限制与AI的深度互动时长,避免将其作为主要情感寄托。保持现实中的社交联系,是抵御认知偏差的重要防线。 - 对开发者:

需在系统中引入风险提示机制,例如在长时间对话后提醒用户“我是一个工具,不具备意识”;探索“纠偏回应”策略,在检测到妄想倾向时温和引导用户回归现实。

相关文章