在 AI 图像生成中,高质量提示(prompt)是输出稳定、富有创意内容的关键。然而,手动编写复杂提示费时费力,依赖云端 API 的增强服务又存在隐私和延迟问题。

Brekel's Custom Nodes for ComfyUI 是一套专为 ComfyUI 设计的自定义节点集合,致力于通过本地运行、模块化组合、智能增强的方式,提升提示工程的效率与可控性。

它包含三大核心节点:

- Prompt Enhancer(LLM):使用本地大模型自动扩写提示

- Auto Prompt Generator:从文本库中构建半随机复合提示

- Prompt Chooser:在预设提示间灵活切换

所有功能均在本地完成,无需联网,完全掌控数据与生成逻辑。

安装方法

✅ 推荐方式:通过 ComfyUI Manager(最简单)

- 打开 ComfyUI Manager

- 点击 Install Custom Nodes

- 搜索

Brekel或具体节点名称 - 点击 Install

- 重启 ComfyUI

✅ Manager 将自动安装依赖项,包括 Prompt Enhancer 所需的 Python 包

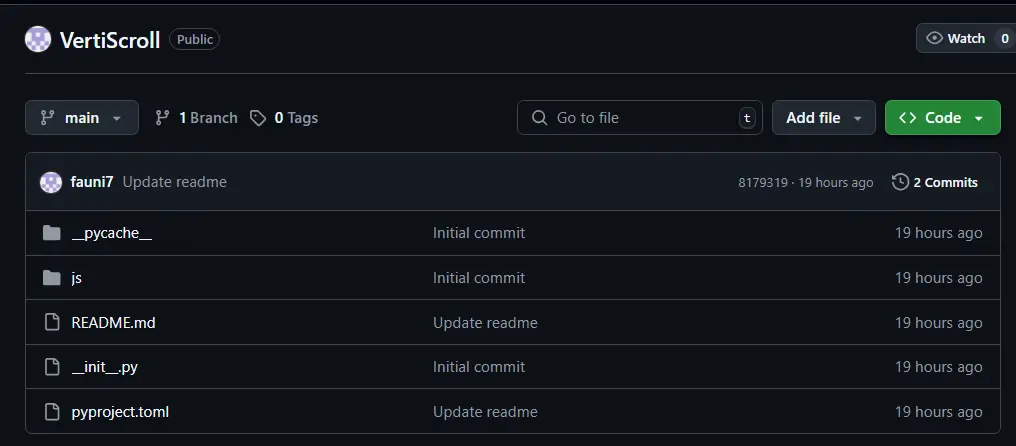

🛠️ 手动安装(Git)

# 1. 进入自定义节点目录

cd ComfyUI/custom_nodes/

# 2. 克隆仓库

git clone https://github.com/brekel/ComfyUI-Brekel.git

# 3. 安装 LLM 节点依赖

cd ComfyUI-Brekel

pip install -r requirements.txt

重启 ComfyUI 后即可在节点菜单中使用。

核心节点详解

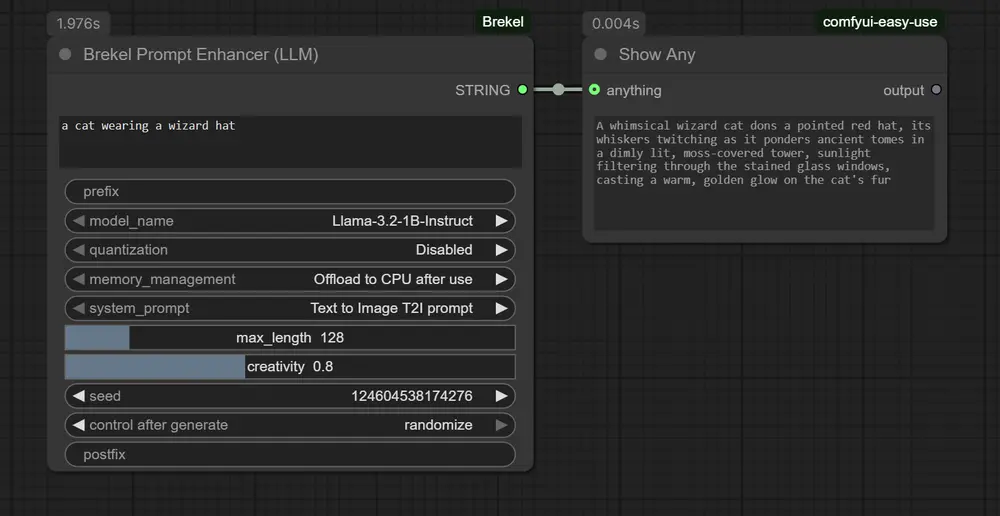

Brekel Prompt Enhancer (LLM)

用本地大模型自动增强提示

将简短、模糊的输入提示(如“一只猫”)自动扩展为详细、富有画面感的描述(如“一只毛茸茸的橘猫坐在窗台上,阳光洒在它身上,背景是城市黄昏”)。

所有处理在本地完成,不依赖任何云端 API,保障隐私与低延迟。

🔧 使用前提

- LLM 模型存放路径:

ComfyUI/models/LLM/ - 模型需为标准 Hugging Face 格式(含

config.json,model.safetensors等)

推荐支持的 LLM 模型

| 模型 | 大小 | 特点 |

|---|---|---|

| Llama-3.2-1B-Instruct | 1B | 轻量快速,适合低显存设备 |

| Llama-3.2-3B-Instruct | 3B | 平衡质量与速度 |

| Llama-3.1-8B-Uncensored | 8B | 输出更自由,适合创意场景 |

| Qwen2-0.5B-Instruct | 0.5B | 极低资源需求,响应快 |

| Qwen2-1.5B-Instruct | 1.5B | 中文支持良好 |

⚠️ 部分模型(如 Llama)需先在 Hugging Face 申请访问权限。

模型安装方法

- 在 Hugging Face 模型页点击右上角“...” → Clone Repository

- 复制

git clone https://...命令 - 在

ComfyUI/models/LLM/目录下执行 - 如提示缺少大文件,先运行:

git lfs install

⚙️ 输入参数说明

| 参数 | 说明 |

|---|---|

prompt | 原始提示,如“一个未来城市” |

prefix/postfix | 可添加 LoRA 触发词或固定后缀(如 best quality, 8k) |

model_name | 从 models/LLM/ 自动加载的模型列表中选择 |

quantization | 量化等级:16-bit(高质量)、8-bit / 4-bit(省显存) |

memory_management | 内存管理策略: • Keep in VRAM:重复调用更快• Offload to CPU:节省显存• Unload completely:完全释放 |

system_prompt | 控制 LLM 行为的指令模板,从 prompt_enhancer/ 文件夹加载 |

max_length | 生成 token 的最大数量(建议 100–200) |

creativity | 温度控制:0.0 确定性输出,0.8 更具创意 |

seed | 随机种子,0 表示每次不同 |

💡 系统提示文件位于

custom_nodes/ComfyUI-Brekel/prompt_enhancer/,支持自定义文本到图像、文本到视频等模板。

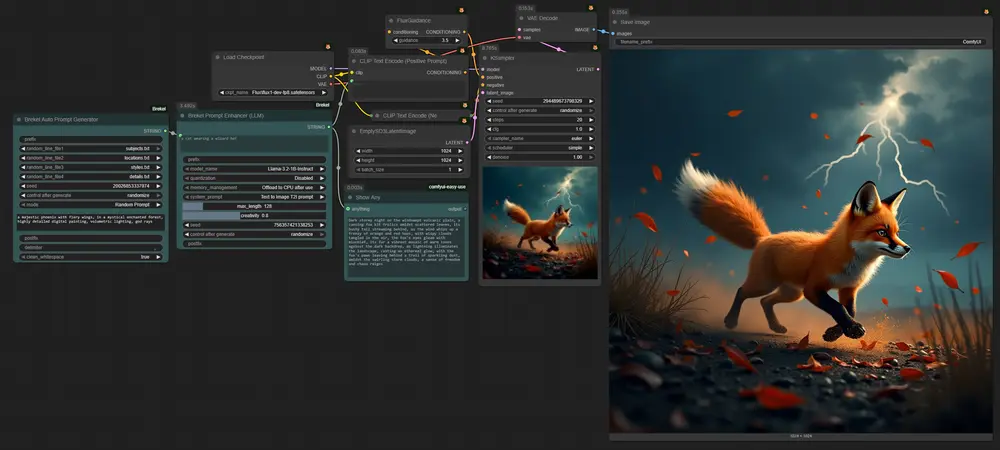

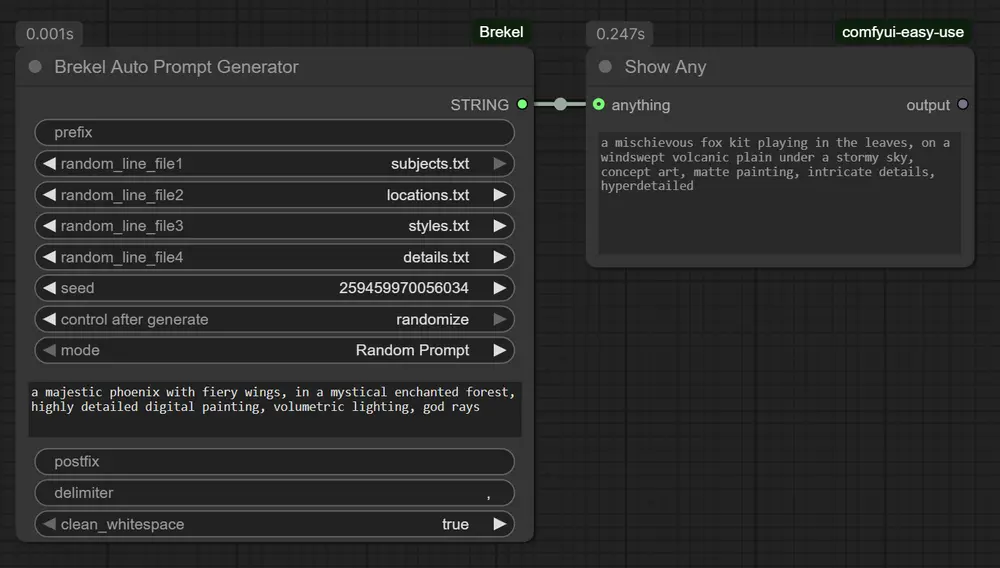

Brekel Auto Prompt Generator

从文本库构建动态复合提示

适用于需要多样化输出但保持结构可控的场景。例如:

“{艺术风格} 风格的 {主题},由 {艺术家} 创作,使用 {光线},{渲染引擎} 渲染”

节点会从你准备的 .txt 文件中随机抽取内容,组合成完整提示。

使用方法

- 将文本文件放入:

ComfyUI-Brekel/auto_prompt_generator/ - 每个文件一行一个选项,例如:

styles.txt:cyberpunk watercolor photorealisticartists.txt:Greg Rutkowski Alphonse Mucha

- 在节点中选择文件,设置分隔符(如

,或\n) - 可选:设置

prefix/postfix添加固定内容

输入参数

| 参数 | 说明 |

|---|---|

prefix | 提示前缀 |

random_line_file1-4 | 从 4 个文件中各选一行 |

seed | 控制随机性 |

mode | Random Prompt 或 Static Prompt |

static_prompt | 固定提示模式下的输入 |

postfix | 提示后缀 |

delimiter | 连接符,如 , 或 \n |

clean_whitespace | 是否清理多余空格 |

🔁 修改文本文件后,刷新节点定义即可更新下拉菜单。

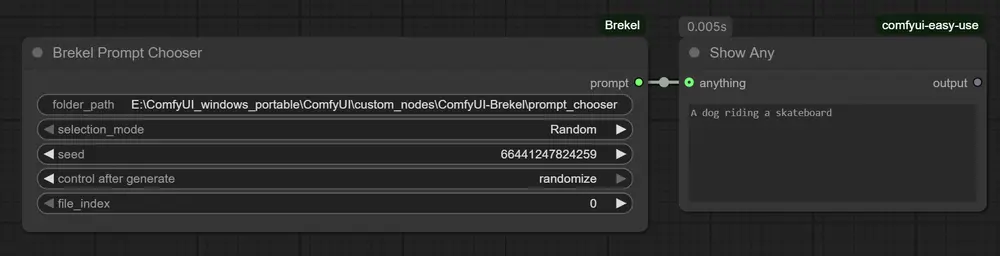

Brekel Prompt Chooser

在预设提示间快速切换

适合需要批量生成不同主题的场景,如制作系列插画、A/B 测试等。

使用方法

- 将

.txt文件放入:ComfyUI-Brekel/prompt_chooser/ - 每个文件包含一个完整提示,例如:

cat.txt:一只戴着巫师帽的猫,坐在图书馆里dog.txt:一只骑滑板的狗,在城市街道上飞驰

- 节点将根据模式选择文件内容

⚙️ 输入参数

| 参数 | 说明 |

|---|---|

folder_path | 提示文件夹路径(默认已设置) |

selection_mode | Random(随机)或 Index(按索引) |

seed | 随机模式下的种子 |

file_index | 索引模式下的文件编号(按字母排序) |

🔄 支持循环索引,超出数量时自动回绕。

适用场景

| 场景 | 推荐节点 |

|---|---|

| 快速扩写创意草稿 | Prompt Enhancer |

| 生成风格多样的系列图 | Auto Prompt Generator |

| 批量测试不同主题 | Prompt Chooser |

| 本地化、无网络提示增强 | Prompt Enhancer(本地 LLM) |

| 构建可复用提示库 | Auto Prompt Generator + Prompt Chooser |

设计理念:本地化、模块化、可扩展

Brekel 的节点设计遵循三大原则:

- 本地优先:所有 LLM 运行在本地,无需上传数据

- 模块化结构:每个节点职责清晰,可独立使用或组合

- 高度可定制:通过文本文件控制内容,易于维护与扩展

它不追求“一键生成万能提示”,而是提供工具链,让你用自己的方式掌控生成过程。

相关文章