DIT架构模型凭借其卓越的可扩展性,正逐步取代传统的 U-Net 架构,成为高保真图像与视频生成的主流模型。然而,其高昂的计算成本严重制约了在移动端、实时应用和大规模部署中的实用性。

为解决这一瓶颈,首尔大学研究团队提出 RALU(Region-Adaptive Latent Upsampling) —— 一种无需训练、即插即用的推理加速框架,通过沿空间维度引入混合分辨率策略,显著降低计算开销,同时最大限度保留生成质量。

该方法在 FLUX 模型上实现 7.0倍加速,在 Stable Diffusion 3 上实现 3.0倍加速,且视觉质量下降极小,为扩散变换器的实用化落地提供了高效解决方案。

问题背景:DiT 的性能瓶颈

尽管 DiT 在生成质量与模型扩展性方面表现优异,但其全分辨率自注意力机制导致计算复杂度随图像尺寸呈平方增长。现有加速方法多聚焦于时间维度优化(如缓存特征、跳步采样),对空间冗余的关注不足。

RALU 的核心洞察是:

并非所有图像区域都需要同等精度的早期计算。

例如,边缘、纹理密集区易出现伪影,需尽早高分辨率处理;而平坦背景区域可在低分辨率下完成大部分去噪过程。

技术创新:三阶段混合分辨率采样

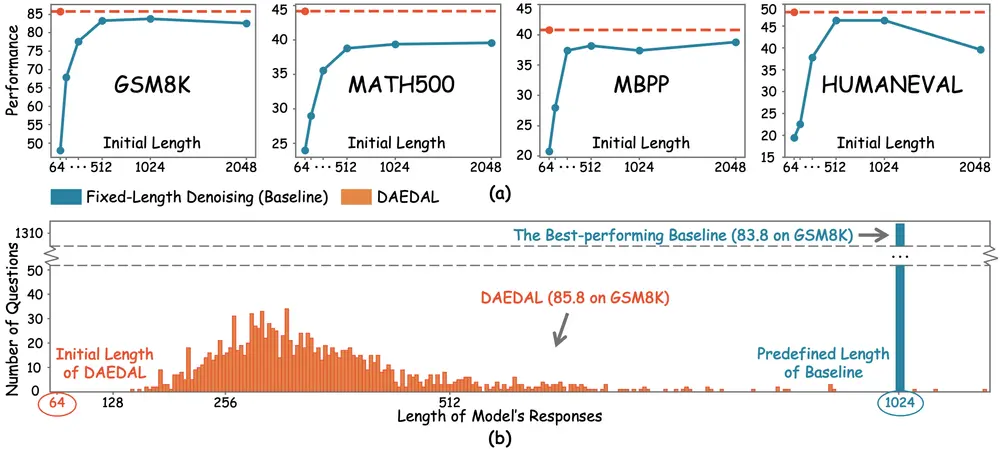

RALU 将去噪过程分为三个阶段,实现计算资源的动态分配:

1. 低分辨率去噪(Low-Res Denoising)

- 在 1/4 分辨率下完成前半段扩散去噪;

- 快速捕捉全局语义结构(如构图、主体位置);

- 显著减少注意力计算量。

2. 区域自适应上采样(Region-Adaptive Upsampling)

- 自动识别边缘与高频区域(如轮廓、发丝、文字);

- 对这些区域提前上采样至全分辨率,避免低分辨率下引入锯齿与模糊;

- 其余区域仍保持低分辨率继续去噪。

✅ 优势:精准投放算力,防止关键细节丢失。

3. 全分辨率细化(Full-Res Refinement)

- 在后期将剩余低分辨率潜在变量上采样;

- 完成最终的细节优化与一致性融合。

整个过程形成一个动态、自适应的空间计算流,兼顾效率与保真度。

核心机制:噪声-时间步重调度(NT-DM)

在不同分辨率间切换时,潜在空间的噪声分布会发生变化,可能导致生成不稳定或伪影。

为此,RALU 引入 Noise-Timestep Rescheduling with Distribution Matching (NT-DM):

- 根据目标分辨率调整噪声注入强度;

- 重新调度扩散时间步,使不同阶段的噪声水平平滑过渡;

- 确保跨分辨率生成的连贯性与稳定性。

该机制无需额外训练,完全基于推理时调度实现。

主要特点

| 特性 | 说明 |

|---|---|

| 无需训练 | 可直接应用于预训练 DiT 模型,零成本集成 |

| 空间维度优化 | 弥补现有时间维度加速方法的不足 |

| 区域自适应 | 智能识别关键区域,优先上采样 |

| 高质量保持 | FID、NIQE、CLIP-IQA 等指标显示质量损失极小 |

| 与缓存技术兼容 | 可与 Fast-DiT、SPEEDUP 等缓存方法叠加使用 |

测试结果:高效且稳定

| 模型 | 加速比 | 质量变化 |

|---|---|---|

| FLUX | 7.0× | FID 轻微上升,NIQE 与 CLIP-IQA 基本不变 |

| Stable Diffusion 3 | 3.0× | 视觉质量保持优秀,细节清晰 |

💡 在与缓存技术(如 KV Cache)结合后,总加速比进一步提升,推理延迟显著降低,适用于实时生成、视频合成等高吞吐场景。

相关文章