在使用 ComfyUI 进行 AI 图像生成的过程中,许多用户可能会遇到因 LoRA 模型键名格式不兼容而导致加载失败的问题。特别是通过 FAL.AI 等第三方平台训练生成的 LoRA 模型,其内部参数键名往往采用非标准命名方式,导致在 ComfyUI 或 ComfyUI-nunchaku 等环境中无法正常加载或运行。

为解决这一问题,社区开发者推出了 ComfyUI-RBG-LoRA-Converter —— 一个轻量但实用的 ComfyUI 自定义节点,专门用于将旧格式或非标准键名的 LoRA 模型转换为与当前 ComfyUI 版本兼容的标准格式。

核心功能

✅ 兼容性修复

自动识别并转换 LoRA 模型中的非标准键名(如 FAL.AI 输出模型中存在的键名偏差),修复其结构,确保模型可在 ComfyUI 中顺利加载和使用。

📦 批量处理

支持对单个 .safetensors 文件或整个目录下的多个 LoRA 模型进行批量转换,提升工作效率,尤其适合管理大量外部训练模型的用户。

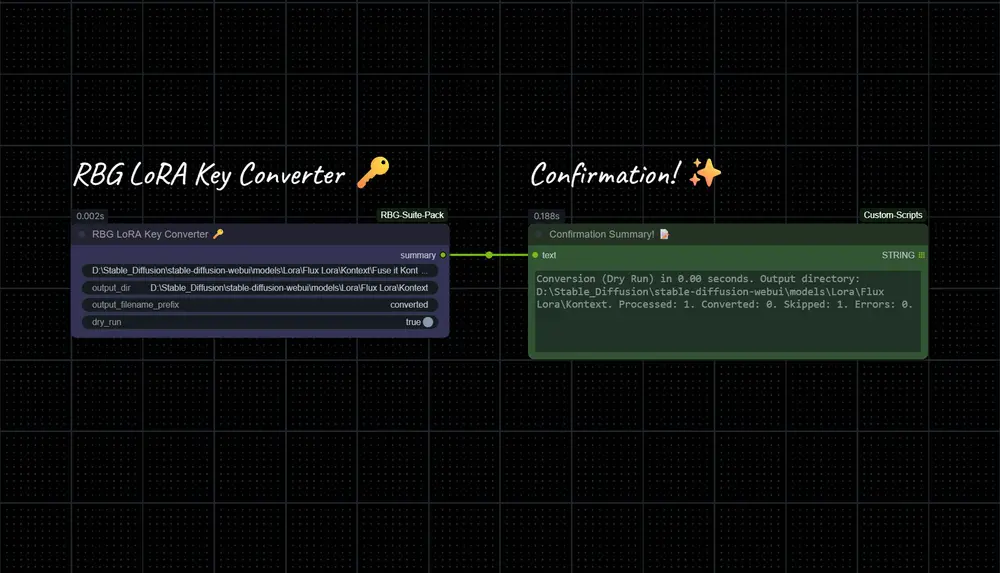

🔍 试运行模式(Dry Run)

提供“试运行”选项,在不修改原始文件的前提下模拟转换过程,预览将被处理的文件列表及键名变更情况,避免误操作。

📁 自定义输出路径

允许用户指定转换后文件的保存目录和文件名前缀,便于组织和区分原始模型与转换后版本。

⚠️ 智能错误处理

- 自动跳过已转换或格式正常的文件,避免重复操作。

- 记录转换过程中出现的异常或失败文件,便于后续排查。

安装步骤

1、将项目克隆至 ComfyUI 的自定义节点目录:

git clone https://github.com/RamonGuthrie/ComfyUI-RBG-LoraConverter.git

custom_nodes/ComfyUI-RBG-LoraConverter2、安装所需 Python 依赖:

cd custom_nodes/ComfyUI-RBG-LoraConverter

pip install -r requirements.txt3、重启 ComfyUI,使节点生效。

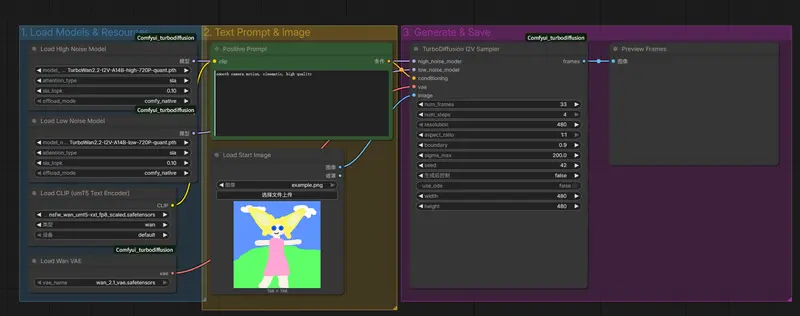

使用方法

安装完成后,在 ComfyUI 节点菜单中搜索或浏览以下路径:

RBG→RBGLoraKeyConverter

将 RBG LoRA Key Converter 节点添加到工作流中,并配置以下参数:

| 参数 | 说明 |

|---|---|

lora_path | 输入待转换的 LoRA 文件路径或包含多个模型的文件夹路径 |

output_directory | 指定转换后模型的输出目录(可选,默认为原路径) |

filename_prefix | 为输出文件添加前缀(如 converted_) |

dry_run | 勾选后仅模拟转换过程,不写入文件 |

运行节点后,系统将自动完成键名映射转换,并输出结果日志。

💡 适用场景

- FAL.AI 用户:将云端训练好的 LoRA 模型无缝迁移到本地 ComfyUI 环境。

- 模型共享与协作:统一团队内 LoRA 模型格式,提升兼容性。

- 老旧模型升级:适配旧版训练框架产出的 LoRA 模型,延长其可用生命周期。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...