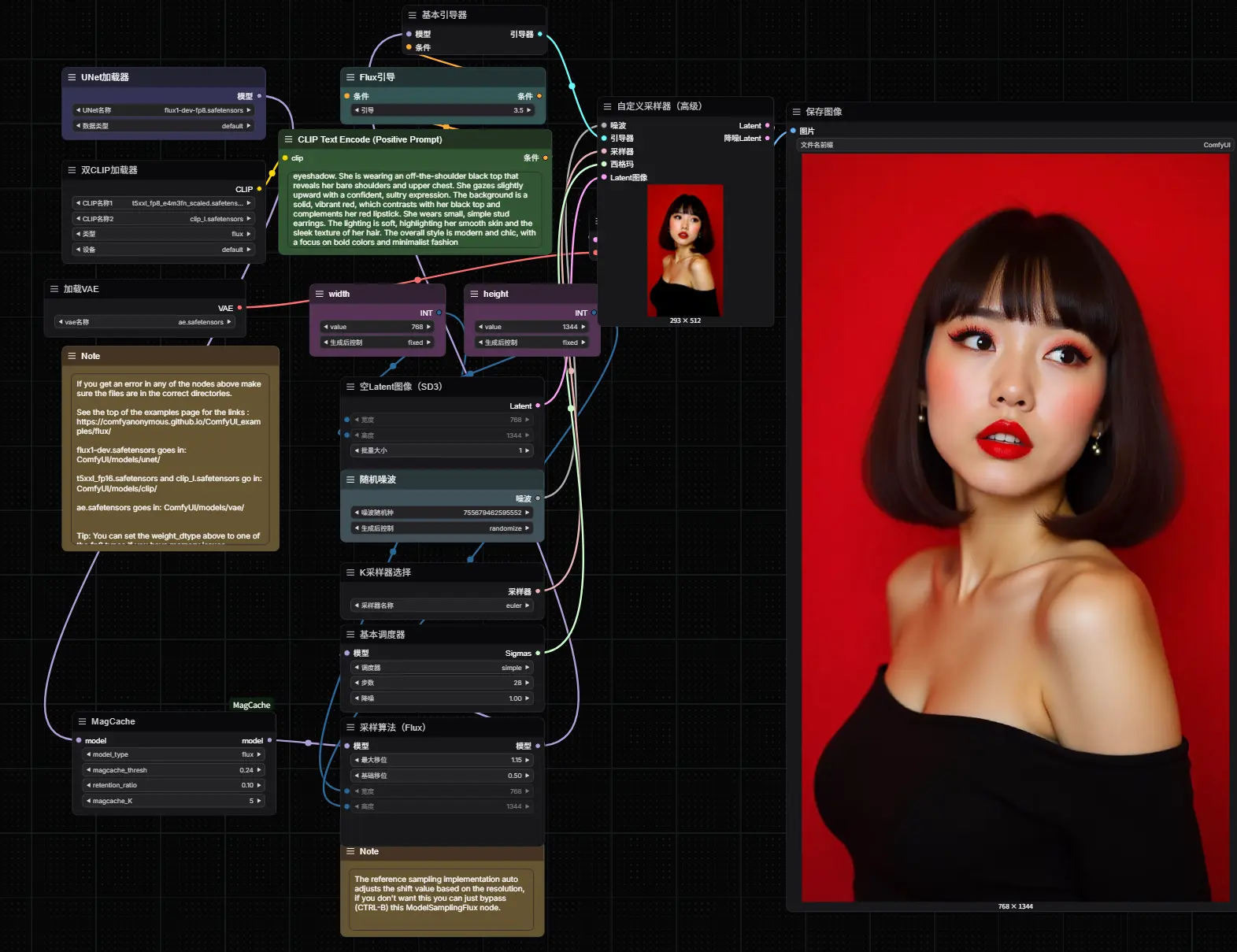

北京AI研究院发布的集成了视觉理解、文本到图像生成、指令驱动编辑和基于主体的上下文生成能力的统一多模态模OmniGen2,如果你希望在 ComfyUI 中实现图像生成、编辑和视觉理解任务,那么 ComfyUI-OmniGen2 是你不可或缺的工具。

这是一个非官方但功能完整的 ComfyUI 自定义节点包,专为 OmniGen2 模型设计,支持本地部署、参数调节和图形化流程编排,适合研究人员、创意工作者和 AIGC 爱好者。

什么是 OmniGen2?

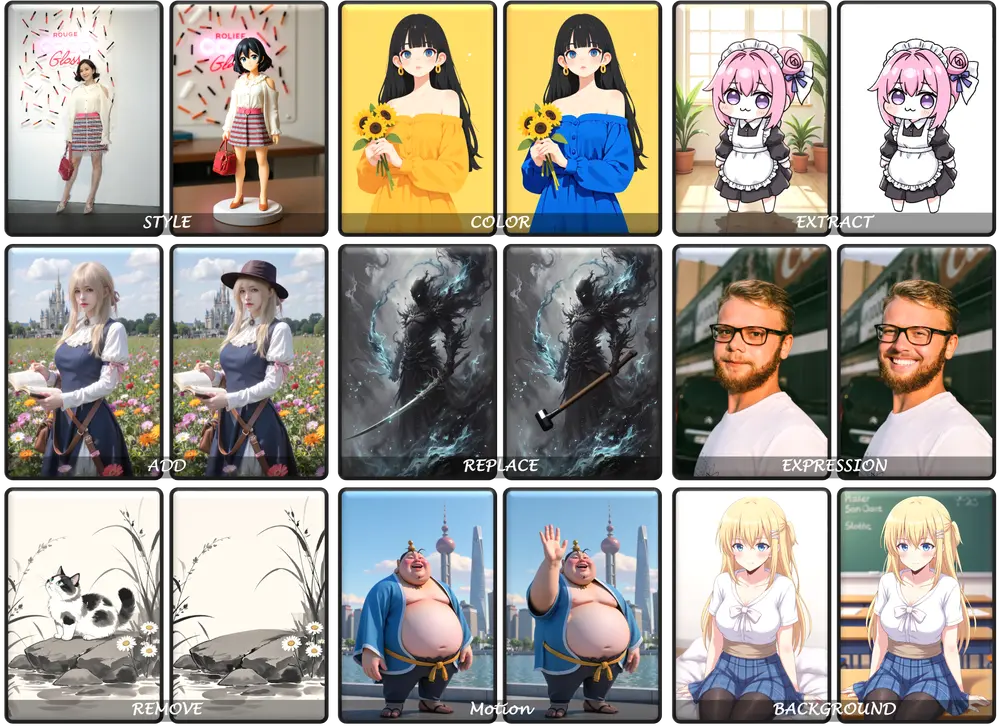

OmniGen2 是一款由北京AI研究院推出的统一多模态生成模型,具备以下核心能力:

- 视觉理解:解析图像内容,回答图像相关问题

- 文本到图像生成:根据提示词生成高质量图像

- 指令引导图像编辑:基于自然语言修改图像细节

- 上下文生成:结合多个图像和文本输入生成新图像

- 高效推理:支持 CPU/GPU 卸载、批量生成和内存优化

它采用了解耦式的文本/图像解码架构,并引入独立的图像 tokenizer,使得图像生成与编辑更加精准可控。OmniGen2 在多个生成任务中表现出色,是当前开源多模态模型中的佼佼者。

🔧 主要功能亮点

| 功能 | 描述 |

|---|---|

| 一键加载模型 | 支持从 HuggingFace 或本地路径自动下载并加载 OmniGen2 模型 |

| 低显存友好 | 提供顺序卸载(sequential offload)和模型卸载(model offload)选项,适用于 VRAM 不足设备 |

| 兼容性强 | 完全集成 ComfyUI 节点系统,支持 IMAGE 张量输入输出 |

| 多场景支持 | 支持文本到图像、图像编辑、上下文生成等多种任务 |

🛠️ 安装步骤

1. 下载模型

将 OmniGen2 模型文件放置于 models/omnigen2/ 文件夹下。你可以选择以下任意方式下载:

✅ 推荐方式一:Git LFS(HuggingFace)

cd models/omnigen2

git lfs install

git clone https://huggingface.co/OmniGen2/OmniGen2✅ 推荐方式二:HuggingFace CLI

pip install huggingface_hub

huggingface-cli download OmniGen2/OmniGen2 --local-dir OmniGen2 --local-dir-use-symlinks False✅ 国内用户推荐方式三:ModelScope

pip install modelscope

cd models/omnigen2

modelscope download --model OmniGen2/OmniGen2 --local_dir OmniGen2⚠️ 注意:模型文件夹名应与仓库 ID 最后一部分一致,例如

OmniGen2

2. 安装依赖项

确保已安装必要的 Python 包:

pip install -r requirements.txt如需进一步提升性能,建议安装 Flash Attention:

pip install flash-attn==2.7.4.post1 --no-build-isolation3. 重启 ComfyUI

完成上述步骤后,重启 ComfyUI,插件节点即可生效。

⚠️ 注意:该插件部分依赖项(如 torch、transformers)有特定版本要求,可能与其他插件存在冲突,请合理配置虚拟环境。

🎮 使用指南

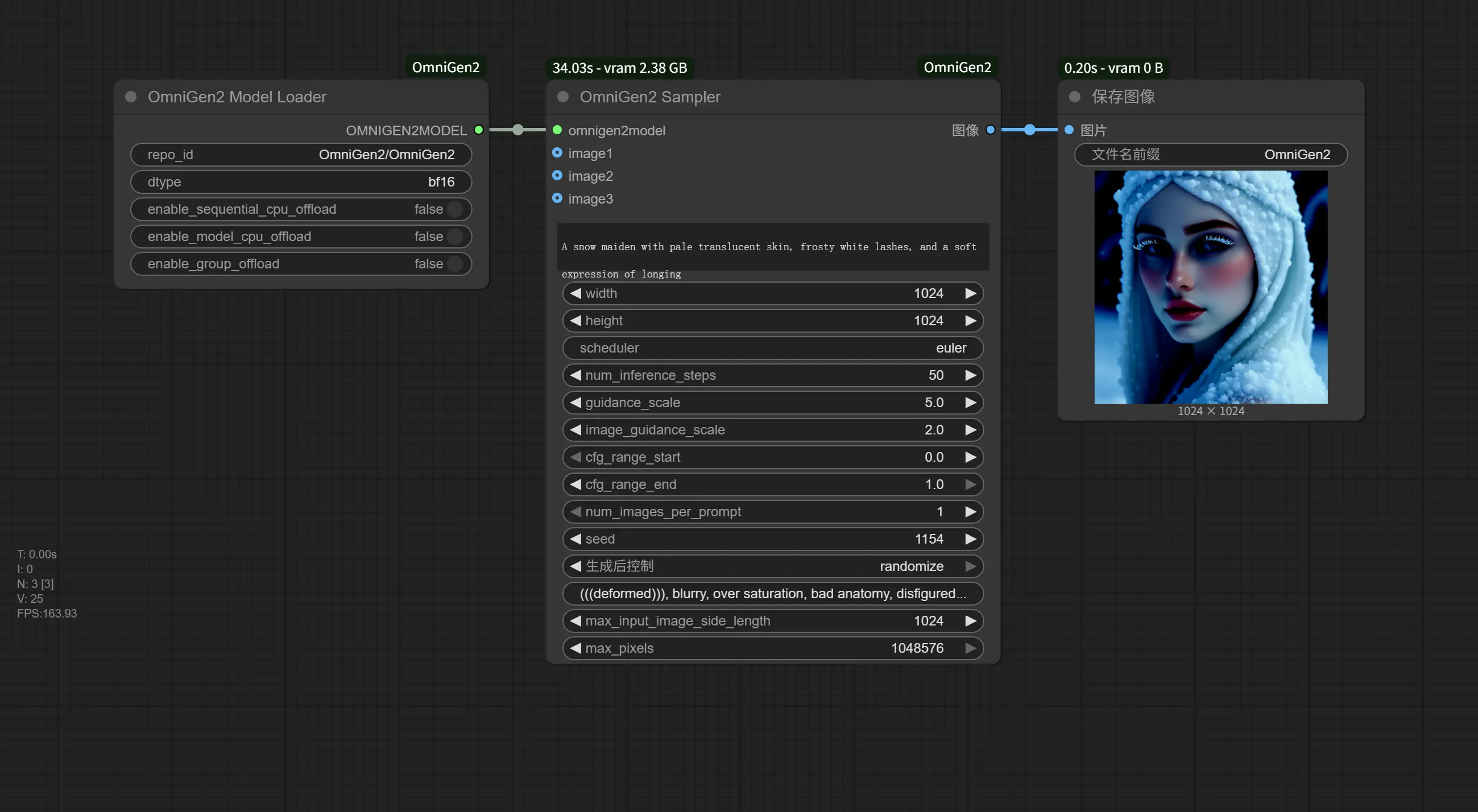

1. 文本到图像生成

- 输入文本提示(prompt)

- 设置目标图像大小

- 调整 CFG Scale 控制生成风格匹配度

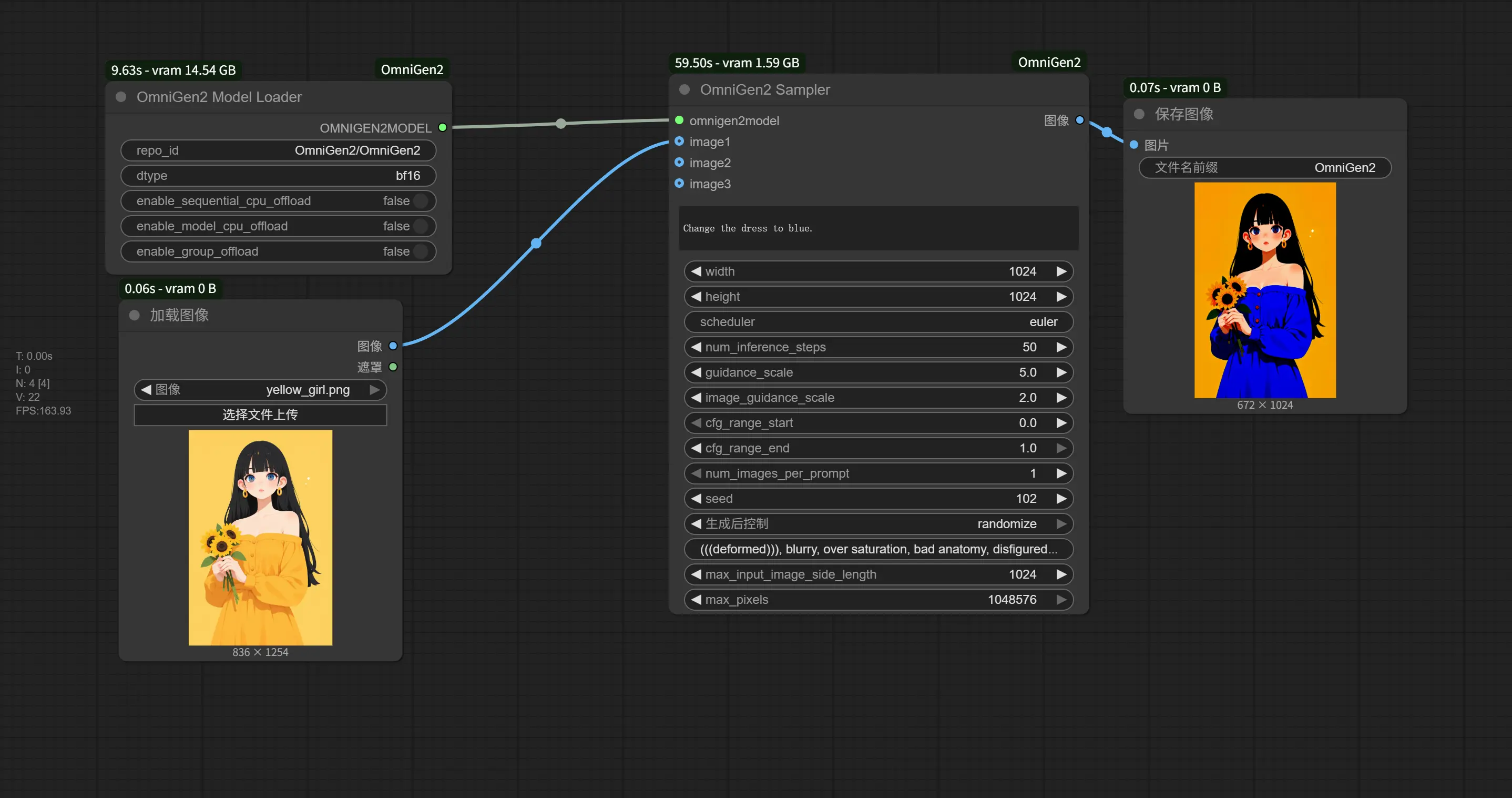

2. 图像编辑 / 上下文生成

- 向

OmniGen2Sampler节点提供最多 3 张输入图像(IMAGE 张量格式) - 使用自然语言描述所需的图像修改或组合方式

- 调整

image_guidance_scale参数以控制对原图的忠实程度(建议范围:1.2~3.0)

3. 视觉理解任务

- 可用于图像问答、内容分析等

- 具体用法请参考 OmniGen2 官方文档

📦 节点说明

OmniGen2ModelLoader

- 加载 OmniGen2 模型管道

- 支持 fp32、fp16、bf16 精度选择

- 自动检测本地是否存在模型,若无则尝试联网下载

OmniGen2Sampler

- 执行图像生成、编辑或上下文生成任务

- 支持最多 3 张输入图像(ComfyUI IMAGE 格式)

- 输出结果为标准 ComfyUI IMAGE 张量,可直接连接后续节点

- 内置图像尺寸调整与格式转换逻辑

🚀 性能调优建议

| 设置 | 建议 |

|---|---|

| 精度模式 | 推荐使用 BF16,兼顾速度与质量 |

| 显存不足时 | 开启 CPU Offloading 或 Model Offloading |

| 批量生成 | 设置 num_images_per_prompt > 1,自动生成拼贴图 |

| 图像引导强度 | 编辑任务建议 1.2~2.0;上下文生成建议 2.5~3.0 |

| 负向提示词 | 使用 negative_prompt 避免模糊、水印等问题 |

| 推理加速 | 适当降低 resolution 参数,在保证效果的前提下提高效率 |

🧪 故障排查

- 模型下载失败?

检查网络连接、代理设置或手动下载模型。 - 节点无法识别?

确保模型路径正确,且模型文件夹名称与 repo_id 匹配。 - 显存溢出?

尝试启用CPU Offloading或降低分辨率参数。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...