Freepik Tunes

Freepik Tunes 是一个创新的平台,提供由人工智能创作的免费音乐、画外音和音效生成工具,旨在帮助创作者轻松提升项目的音频体验。

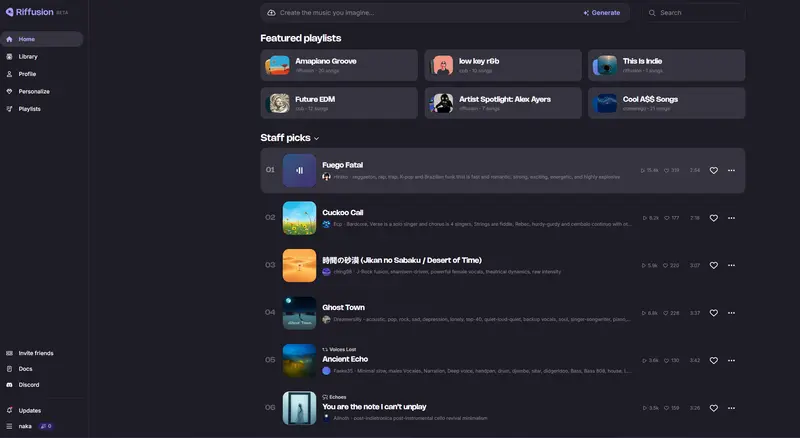

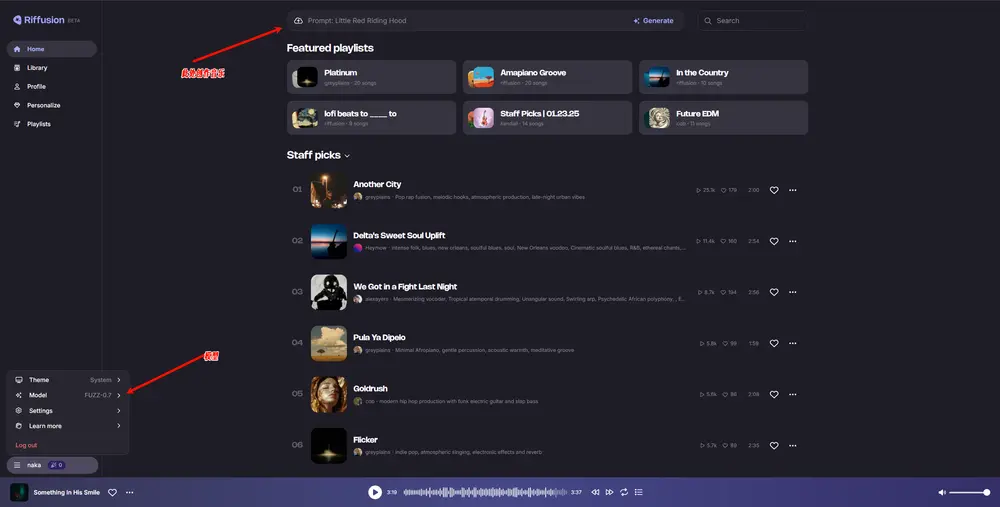

旧金山的AI初创公司Riffusion推出了一款创新性的免费AI音乐生成平台,使任何人都能利用AI技术创作原创音乐。Riffusion的新AI模型名为Fuzz,它能够基于文本描述、音频片段或视觉提示生成完整的歌曲,并且随着使用时间的增长,Fuzz能够学习用户的音乐偏好,提供越来越个性化的音乐体验。

特别的是,Fuzz通过“想象”并生成音频的声谱图(Spectrogram),再将其转换回可播放的音乐格式。声谱图是将声音的频率与时间用图像形式表示的方法,Riffusion采用类似Stable Diffusion的模型来“绘制”这些谱图,并转换为音频输出。

用户可以输入描述性提示(如音乐类型、乐器、情绪等),Fuzz将根据这些提示生成对应风格的声谱图和音乐。此外,Riffusion还支持在一个连续的音频流中从一个提示平滑过渡到另一个提示,例如从“爵士小号独奏”无缝切换到“电子舞曲节奏”。