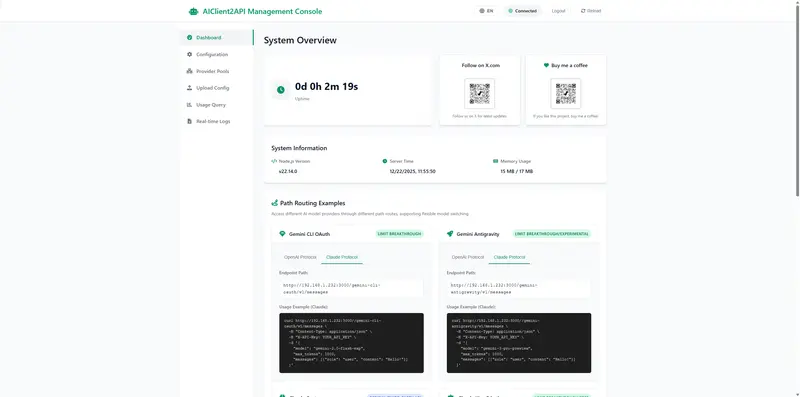

AIClient-2-API 是一款专为突破大模型使用限制打造的 API 代理服务,基于 Node.js 构建,能将 Gemini CLI、Antigravity、Qwen Code、Kiro 等原本仅限客户端使用的免费大模型,统一封装为标准的 OpenAI 兼容接口。无论是想免费调用 Claude Opus 4.5、Gemini 3.0 Pro 等高级模型,还是让 Cherry-Studio、NextChat 等工具无缝对接多平台模型,这款工具都能一站式解决,还内置高可用机制和可视化管理控制台,兼顾实用性与易用性。

核心优势:解决大模型使用的4大痛点

1. 统一接入,零成本迁移

- 多模型统一接口:通过标准 OpenAI 兼容协议,一次配置即可接入 Gemini、Claude、Qwen Code、Kimi K2、MiniMax M2 等主流大模型,无需为不同模型单独适配;

- 灵活切换方式:支持 Path 路由、启动参数、环境变量三种动态切换模型的方式,适配不同业务场景需求;

- 全兼容 OpenAI 规范:Cherry-Studio、NextChat、Cline 等依赖 OpenAI 接口的工具,无需修改一行代码即可直接使用;

- 跨协议智能转换:内置 OpenAI、Claude、Gemini 三大协议互转能力,实现跨协议调用不同模型(比如用 Claude 协议调用 Gemini 模型)。

2. 突破限制,免费用高级模型

- 绕过官方配额/速率限制:利用 OAuth 授权机制,突破 Gemini、Antigravity 等服务的免费 API 调用次数、速率限制;

- 免费使用高级模型:通过 Kiro API 模式免费调用 Claude Opus 4.5,通过 Qwen OAuth 模式使用 Qwen3 Coder Plus 代码模型,大幅降低大模型使用成本;

- 高可用保障:内置账号池管理,支持多账号轮询、自动故障转移和配置降级,确保服务可用性达 99.9%。

3. 安全可控,数据可追溯

- 全链路日志记录:捕获所有请求/响应数据,支持审计、调试,也可基于日志快速构建私有训练数据集;

- 系统提示词管理:支持“覆盖/追加”两种提示词模式,既能统一基础指令,又能实现个性化扩展;

- 权限与配置可控:所有关键配置可可视化管理,敏感信息(如 API Key)本地存储,无需上传第三方。

4. 开发友好,易扩展易部署

- Web UI 管理控制台:可视化完成配置管理、健康状态监控、API 测试、日志查看,无需手动改配置文件;

- 模块化架构:基于策略模式+适配器模式设计,新增模型提供商仅需 3 步(新增适配器、配置路由、接入控制台),扩展成本极低;

- 高测试覆盖率:集成测试+单元测试覆盖率 90%+,保证功能稳定性;

- 容器化部署:提供 Docker/Docker Compose 支持,一键部署,跨 Linux/macOS/Windows 平台运行。

快速部署:3种方式,新手也能上手

方式1:Docker 快捷启动(推荐)

一行命令即可启动,自动映射所需端口,配置目录持久化不丢失:

docker run -d \

-p 3000:3000 \ # Web UI 控制台端口

-p 8085-8087:8085-8087 \# OAuth 回调端口(Gemini:8085、Antigravity:8086、iFlow:8087)

-p 1455:1455 \ # Codex 回调端口

-p 19876-19880:19876-19880 \# Kiro 回调端口

--restart=always \ # 容器异常自动重启

-v "/home/user/aiclient-configs:/app/configs" \ # 替换为实际路径,持久化配置

--name aiclient2api \

justlikemaki/aiclient-2-api

方式2:Docker Compose 部署(适合自定义构建)

# 进入 docker 目录(需先克隆项目)

cd docker

# 创建配置目录

mkdir -p configs

# 启动(使用预构建镜像)

docker compose up -d

# 如需从源码构建,先修改 docker-compose.yml:

# 1. 注释 image: justlikemaki/aiclient-2-api:latest

# 2. 取消 build: 部分注释

# 3. 执行构建并启动

docker compose up -d --build

方式3:脚本一键启动(Linux/macOS/Windows)

无需手动装依赖,脚本自动完成环境检查、依赖安装、服务启动:

# Linux/macOS

chmod +x install-and-run.sh && ./install-and-run.sh

# Windows

双击运行 install-and-run.bat

启动后验证

脚本/容器启动成功后,打开浏览器访问:http://localhost:3000

默认登录密码:admin123(登录后可在控制台或修改 pwd 文件修改密码)

核心功能:可视化管理+丰富的模型能力

1. Web UI 管理控制台(核心操作入口)

控制台集成全量管理功能,无需懂代码也能配置:

- 📊 仪表盘:系统概览、交互式路由示例、客户端对接指南,快速上手;

- ⚙️ 配置管理:可视化填写各提供商 API Key/上传 OAuth 凭据,实时切换默认模型,支持高级参数配置;

- 🔗 提供商池:监控各模型提供商的活动连接、健康状态,一键启用/禁用某一提供商;

- 📁 配置文件:集中管理 OAuth 凭据文件,支持搜索、过滤、下载/删除;

- 📜 实时日志:查看系统日志、请求日志,支持日志筛选、清空,方便排查问题;

- 🔐 登录验证:默认密码可自定义,保障控制台访问安全。

2. 多模态输入支持

支持图片、文档等多种格式输入,比如上传图片调用 Gemini 3 Pro 进行图文理解,上传代码文件让 Qwen3 Coder Plus 分析优化,适配更多应用场景。

3. 最新模型无缝支持

已适配当前主流高级模型,仅需在控制台配置对应端点即可使用:

- Claude 4.5 Opus:Anthropic 旗舰模型,通过 Kiro、Antigravity 渠道支持;

- Gemini 3 Pro:Google 下一代架构预览版,通过 Gemini、Antigravity 渠道支持;

- Qwen3 Coder Plus:阿里通义千问最新代码专用模型,通过 Qwen Code 渠道支持;

- Kimi K2 / MiniMax M2:国内顶级旗舰模型,通过自定义 OpenAI/Claude 协议支持。

关键使用提示

- 端口说明:除 3000 端口(Web UI)外,8085-8087、1455、19876-19880 为 OAuth 回调端口,需确保宿主机这些端口未被占用,且公网可访问(用于完成 OAuth 授权);

- 配置持久化:Docker 部署时务必挂载

configs 目录,否则容器重启后配置会丢失; - 密码修改:首次登录后建议立即修改默认密码,避免未授权访问;

- 模型适配:不同模型的 OAuth 凭据获取方式不同(如 Gemini 需要 Google 账号授权,Kiro 需要对应平台凭据),可参考控制台内的“配置指南”操作。