视频一直是一种被动媒介——录制、播放、结束。

但如果我们能打破这种单向关系?如果一段视频不仅能被观看,还能被实时影响、对话甚至共同创造?

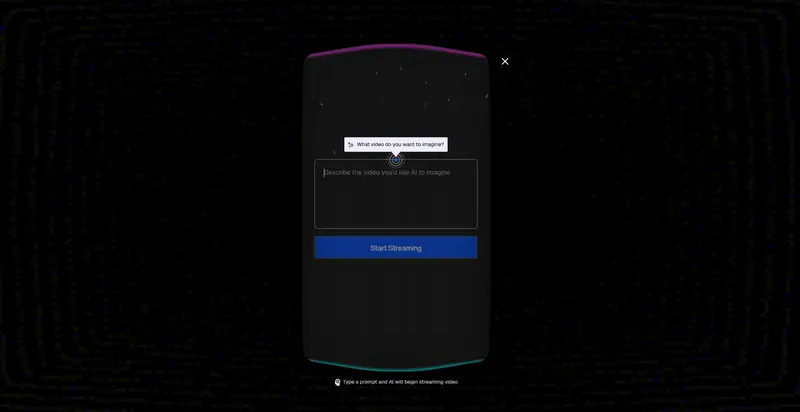

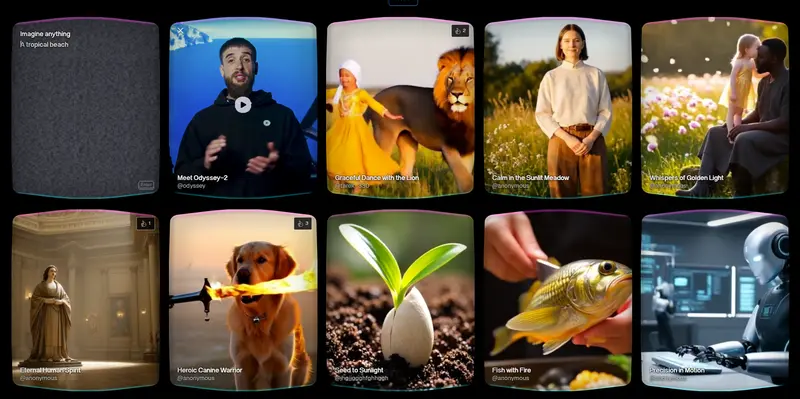

Odyssey-2 正是朝着这个方向迈出的关键一步。它不是一个传统的视频生成模型,而是一个即时、因果、自回归的互动视频系统,让你像与语言模型对话一样,用文字或语音去塑造正在发生的画面。

输入一句话,视频立刻响应。改变想法,画面随之演变。没有预设结局,只有持续演进的视觉流。

这,就是互动视频的开始。

什么是互动视频?

传统AI视频模型是“离线”的:你输入提示,等待几十秒甚至几分钟,得到一段固定长度的剪辑。过程不可中断,结果无法修改。

Odyssey-2 不同。它构建的是一个连续的、行动感知的视频流:

- 你输入:“一只狐狸在雪地里奔跑。”

- 视频开始生成:雪地上出现狐狸,脚步扬起雪花。

- 你追加:“它突然听到远处有声音,停下回头。”

- 模型立即调整:狐狸耳朵竖起,身体转向,眼神警觉。

- 你再问:“树后藏着什么?”

- 画面继续演化:树枝晃动,一只小鹿缓缓走出……

整个过程无需重新生成,视频像生命体一样,根据你的每一条指令实时演化。

核心技术:因果自回归视频生成

要实现真正的互动,模型必须放弃对“未来”的预知。

大多数视频模型依赖全局上下文——知道开头和结尾,才能平滑过渡中间帧。但这意味着它们无法应对突发的用户输入。

Odyssey-2 采用因果自回归架构:

- 每一帧只基于过去的所有帧 + 用户最新输入生成。

- 它不知道接下来会发生什么,只能像人一样“边看边想”。

- 这种机制使其成为隐式的物理世界模拟器:它必须理解运动、光照、碰撞、流体等动态规律,才能合理预测下一刻。

例如,在生成海浪时,模型会从波纹的曲率和速度场推断出波峰如何推进、泡沫如何漂移——这一切都源于对数十年真实视频数据的学习。

极致速度:50毫秒/帧,20 FPS 实时流

互动感的核心是低延迟。

传统双向视频模型生成5秒素材需1–2分钟,而 Odyssey-2 能以每50毫秒生成一帧的速度持续输出,达到接近20 FPS的流畅度。

这意味着:

- 输入后几乎零等待即可看到画面变化。

- 多轮交互无缝衔接,形成连贯体验。

- 可部署于屏幕、VR设备或移动终端,实现实时交互。

这一性能得益于对模型架构、数据管道和推理栈的全链路优化,在保持高保真度的同时,实现了前所未有的响应速度。

不只是娱乐:迈向通用世界模拟器

Odyssey-2 的意义远超“会动的视频”。

通过学习“下一帧预测”,它正在内化物理世界的运行规则。这种能力将催生全新的应用场景:

| 领域 | 应用示例 |

|---|---|

| 教育 | 与爱因斯坦“对话”学物理;实时演示化学反应 |

| 语言学习 | 走进虚拟巴黎街头,与AI居民练习法语 |

| 培训 | 模拟紧急医疗场景,训练医生应变能力 |

| 创作 | 实时导演AI电影,边说边生成镜头 |

| 游戏 | 动态生成剧情分支,NPC真正“听懂”玩家 |

| 记忆重现 | “走进”老照片,重访童年场景 |

这些体验不再是预设脚本的播放,而是由用户意图驱动的新兴媒体(Emergent Media)。

未来方向

Odyssey-2 仍处于早期阶段,但它揭示了一个清晰的方向:

- 结合 Odyssey-1 的长期记忆与导航能力,实现更持久的交互叙事。

- 支持音频输入与输出,实现语音直接对话。

- 推出 API 接口,供开发者构建自己的互动应用。

数据统计

相关导航

Remotion

Mirage Studio

Flow

Saga

Gaga AI

Marble

Boba Anime Studio