AI2(艾伦人工智能研究所)正式推出 Ai2 Paper Finder——一款由大语言模型(LLM)驱动的文献搜索系统。它不同于传统工具,核心是“模仿人类研究者的思考与搜索过程”,能定位Semantic Scholar、Google Scholar等工具难找到的小众论文,为科研人员节省大量时间,同时已开源冻结快照版本供社区使用。

核心定位:为什么需要“像人一样思考”的文献搜索工具?

传统文献搜索工具存在明显局限:要么依赖关键词匹配(易遗漏相关论文),要么只返回热门结果(小众研究线索难覆盖)。而人类研究者的搜索逻辑是“迭代式学习”:先通过初始关键词找线索,再从结果中提炼新术语、追踪引文、调整方向,最终覆盖核心与边缘研究。

Ai2 Paper Finder 正是复刻了这一过程,解决两大核心问题:

- 实际价值:为研究者节省数小时到数周的搜索时间,避免错过关键小众论文(如某领域早期探索性研究);

- 学术价值:探索LLM代理的“长期过程建模”“目标导向学习”等前沿问题,推动人机交互与科研工具的技术突破。

与传统工具的核心差异:不止于“找论文”,更要“找全、找对”

Ai2 Paper Finder 与现有文献工具(如Perplexity、Ai2 ScholarQA、Undermind)的差异,主要体现在开放性、搜索范围、结果用途三个维度,具体对比如下:

| 对比维度 | Ai2 Paper Finder | 其他工具参考(如Perplexity、Ai2 ScholarQA) |

|---|---|---|

| 开放性 | 1. 开源冻结快照版本; 2. 即将发布详细技术报告; 3. 计划公开用户查询流(用户授权后) | 多为闭源工具,技术细节透明度较低,仅提供查询结果 |

| 搜索范围 | 兼顾“热门核心论文”与“小众难寻论文”,通过迭代学习覆盖边缘线索 | 多聚焦热门结果,优先返回高引用、近期发表的论文,小众研究覆盖不足 |

| 结果用途与形式 | 1. 输出论文列表(含相关性理由); 2. 追求结果全面性,适合深入已知领域 | 1. 部分工具输出“研究摘要”(如Ai2 ScholarQA),提供领域概览; 2. 允许忽略部分论文,适合了解新主题 |

| 核心目标 | 找到“全面且精准匹配需求”的论文集 | Perplexity等侧重“快速获取关键信息”,Undermind虽同追全面性,但社区协作机制不同 |

实际体验:从“关键词搜索”到“自然语言需求”,一个查询能做什么?

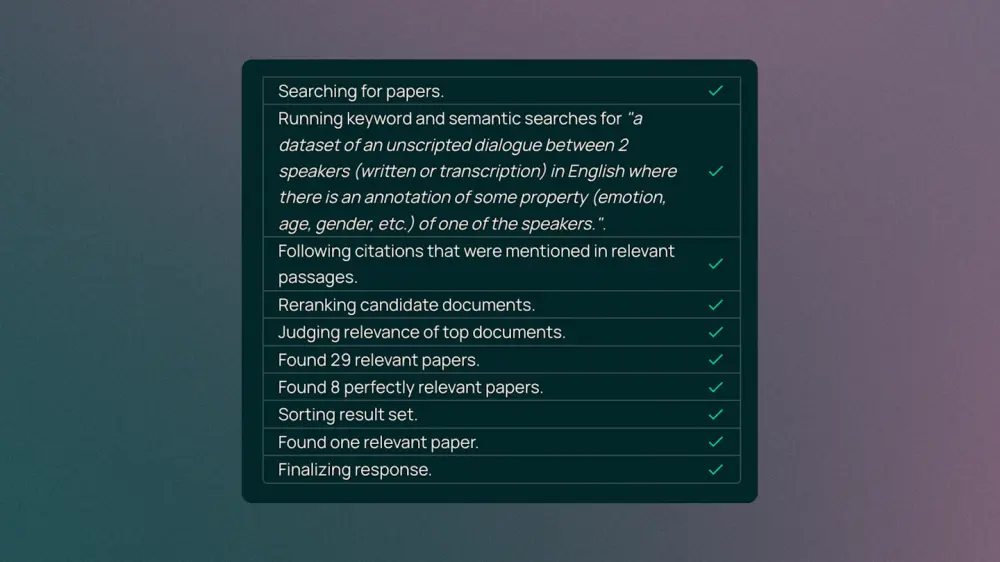

传统工具需要精准关键词(如“non-scripted English dialogue dataset speaker attribute annotation”),而 Ai2 Paper Finder 支持自然语言完整需求,以“寻找特定对话数据集论文”为例:

- 输入需求:直接输入“介绍两个英语演讲者之间非脚本对话(书面或转录)数据集的论文,其中一个演讲者的某些属性(情感、年龄、性别等)有注释”;

- 系统自动处理:

- 先分解需求为子标准:“非脚本对话数据集”“英语场景”“演讲者属性注释”“对话与注释关联”;

- 初始搜索:生成多版改写 query,调用语义索引与Semantic Scholar API,筛选候选论文;

- 迭代深化:追踪候选论文的前向/后向引文,补充新 query 再次搜索,直到找到足够相关结果;

- 输出结果:返回论文列表,每篇论文附带“符合哪些子标准”的详细理由(如“该论文的3.2节提到英语非脚本对话转录,表1标注了演讲者年龄属性”),方便快速判断相关性。

技术解析:从查询到结果,系统如何“模仿人类思考”?

Ai2 Paper Finder 的核心是“半固定流程+LLM决策干预”,单轮搜索(从查询到结果)分为5大核心步骤,以下为高层级解析(细节见后续技术报告):

1. 第一步:查询分析——拆解需求,明确目标

由“查询分析器”将用户需求拆解为结构化信息,例如:

- 搜索目标:找“一组论文”(如“公平性开源LLM基准”)还是“特定论文”(如“OLMo论文”);

- 约束条件:是否含元数据(作者、年份、期刊)、语义标准(如“内存效率优化”)、特质要求(“近期”“经典”);

- 最终输出:打包为数据结构,传递给“查询规划器”。

2. 第二步:查询规划——制定搜索策略

“查询规划器”(路由器)根据分析结果,选择预定义的子流程,常见子流程包括:

- 特定论文搜索:针对“找某篇已知论文”的需求;

- 语义+元数据搜索:针对“含作者/年份约束的主题搜索”;

- 纯元数据查询:针对“找某作者近3年发表的论文”等需求。

3. 第三步:子流程执行——多来源获取候选论文

不同子流程对应不同“子代理”,以核心的“语义搜索子流程”为例:

- LLM生成多版 query 改写,分别调用3个不同属性的语义索引;

- 同步调用Semantic Scholar API进行关键词补充搜索;

- 提取搜索结果片段中的引文,将高被引论文加入候选池;

- 按论文分组片段,LLM判断每篇候选论文的相关性(见步骤4),未找到足够结果则重复“改写 query→追踪引文→判断相关性”流程。

4. 第四步:相关性判断——精准筛选,避免遗漏

这是系统的“关键优化点”,LLM会先将用户需求拆分为多个语义子标准(如前文的对话数据集案例),再逐一验证候选论文:

- 输入给LLM的信息:论文标题、摘要、搜索片段(含章节标题)、引用该论文的片段;

- LLM输出:每篇论文符合“哪些子标准”“不符合哪些”,最终给出相关性得分与判断理由。

同时,为减少LLM调用成本与时间,系统采用“批处理多臂赌博机”模型:优先对“更可能相关”的候选论文(如高语义相似度、多来源推荐)进行判断,大幅提升效率。

5. 第五步:结果重排与模式选择——平衡速度与质量

- 结果重排:结合“语义相关性得分”与“元数据权重”(如“近期”需求会提高年份权重,“经典”需求会提高引用量权重),生成最终排序;

- 双模式切换:

- 快速模式(默认):减少 query 改写与迭代次数,1-2分钟出结果,满足80%常规查询需求;

- 全面模式:触发完整迭代流程(多轮搜索+引文追踪),适合“找小众论文”“需要全面结果”的场景,可通过 query 中加“广泛论文集”或点击“更努力工作”启用。

性能表现:89%查询能找到完全相关论文

Ai2 Paper Finder 在学术基准与内部测试中表现优异:

- LitSearch基准测试:在Semantic Scholar数百万篇论文中搜索(比基准默认的6.4万篇更具挑战性),89%的查询能找到“完全相关论文”,98%能找到“高度相关论文”;

- 快速模式表现:完全相关率85%,高度相关率97%,速度提升50%以上,兼顾效率与质量;

- 内部使用反馈:AI2团队日常使用中,在“传统工具搜不到”的场景(如找早期小众研究),准确率显著高于Semantic Scholar与Google Scholar。

未来计划:更动态、更交互、更智能

目前 Ai2 Paper Finder 仍处迭代初期,后续重点优化方向包括:

- 元数据查询优化:提升“按作者/年份/期刊筛选”的精准度,解决当前元数据处理不足的问题;

- 攻克复杂语义查询:针对“用户无专业术语”“长段落需求”“多标准分散在论文不同部分”“数值范围/否定需求”(如“不讨论种族的公平性论文”)等场景,优化LLM的需求理解能力;

- 强化多轮交互:支持“基于结果调整需求”(如“这些论文很好,再找内存效率相关的”),实现搜索历史关联与个性化推荐;

- 动态流程升级:将更多决策交给LLM,减少固定流程限制(如支持“同时找BERT与RoBERTa相关论文”这类多目标查询);

- 构建科研助手生态:远期计划覆盖“论文查找→文献管理→实验设计→统计分析”全科研链路,打造代理化科研助手。

数据统计

相关导航

SlideBot AI

MyHair

Rust LLM from Scratch

Station

OpenAI Frontier

qqqa

OpenChatBI