随着 AI 代理在企业中的广泛应用,如何准确评估其性能,已成为继“部署”之后的核心挑战。

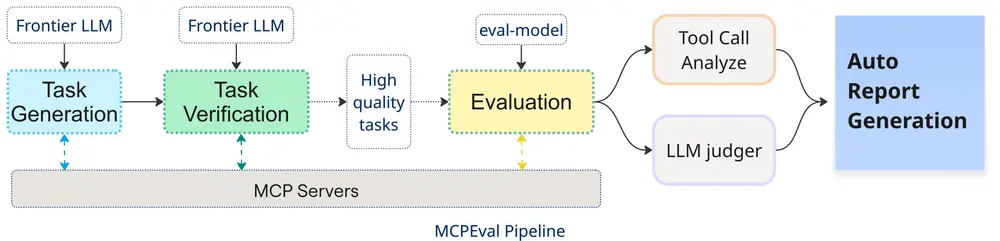

Salesforce 研究团队近日推出 MCPEval——一个基于 模型上下文协议(Model Context Protocol, MCP) 架构的开源评估工具包,为 AI 代理提供自动化、可迭代、环境一致的性能测试方案。它不仅是一个评测框架,更是一个“即插即用”的代理质量保障系统。

为什么需要 MCPEval?现有评估方式的局限

当前,大多数 AI 代理评估依赖于静态、预定义的任务,例如让代理完成一组固定指令并判断“成功”或“失败”。这种方式存在明显短板:

- 无法模拟真实世界中动态、交互式的工作流;

- 难以捕捉代理在复杂工具调用中的行为细节;

- 缺乏可复用的轨迹数据,无法用于后续模型优化。

Salesforce 高级 AI 研究经理、论文作者 Shelby Heinecke 指出:

“我们已经过了‘如何部署代理’的阶段,现在需要解决的是:如何正确评估它们。”

MCP 作为连接 AI 与工具的标准协议,正在被广泛采用。而 MCPEval 的创新之处在于——利用 MCP 本身来评估基于 MCP 运行的代理。

MCPEval 的核心能力

MCPEval 并非简单的打分工具,而是一套完整的评估闭环,具备三大核心优势:

1. 完全自动化:从任务生成到报告输出

- 用户选择目标 MCP 服务器及其中的工具;

- MCPEval 利用大型语言模型(LLM)自动生成测试任务;

- 系统自动验证任务逻辑,并确定“理想工具调用路径”作为基准;

- 代理执行任务,系统记录完整交互轨迹;

- 最终生成结构化评估报告,涵盖成功率、工具调用准确性、通信合规性等维度。

整个流程无需人工干预,实现“配置即测试”。

2. 深度行为可见性:不只是“成不成功”

传统评估止步于结果,而 MCPEval 提供全过程行为洞察:

- 代理是否调用了正确的工具?

- 工具参数是否准确?

- 与 MCP 服务器的通信是否符合协议规范?

- 是否存在冗余或无效调用?

这些数据不仅能用于评分,更能定位性能瓶颈,为模型微调提供高质量训练样本。

3. 可迭代优化:评估即训练

MCPEval 收集的高质量任务轨迹可直接用于:

- 快速微调代理模型;

- 构建领域专用的评估数据集;

- 持续监控代理在生产环境中的表现。

Heinecke 将其定位为“评估与修复代理的一站式解决方案”。

工作原理:基于 MCP 的闭环评估

MCPEval 的框架设计包含三个阶段:

- 任务生成与验证

- 使用 LLM(用户可自选)生成符合 MCP 语义的多样化任务;

- 自动生成“黄金标准”工具调用序列。

- 代理执行与轨迹收集

- 代理在真实 MCP 服务器环境中执行任务;

- 系统记录每一步的输入、输出、工具调用和返回结果。

- 评估与报告生成

- 将代理行为与“黄金标准”对比;

- 输出包含成功率、错误类型分布、协议合规性等指标的综合报告。

与其他评估框架的对比

| 框架 | 机构 | 侧重点 | 特点 |

|---|---|---|---|

| MCPEval | Salesforce | 协议级交互 | 基于 MCP,自动化生成任务,提供深度行为分析 |

| MCP-Radar | UMass Amherst & 西安交通大学 | 通用技能评估 | 聚焦软件工程、数学等通用领域,强调效率与准确性 |

| MCPWorld | Beijing University of Posts and Telecommunications | GUI 与系统级代理 | 支持图形界面、API 调用等复杂计算机使用场景 |

| AgentSpec | 新加坡管理大学 | 可靠性监控 | 提供代理行为规范与监控机制 |

| Galileo | 初创公司 | 工具选择质量 | 评估代理在多工具环境下的决策能力 |

MCPEval 的独特之处在于,它将测试环境与部署环境统一——代理在哪个 MCP 服务器上运行,就在哪个环境中被评估,确保了测试的真实性。

数据统计

相关导航

AbletonMCP

MCP课程

Recraft MCP Server

MCP Gateway

VibeVideo-MCP

UltraRAG

Data Commons MCP