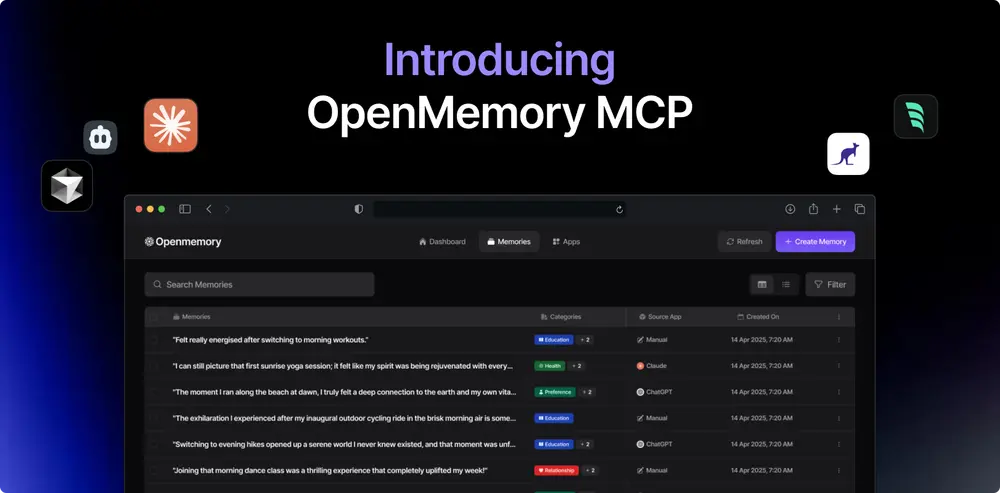

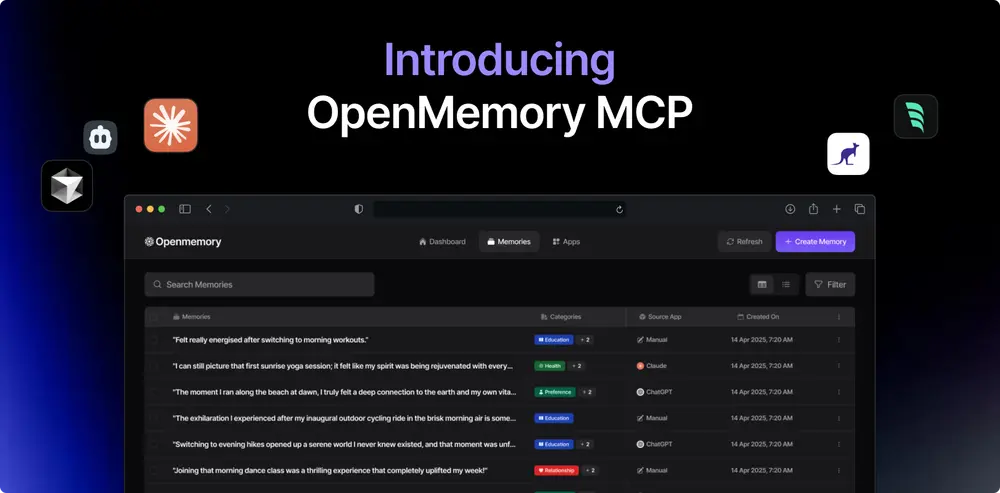

OpenMemory 是一个由 Mem0 驱动的本地内存基础设施,允许您将内存带到任何 AI 应用中。它提供了一个统一的内存层,始终与您同在,使代理和助手能够在不同应用间记住重要内容。

什么是 OpenMemory MCP 服务器

OpenMemory MCP 服务器是一个私有的、以本地优先的内存服务器,为支持 MCP 的工具创建共享的、持久的内存层。它完全运行在您的设备上,支持工具间无缝的上下文传递。无论您是在开发、规划还是调试环境中切换,您的 AI 助手都可以访问相关内存,无需重复指令。

OpenMemory MCP 服务器确保所有内存保持本地化、结构化,并由您完全控制,不涉及云同步或外部存储。

OpenMemory MCP 服务器的工作原理

基于模型上下文协议(MCP)构建,OpenMemory MCP 服务器提供了一套标准化的内存工具:

- add_memories:存储新的内存对象

- search_memory:检索相关内存

- list_memories:查看所有存储的内存

- delete_all_memories:完全清除内存

任何支持 MCP 的工具都可以连接到该服务器,并使用这些 API 来持久化和访问内存。

它能实现什么

跨客户端内存访问

在 Cursor 中存储上下文,稍后在 Claude 或 Windsurf 中检索,无需重复说明。

完全本地化的内存存储

所有内存存储在您的设备上,不上传至云端,您完全拥有和控制数据。

统一的内存界面

内置的 OpenMemory 仪表板提供了一个集中的存储内容视图,可直接从仪表板添加、浏览、删除和控制客户端的内存访问。

支持的客户端

OpenMemory MCP 服务器兼容任何支持模型上下文协议的客户端,包括:

- Cursor

- Claude Desktop

- Windsurf

- Cline 等。

随着更多 AI 系统采用 MCP,您的私有内存将变得更有价值。

现实世界的应用示例

场景 1:跨工具项目流程

在 Claude Desktop 中定义项目的技术需求,在 Cursor 中进行开发,在 Windsurf 中调试问题——所有这些都通过 OpenMemory 共享上下文。

场景 2:持久化的偏好设置

在一个工具中设置您偏好的代码风格或语气,切换到另一个 MCP 客户端时,无需重新定义即可访问这些偏好。

场景 3:项目知识

只需保存一次重要项目细节,即可从任何兼容的 AI 工具访问,无需重复解释。

结论

OpenMemory MCP 服务器为支持 MCP 的工具带来了内存支持,同时不牺牲控制权或隐私。它解决了现代 LLM 工作流程中的一个基础限制:跨工具、会话和环境的上下文丢失。

通过标准化内存操作并保持所有数据本地化,它减少了 token 开销,提高了性能,并在大规模增长的 AI 助手生态系统中解锁了更智能的交互。

这只是开始。MCP 服务器是 OpenMemory 平台的第一核心层——这是一个旨在使内存在 AI 系统中便携、私有和互操作的更广泛努力。

数据统计

相关导航

MCP安全检查清单

Office-PowerPoint-MCP-Server

PixVerse MCP

Recraft MCP Server

Chrome DevTools MCP

mcpo

阿里云百炼MCP