Oreate

百度在海外推出 Oreate——专为专业人士、学生和研究者打造的一站式 AI 工作空间。只需一键,即可生成专业排版、来源准确、图表精美的幻灯片、研究报告和学术论文。从商业提案到学术研究,从营销方案到旅行指南,Oreate 通通轻松搞定。Oreate 用 3 分钟完成原本需要 3 天的工作,让你轻松做出百万美元专家级别的幻灯片和报告。

由 Mozilla AI 推出的 Wasm-Agents Blueprint,正在探索一种全新的 AI 代理部署方式 —— 在浏览器中直接运行 AI 代理,无需额外依赖或本地安装。

由 Mozilla AI 推出的 Wasm-Agents Blueprint,正在探索一种全新的 AI 代理部署方式 —— 在浏览器中直接运行 AI 代理,无需额外依赖或本地安装。

该项目仍处于实验阶段,但已展现出巨大潜力。它通过 WebAssembly(WASM)和 Pyodide 技术,将 Python 编写的 AI 代理打包为单个 HTML 文件,用户只需打开网页即可运行完整代理流程。

这一创新大大降低了 AI 代理的使用门槛,为开发者提供了一个轻量、安全、可移植的执行环境。

传统的 AI 代理通常依赖复杂的运行时环境和工具链,限制了其在不同系统间的共享与测试。而 Wasm-Agents 的目标是:

这使得 AI 代理更易于教学、演示和实验性应用落地。

Wasm-Agents 的核心在于 WebAssembly + Pyodide 技术组合:

具体流程如下:

micropip 安装所需 Python 依赖整个过程都发生在浏览器内部,无需后端服务器或 API 调用。

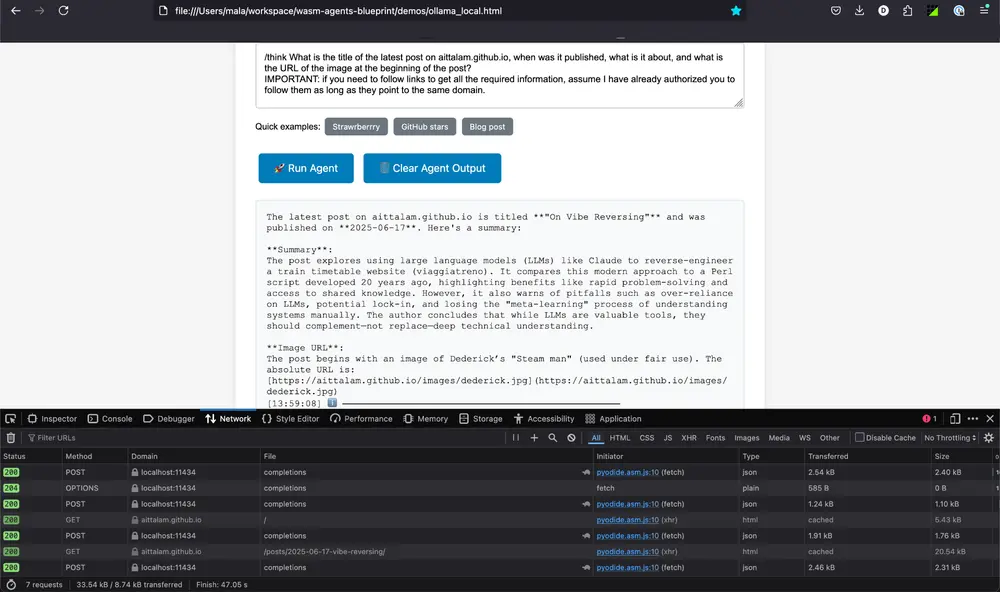

Wasm-Agents 提供了多个 HTML 演示文件,帮助用户快速上手:

| 文件名 | 功能说明 |

|---|---|

hello_agent.html | 最基础的对话代理,支持自定义指令 |

handoff_demo.html | 多代理系统,自动根据提示选择专业代理 |

tool_calling.html | 支持内置工具(如网页访问、字符计数) |

ollama_local.html | 使用本地模型(如 Ollama 上的 qwen3:8b) |

这些示例展示了代理如何完成从基本交互到复杂任务调用的全过程。

/config.js 中的密钥ollama pull qwen3:8b)⚠️ 注意:若需访问外部资源(如网页),请确保目标服务启用了 CORS。

尽管 Wasm-Agents 具有开创性意义,但仍存在一些局限:

Wasm-Agents 目前还只是一个原型项目,但它代表了一种新的方向:在浏览器中运行完整的 AI 代理工作流。

随着 WebAssembly 生态的发展和浏览器计算能力的提升,未来或许我们可以看到: