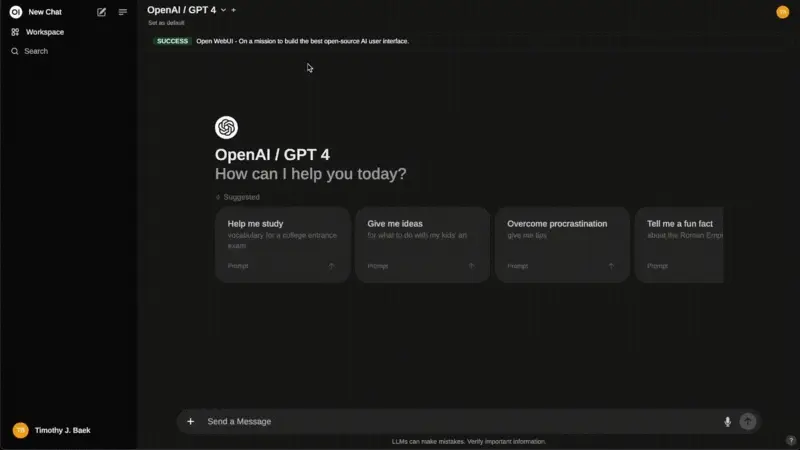

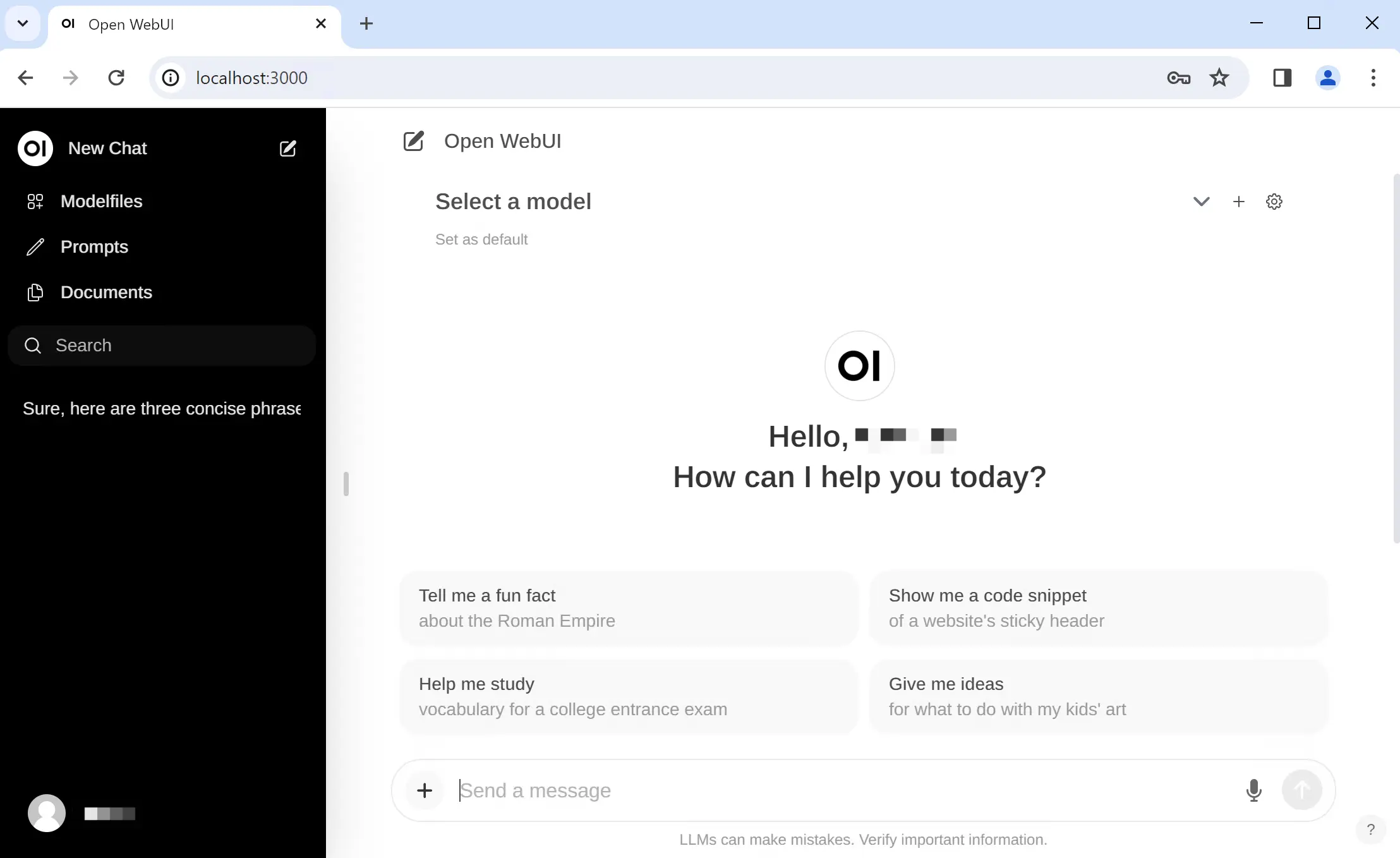

Open WebUI 是一个功能丰富、高度可扩展的自托管 AI 平台,专为离线运行设计。它支持多种 LLM(大语言模型)运行器,包括 Ollama 和 OpenAI 兼容 API,并内置用于 RAG(检索增强生成)的推理引擎,使其成为部署和管理 AI 模型的理想解决方案。

无论您是开发者、研究人员,还是企业用户,Open WebUI 都能为您提供强大且灵活的功能,帮助您轻松构建、管理和优化 AI 应用。

核心功能一览

1. 轻松设置与部署

- 支持通过 Docker 或 Kubernetes(kubectl、kustomize 或 helm)快速安装。

- 提供

:ollama 和 :cuda 标签镜像,适配不同硬件环境,确保无忧部署体验。

2. 多样化 API 集成

- 原生支持 OpenAI 兼容 API,可连接 LMStudio、GroqCloud、Mistral、OpenRouter 等平台。

- 自定义 OpenAI API URL,轻松切换不同模型提供商。

3. 细粒度权限管理

- 通过基于角色的访问控制 (RBAC),管理员可创建详细的用户角色和权限,确保安全性和灵活性。

- 提升用户体验的同时,增强系统的安全性与可控性。

4. 响应式设计与移动端支持

- 在桌面、笔记本电脑和移动设备上提供无缝体验。

- 支持渐进式 Web 应用 (PWA),在移动设备上实现类原生应用的操作体验,同时支持本地离线访问。

5. Markdown 与 LaTeX 支持

- 提供全面的 Markdown 和 LaTeX 功能,让交互内容更加丰富多样。

- 适合学术研究、技术文档撰写等场景。

6. 免提语音/视频通话

- 集成免提语音和视频通话功能,打造更动态、更互动的聊天环境。

- 适用于远程协作、实时沟通等场景。

7. 模型构建器与自定义角色

- 通过 Web UI 轻松创建 Ollama 模型或导入自定义角色/代理。

- 定制聊天元素,满足个性化需求,并通过社区集成共享和导入模型。

8. 原生 Python 函数调用工具

- 内置代码编辑器,支持纯 Python 函数的“自带函数 (BYOF)”功能。

- 让开发者能够轻松扩展 LLM 的能力,实现复杂逻辑处理。

9. 本地 RAG 集成

- 通过 RAG(检索增强生成)支持,将文档交互无缝集成到聊天体验中。

- 直接加载文档或将文件添加到文档库,使用

# 命令快速访问相关数据。

10. Web 搜索与浏览功能

- 使用 SearXNG、Google PSE、Brave Search 等搜索引擎进行 Web 搜索,并将结果直接注入聊天。

- 通过

# 命令后接 URL,将网页内容无缝融入对话。

11. 图像生成支持

- 集成 AUTOMATIC1111 API、ComfyUI(本地)以及 OpenAI DALL-E(外部),提供图像生成功能。

- 通过动态视觉内容提升聊天体验。

12. 多模型对话

- 同时与多个模型交互,充分发挥不同模型的优势,获得最佳响应效果。

- 通过并行使用多样化模型,提升整体体验。

13. 插件与 Pipelines 支持

- 通过 Pipelines 插件框架,将自定义逻辑和 Python 库无缝集成到 Open WebUI 中。

- 示例功能包括:函数调用、用户限流、使用监控、实时翻译、有害信息过滤等。

14. 多语言支持

- 提供国际化 (i18n) 支持,支持多种语言界面。

- 我们正在积极寻找贡献者,共同扩展语言支持范围。

15. 持续更新与改进

- 团队致力于通过定期更新、修复和新功能不断改进 Open WebUI,确保其始终处于技术前沿。

为什么选择 Open WebUI?

- 完全离线运行:所有数据和模型均存储在本地,无需依赖云端服务,保障隐私与安全。

- 高度可扩展性:支持多种模型运行器和插件框架,满足不同场景需求。

- 丰富的功能集:从 RAG 到图像生成,从语音通话到 Web 浏览,Open WebUI 提供了全面的功能支持。

- 用户友好的设计:响应式界面和多语言支持,确保每位用户都能轻松上手。

- 强大的社区生态:开放的社区支持和活跃的开发者贡献,让平台持续进化。

适用场景

- 企业级 AI 部署:离线运行和细粒度权限管理,确保企业数据安全。

- 学术研究:Markdown 和 LaTeX 支持,提升技术文档撰写效率。

- 内容创作:结合 RAG 和图像生成功能,快速生成高质量内容。

- 远程协作:免提语音/视频通话功能,助力团队实时沟通。

- 开发者工具:通过插件和 Pipelines 框架,轻松扩展平台功能。