LemonSlice

LemonSlice(前身为 Infinity AI)是一款视频生成平台,它允许用户仅需一张照片和一段脚本即可生成会说话的视频,适合营销专业人士、社交媒体内容创作者和 AI 电影制作者等。

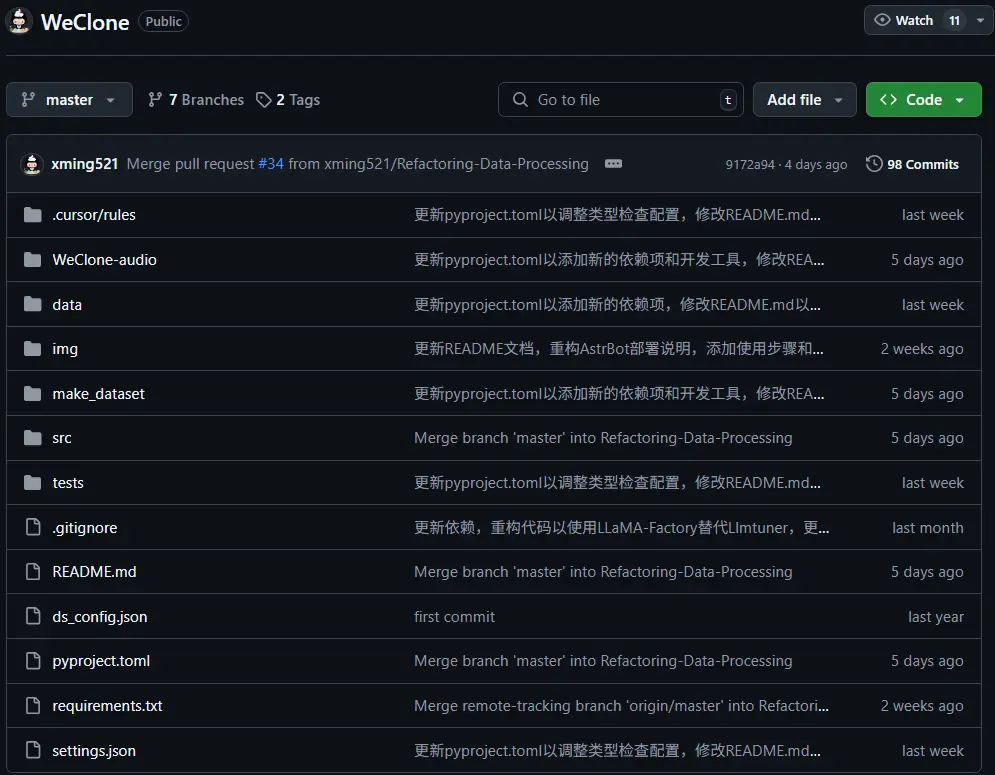

WeClone是一个从聊天记录创造数字分身的一站式开源解决方案。它通过一系列技术手段,将你的聊天记录和声音转化为一个高度个性化的数字分身,并将其绑定到各种聊天平台上。

WeClone的核心在于利用你的聊天记录和声音进行训练。具体来说,它通过以下步骤实现:

尽管WeClone为用户提供了创建数字分身的可能,但这一过程并非没有门槛。由于涉及到大模型的训练,用户需要具备一定的技术知识和硬件条件。例如,训练过程需要本地运行大模型,大约需要16GB显存。这意味着并非所有人都能轻松创建自己的数字分身。

硬件要求

目前项目默认使用chatglm3-6b模型,LoRA方法对sft阶段微调,大约需要16GB显存。也可以使用LLaMA Factory支持的其他模型和方法,占用显存更少,需要自行修改模板的system提示词等相关配置。

需要显存的估算值:

| 方法 | 精度 | 7B | 14B | 30B | 70B | xB |

|---|---|---|---|---|---|---|

Full (bf16 or fp16) | 32 | 120GB | 240GB | 600GB | 1200GB | 18xGB |

Full (pure_bf16) | 16 | 60GB | 120GB | 300GB | 600GB | 8xGB |

| Freeze/LoRA/GaLore/APOLLO/BAdam | 16 | 16GB | 32GB | 64GB | 160GB | 2xGB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | xGB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | x/2GB |

| QLoRA | 2 | 4GB | 8GB | 16GB | 24GB | x/4GB |