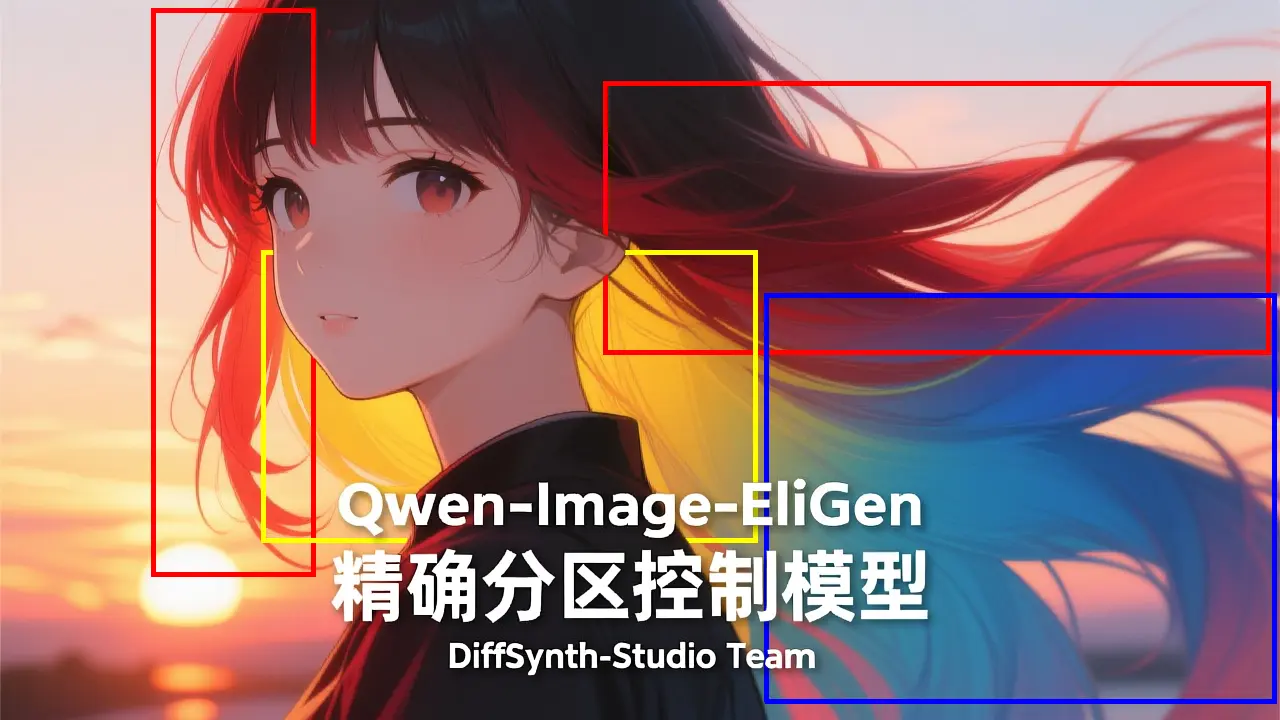

阿里魔塔团队开源了 Qwen-Image-EliGen —— 一个基于 Qwen-Image 的实体级可控图像生成模型。该模型通过引入区域注意力机制(Regional Attention),实现了对图像中多个语义实体的位置、形状与语义的精细化控制,同时保持生成结果的整体协调性与视觉质量。

这一进展为需要精确布局控制的文生图任务(如广告设计、场景合成、UI生成等)提供了更灵活、更可控的技术路径。

- 模型:https://www.modelscope.cn/models/DiffSynth-Studio/Qwen-Image-EliGen

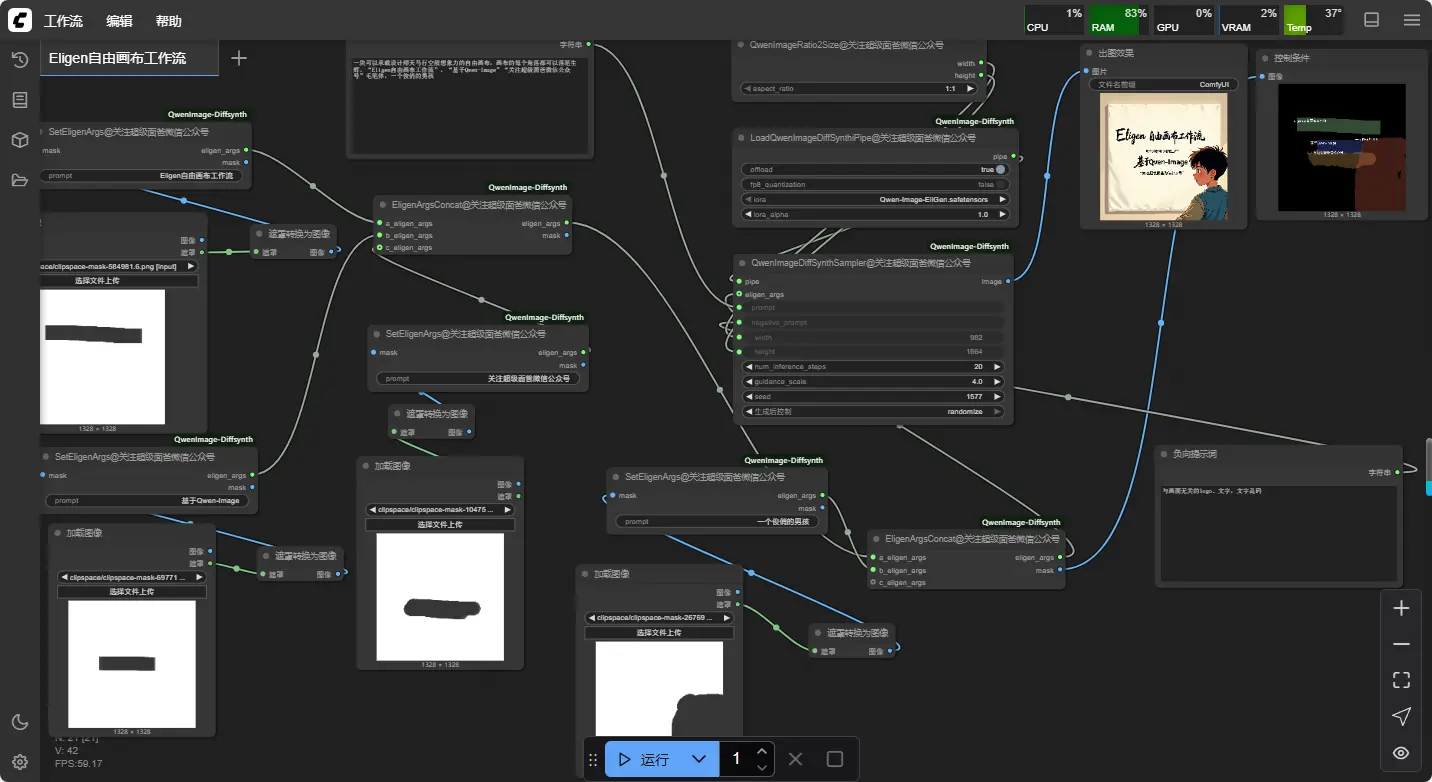

- ComfyUI插件:https://github.com/AIFSH/QwenImage-Diffsynth(非原生插件,不建议在本地使用)

什么是实体级控制?为什么重要?

传统的文生图模型(如 Stable Diffusion、Qwen-VL)依赖全局文本提示生成图像,虽然能生成高质量内容,但难以精确控制物体的位置、大小或局部结构。用户往往需要反复调整提示词或依赖后期编辑来达到预期效果。

而 实体级控制(Entity-level Control) 的目标是:

让用户能够分别定义图像中每个对象的“说什么”(语义)和“在哪、长什么样”(空间布局),实现“所想即所得”。

Qwen-Image-EliGen 正是为此设计:它允许用户为每个实体提供独立的文本描述和区域条件(如蒙版图),模型据此生成符合语义与空间约束的图像。

核心技术:区域注意力机制(Regional Attention)

EliGen 的核心技术在于其引入的 区域注意力机制,该机制在扩散模型的交叉注意力层中实现细粒度控制:

工作原理简述:

- 输入双条件:

- 每个实体的文本描述(例如:“一只棕色的狗”)

- 对应的区域条件(如二值蒙版图,标明该实体应出现的位置和大致形状)

- 注意力引导:

在去噪过程中,模型通过区域注意力机制,将特定文本描述的语义信息绑定到对应的空间区域,确保“狗”的文本只影响“狗”的蒙版区域,而不干扰背景或其他对象。 - 整体一致性保持:

所有实体并行生成,并通过共享的上下文建模机制保证光影、视角和风格的一致性,避免拼贴感。

这种设计使得模型既能实现局部精确控制,又能维持全局自然融合。

模型架构与训练细节

| 项目 | 说明 |

|---|---|

| 基础模型 | Qwen-Image(通义千问多模态系列) |

| 微调方式 | LoRA,轻量高效,易于部署与组合 |

| 模型类型 | 精确分区控制模型,支持多实体、多区域输入 |

| 训练框架 | 基于 DiffSynth-Studio 构建 |

| 训练数据 | DiffSynth-Studio/EliGenTrainSet,包含带区域标注的图文对数据集 |

✅ 由于采用 LoRA 结构,Qwen-Image-EliGen 可直接与原始 Qwen-Image 模型结合使用,无需修改主干网络,支持即插即用。

典型应用场景

EliGen 特别适用于以下需要语义+布局双重控制的任务:

- 广告创意生成:固定品牌 Logo 位置,动态替换产品外观

- 室内设计布局:按用户草图放置家具,保持风格统一

- 角色场景合成:控制人物姿态与位置,生成连贯剧情图像

- UI/UX 原型生成:根据布局框生成符合语义的界面元素

相比传统 ControlNet 等基于边缘或深度图的控制方式,EliGen 提供了更高层次的语义化区域控制能力,更适合复杂多对象场景。

相关图书

VestalWater's Illustrious Styles for Qwen Image

Qwen-Image-Edit-InStyle

Qwen_Image_4_Grid_Display_Lora