你是否希望 AI 能真正理解你当前在做什么——而不是让你反复打字、复制、上传?

你是否担心屏幕内容被悄悄传到云端,却找不到一个完全离线、本地运行的替代方案?

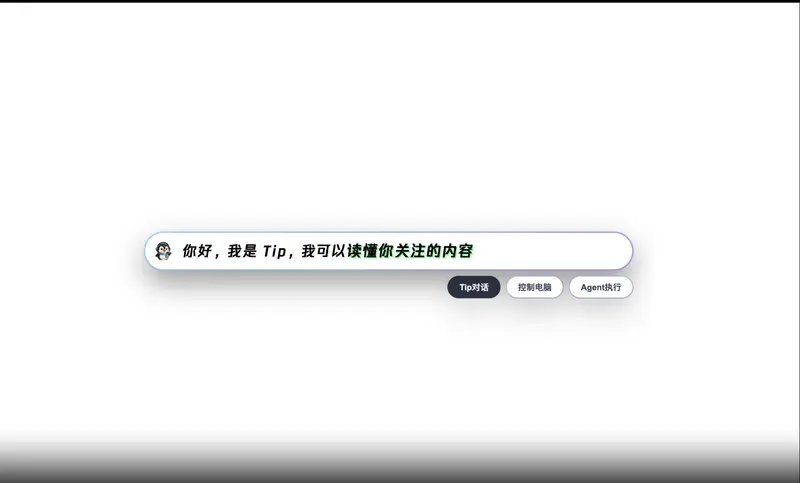

Youtu-Tip是一个主动式端侧 AI 助手,只需按下热键(Ctrl + Shift),就能智能感知你选中的文字、图像或当前工作上下文,并基于本地大模型提供响应。所有数据处理均在设备端完成,无需联网,不传云端,百分百隐私可控。

Tip 是 Youtu-Agent的可视化应用,集成了桌面自动化、智能代理调用、多模态理解等能力,现已完全开源。

三大核心理念

✅ 更好的交互:一键即用,无需打字

- 按

Ctrl + Shift:弹出对话窗口,直接提问 - 选中文本后按

Ctrl + Shift:AI 自动基于选中内容继续对话 - 长按

Ctrl + Shift并拖拽:截图指定区域,AI 理解图像内容

这不是另一个聊天框,而是上下文感知的智能入口,解决人机交互的“最后一公里”。

✅ 更安全的隐私:100% 端侧运行

- 所有模型推理在本地完成(支持 M 系列 Mac)

- 默认使用自研轻量模型 Youtu-LLM(1.96B) 或 Youtu-VL(4B 多模态,即将开源)

- 你也可以自由替换为 Ollama、llama.cpp 或任何 OpenAI 兼容模型

屏幕内容、文件信息、聊天记录——永远不会离开你的设备。

✅ 更全面的功能:不止问答,还能操作电脑

Tip 不仅能“说”,还能“做”:

- GUI Agent:模拟鼠标/键盘操作,自动执行重复任务

- 技能(Skills)机制:教 AI 学会你的专属工作流(如“整理报销单”“导出特定格式数据”)

- Youtu Agent:支持执行 Bash 命令、解析文件、调用工具链

- MCP 服务器集成:可连接外部工具扩展能力边界

例如:右键文件 → “打开方式 → Tip” → 点击“Agent 执行”,即可让 AI 分析该文件内容并生成摘要。

技术亮点:Youtu-LLM,小而强大

Tip 背后的核心引擎是 Youtu-LLM —— 一个仅 1.96B 参数的轻量级大模型,却在多项基准测试中超越更大规模的竞品:

| 能力维度 | 表现 |

|---|---|

| STEM 推理 | GSM8K 数学题准确率 77.6%,超越 Llama3.1-8B |

| 代码生成 | HumanEval+ Pass@1 达 57.3%,接近 Qwen3-4B |

| 长上下文 | 支持 128K 上下文,NIAH 测试准确率 98.8% |

| 智能体能力 | 在 APTBench 工具调用、深度研究等任务中显著领先同规模模型 |

其设计以 STEM 与智能体能力为核心,采用 MLA 架构,在端侧实现高效推理,同时支持原生多轮交互与工具调用。

模型已开源,支持 Transformers、vLLM 等主流框架,Ollama 接入即将上线。

如何开始使用?

1. 安装(目前仅支持 Apple Silicon Mac)

- 从 GitHub Releases 下载安装包

- 首次启动需授权:

- 辅助功能:用于获取选中内容、模拟操作

- 屏幕录制:用于区域截图(仅本地处理,不上传)

若权限列表未显示 Tip,请点击左下角 “+” 手动添加。

2. 配置模型

在「设置 → 模型」中,可选择:

- Ollama 模型:本地运行 Youtu-LLM、Llama3 等

- OpenAI 兼容接口:接入本地 llama-server 或在线 API(如需)

3. 快速体验三种调用方式

| 操作 | 效果 |

|---|---|

Ctrl + Shift | 弹出通用对话窗口 |

选中文本 + Ctrl + Shift | AI 自动基于文本上下文响应 |

长按 Ctrl + Shift + 拖拽 | 截图区域,AI 理解图像内容 |

能力边界说明

端侧模型虽快且私密,但能力有限。以下为典型任务对比:

| 任务类型 | 端侧模型 | 大型云端模型 |

|---|---|---|

| 搜索页面内容 | ✅ | ✅ |

| 单步操作(如点击按钮) | ✅ | ✅ |

| 多步规划(如查机票比价) | ❌ | ✅ |

| 跨应用协作 | ❌ | ✅ |

| 异常重试 | ✅ | ✅ |

建议:简单任务用端侧模型保隐私,复杂任务可切换至更强模型。

开源与扩展

Tip 完全开源,支持本地开发与定制:

- 可自定义 GUI 技能(Skills)

- 可集成新工具或 MCP 服务

- 可修改 UI 或热键逻辑

相关软件

ima.copilot - 最新版

Clippy - 最新版

![Youtu-Tip 端侧AI助手的使用截图[1]](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768114054-1768114054-Tip-2.webp)