VidTrainPrep - 最新版

VidTrainPrep 是一个基于 Python 的工具,专为剪辑和准备视频数据而设计,特别适合为 LORA、Wan 或 Hunyuan 等视频模型创建训练数据集。它支持精确的范围选择、裁剪、FPS 转换,以及使用 Gemini API 进行可选的 AI 驱动描述生成。

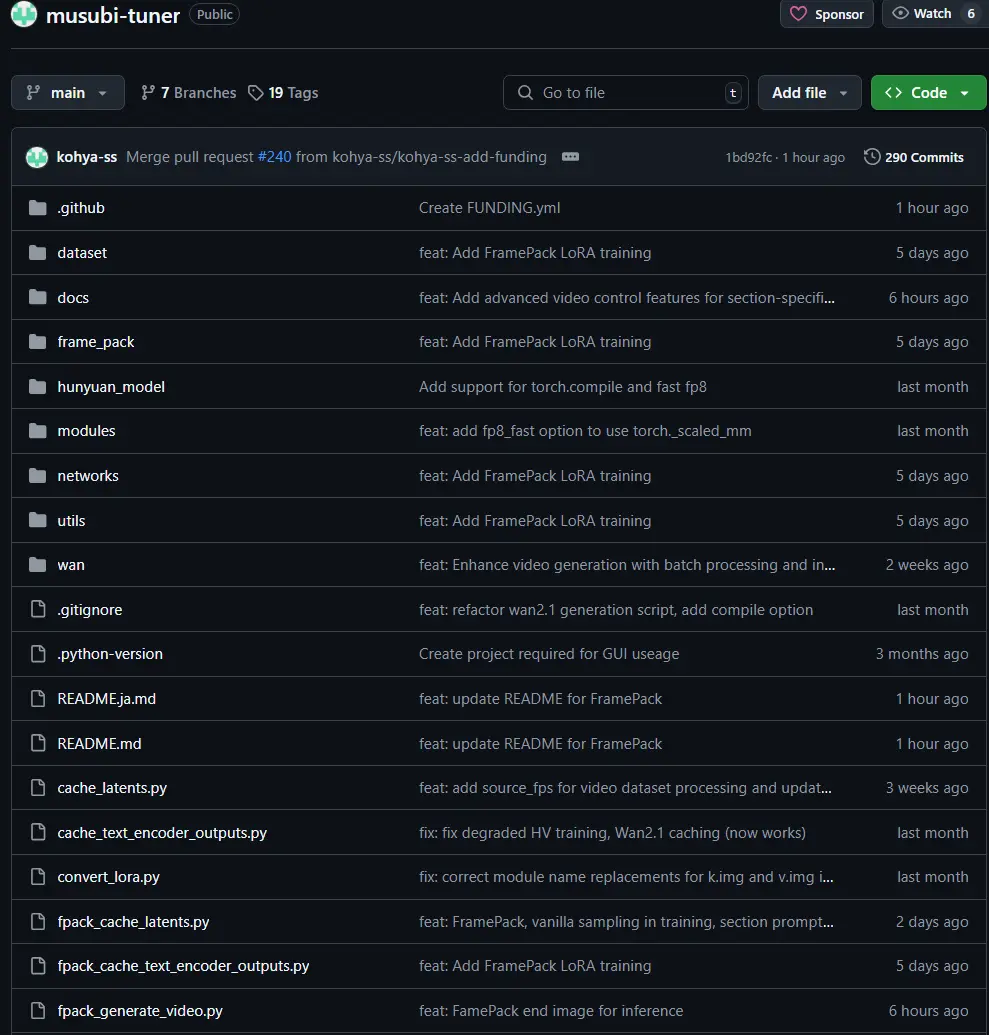

Musubi Tuner主要用于训练 LoRA模型,特别针对 HunyuanVideo、Wan2.1 和 FramePack 等视频生成架构。它帮助用户微调模型以适应特定视频生成任务,适合需要定制化 AI 模型的团队或个人。

2 人已下载 手机查看

Musubi Tuner 是一个功能强大的开源工具,专门为训练 LoRA模型设计,特别针对 HunyuanVideo、Wan2.1 和 FramePack 等视频生成架构。其核心目标是提供脚本和工具,帮助用户训练 LoRA 模型以适应视频生成任务。LoRA 是一种高效的模型微调技术,特别适合在有限资源下优化大型模型。

Musubi Tuner 提供了从训练到推理的全流程支持,包括内存优化、PyTorch Dynamo 加速和多种实验性功能。它适合研究人员、开发者或 AI 爱好者,用于定制化视频生成模型,例如生成特定风格的视频或优化现有模型的性能。

Musubi Tuner 的功能非常丰富,以下是其关键特性和最新更新:

| 功能类别 | 具体功能 |

|---|---|

| 训练支持 | 支持 HunyuanVideo、Wan2.1 和 FramePack 架构的 LoRA 模型训练。 |

| 内存优化 | 提供内存高效实现,社区确认在 Windows 和 Linux 上兼容,支持单 GPU 训练。 |

| PyTorch Dynamo 优化 | hv_train_network.py 和 wan_train_network.py 支持 PyTorch Dynamo 优化,PR [#215],提升训练速度。 |

| Wan2.1 增强 | 添加批量生成模式(从文件读取提示)和交互模式(命令行输入),2025 年 4 月 18 日更新。 |

| 视频数据集支持 | 支持通过 JSONL 指定包含多张图像的目录,自动下采样帧率,2025 年 4 月 6 日更新。 |

| 实验性功能 | 支持 Wan2.1-Fun Control 模型的实验性训练和推理,2025 年 3 月 30 日测试于 14B I2V Control。 |

| 推理选项 | 包括 CPU 噪声生成(--cpu_noise 选项,2025 年 3 月 27 日)、潜在缓存调试模式、跳层引导等。 |

| 社区支持 | 启用了 GitHub Discussions,方便用户提问和分享知识。 |

这些功能使得 Musubi Tuner 成为一个灵活的工具,适合不同规模的视频生成任务。

Musubi Tuner 对硬件有较高要求,以下是具体需求:

| 硬件类型 | 推荐配置 | 最低配置 |

|---|---|---|

| VRAM | 图像训练:12GB+;视频训练:24GB+ | 图像训练:12GB(需使用内存优化选项,如 --blocks_to_swap) |

| 主内存 | 64GB+ 推荐 | 32GB + Swap,可能可用但未经验证 |

这些要求确保了工具在高分辨率和复杂训练任务下的稳定运行。用户可以根据具体任务调整分辨率和使用内存优化选项以适应较低配置。

此外,社区还开发了 GUI(如 TTPlanetPig/Gui_for_musubi-tuner),方便非命令行用户操作。

Musubi Tuner 主要用于视频生成任务的模型微调。例如:

这些用例表明,Musubi Tuner 特别适合研究人员和开发者,用于定制化视频生成模型,满足特定需求。