Ollama 最新发布的 v0.15+ 版本 引入了一个全新命令:ollama launch。该命令旨在简化主流 AI 编程工具(如 Claude Code、OpenCode、Codex 等)的启动流程——无需手动设置环境变量或编辑配置文件,即可快速连接本地或云端大模型,立即进入编码状态。

快速开始

首先,确保已安装 Ollama v0.15 或更高版本。然后在终端中拉取推荐的编程模型:

# 本地运行(需约 23 GB VRAM,支持 64,000 tokens 上下文)

ollama pull glm-4.7-flash

# 或使用云端托管模型(完整上下文支持,资源要求更低)

ollama pull glm-4.7:cloud

💡 提示:编程类任务对上下文长度高度敏感。建议将 Ollama 的上下文长度设置为 至少 64,000 tokens,以获得最佳体验。具体配置方法请参阅官方 上下文长度文档。

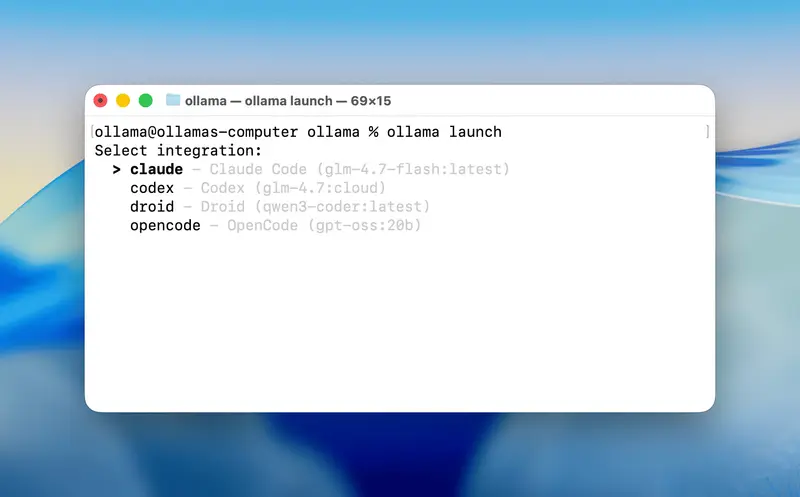

一键启动编程工具

使用 ollama launch 命令,可直接启动你偏好的开发助手:

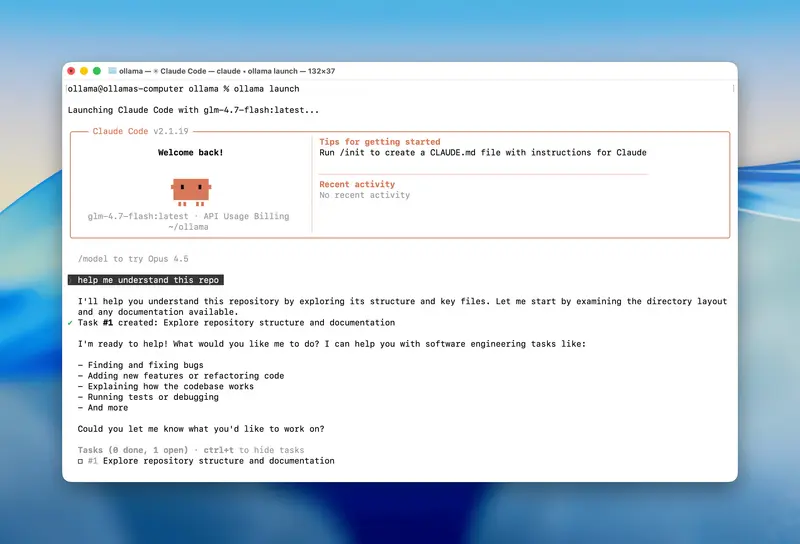

# 启动 Claude Code

ollama launch claude

# 启动 OpenCode

ollama launch opencode

执行后,系统会引导你选择已下载的模型(本地或云端),并自动完成集成配置,随即启动对应工具。整个过程零配置、零环境变量,大幅降低使用门槛。

当前支持的集成

- Claude Code

- OpenCode

- Codex

- Droid

未来版本将陆续扩展更多开发工具支持。

推荐编程模型

本地运行(需高性能 GPU)

glm-4.7-flashqwen3-codergpt-oss:20b

云端托管(推荐普通用户)

glm-4.7:cloudminimax-m2.1:cloudgpt-oss:120b-cloudqwen3-coder:480b-cloud

云端模型由 Ollama 托管,提供完整的上下文长度支持,且即使在免费层级也享有较高配额,适合长时间编码会话。

更长的编码会话支持

为满足深度开发需求,Ollama 云服务现已支持 最长 5 小时的连续编码会话。这意味着你可以进行更复杂的项目构建、调试或多轮迭代,而无需频繁中断。详细配额与定价信息请访问:ollama.com/pricing

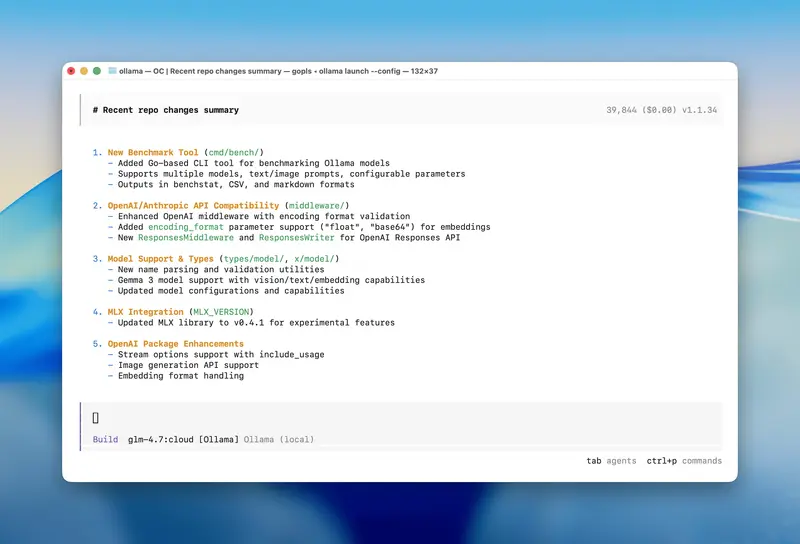

仅配置,不启动

如果你只想完成工具配置,暂不启动界面,可使用 --config 标志:

ollama launch opencode --config

该模式适用于自动化脚本或 CI/CD 流程中的预配置阶段。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...