当各大公司争相投入资源布局AI领域,这场技术热潮究竟产出了多少实际价值?近期,科技媒体Ars Technica针对四款主流付费AI编程智能体展开了一场实操测试:为网页开发一款完整的《扫雷》克隆版,核心要求包括适配音效、支持移动设备触屏操作,以及加入一项“有趣的玩法变体”。

对熟悉《扫雷》的人来说,这款游戏看似简单,却需要逻辑机制与UI/UX设计的精准配合,其底层逻辑的实现更需要一定的设计巧思——这也恰好能检验AI编程的实际落地能力。本次测试覆盖Anthropic Claude Code、谷歌Gemini CLI、Mistral Vibe,以及基于GPT-5的OpenAI Codex四款工具,所有智能体均接收相同指令,且仅以首次运行生成的内容计分,全程无人工干预、无二次调整机会。

最终测试结果差异显著,从顶尖的9分到垫底的0分,清晰展现了不同AI编程工具的实力差距。

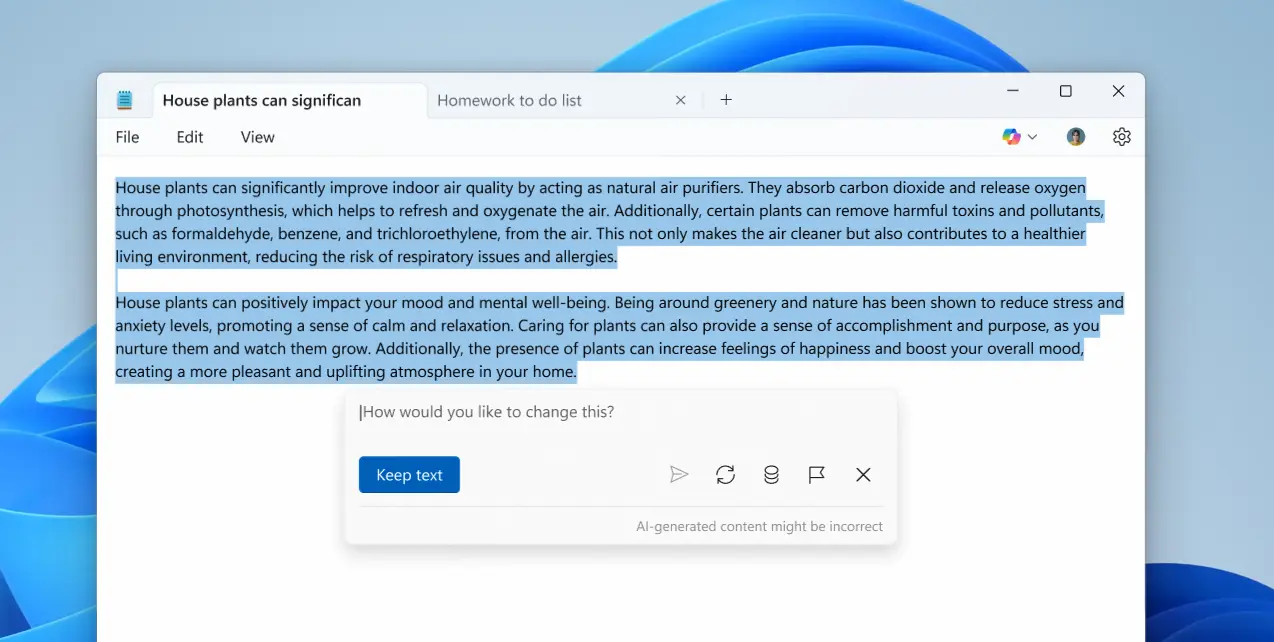

1. OpenAI Codex:9/10,最接近直接发布的成熟版本

本次测试的佼佼者当属OpenAI Codex,不仅视觉呈现出色,更是四款工具中唯一实现“连击功能”的——这一功能深受资深玩家青睐,能在正确放置旗帜后自动揭示周围所有方块,缺少它会大幅降低游戏精致度。

Codex开发的扫雷版本功能全面:所有按钮均可正常使用,配备了带时代感“哔哔声”的音效及对应的开关,还针对移动设备和桌面端分别添加了屏幕说明;玩法上新增“幸运清扫”按钮,满足特定条件时会随机揭示一个安全方块,为游戏增添了随机性趣味。

编程体验同样流畅,命令行界面自带流畅动画与本地权限管理,唯一不足是编写代码耗时较长。Ars Technica评价其为“最少人工干预即可发布”的版本,给出9/10的高分实至名归。

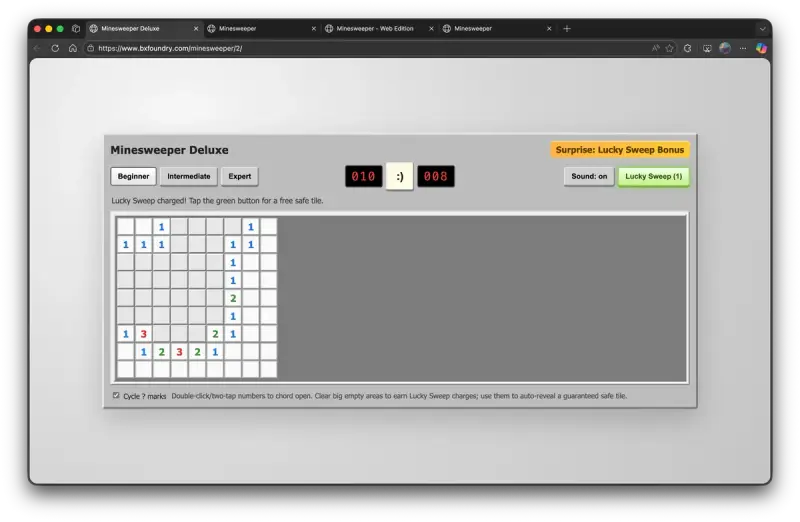

2. Claude Code:7/10,美学出众但核心功能缺失

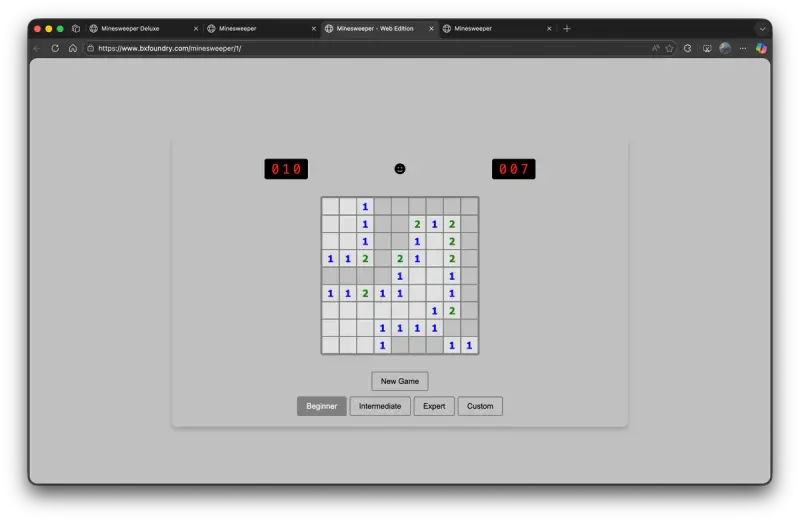

紧随其后的Anthropic Claude Code,编程耗时仅为Codex的一半,且成品美学表现最为出色——不仅是所有版本中视觉最精致的,炸弹配备自定义图形,顶部还设有适配全设备的微笑表情符号;音效悦耳,开关在移动端和桌面端均能稳定工作。

但致命短板在于缺失连击功能,被测试者评为“不可接受”,直接拉低了整体体验。不过其玩法创新值得肯定,新增“强力模式”提供简单能量增益,考验了AI的创造力;移动端专属的“旗帜模式”按钮,也很好地替代了长按标记方块的操作,提升了触屏体验。

实测中能明显感受到其流畅的操作手感,Claude Code的Opus 4.5模型仅用不到5分钟就完成了扫雷克隆版开发,编程界面也最为简洁。扎实的呈现效果让它获得7/10分,测试者表示,若补充连击功能,分数还能进一步提升。

3. Mistral Vibe:4/10,功能残缺的基础可用版本

第三名的Mistral Vibe仅交出了“勉强可用”的成果,虽游戏能正常运行、视觉效果尚可,但核心缺陷诸多:缺失关键的连击功能和音效,底部设置的“自定义”按钮完全无效,且未添加任何约定的趣味玩法变体,这些问题直接导致大量扣分。

视觉层面也存在小瑕疵:顶部的微笑表情符号为纯黑色,给测试者带来不适感;选择“专家”模式时,游戏网格会超出方形背景,出现明显视觉故障。操作上,桌面端可通过右键标记旗帜,但移动端需长按,存在误调出设备上下文菜单的风险(实测中未触发)。

其编程界面稳定易用,但速度不算快。考虑到Mistral的资源规模远小于头部科技公司,能完成基础可用的版本已让测试者略感意外,最终评分4/10——不少人认为这个分数略低于实际表现。

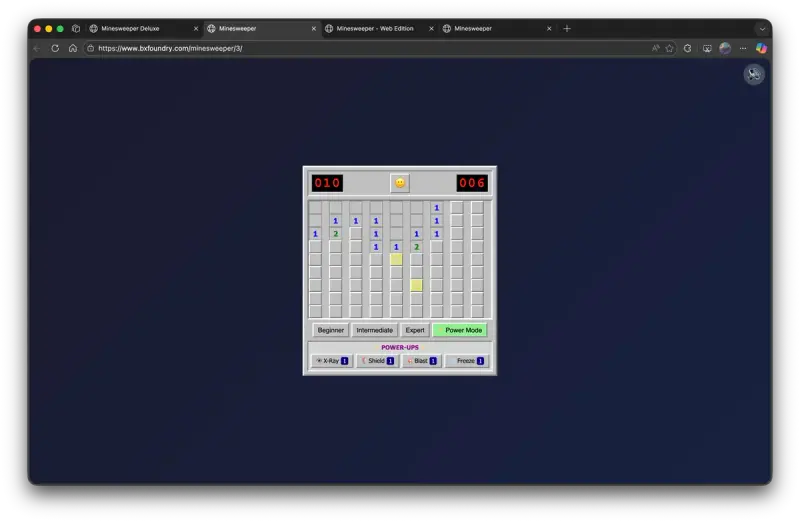

4. Google Gemini CLI:0/10,完全无法运行的失败品

本次测试的垫底者是Google Gemini CLI,这一结果令人意外——毕竟Google近期常在各类AI基准测试中名列前茅,且联合创始人谢尔盖·布林回归主导尖端AI业务后,外界普遍期待其技术突破。但Gemini开发的扫雷克隆版完全无法运行:仅能显示按钮,核心的游戏方块缺失,根本无法开展游戏,自然也无法计分。

视觉上,它与Claude Code的成品惊人相似,仿佛编程过程被中途打断。更糟糕的是,Gemini不仅编程耗时最长(单次运行需1小时),还频繁要求调用外部依赖项。测试者曾放宽规则给予二次机会,明确指令其使用HTML5开发,仍未能产出可用成果。

Ars Technica指出,本次测试的Gemini CLI未搭载最新的Gemini 3编程模型,仅依赖Gemini 2.5系统集群,或许升级至更高阶付费版本会有不同结果,使本次测试显得“未完成”。但无论如何,完全无法运行的表现仍令人失望,最终评分0/10。

测试总结:AI编程实力分化明显,实用价值仍需考量

本次扫雷克隆测试清晰呈现了当前主流AI编程智能体的实力梯度:OpenAI Codex以接近商用的成熟度夺冠,Claude Code凭借美学优势和高效开发紧随其后,Mistral Vibe完成基础功能但缺陷较多,Google Gemini CLI则交出了完全失效的成果。

值得注意的是,这些AI工具均为付费版本,却呈现出如此悬殊的差距。对于尚未深度投入AI编程的用户而言,这场测试或许难以成为“入坑”的理由——毕竟即便是顶尖的Codex,也存在开发耗时过长的问题,而看似强大的头部科技公司产品,也可能在实际实操中拉胯。AI编程的热潮之下,实际实用价值仍需结合具体场景仔细考量。

相关文章