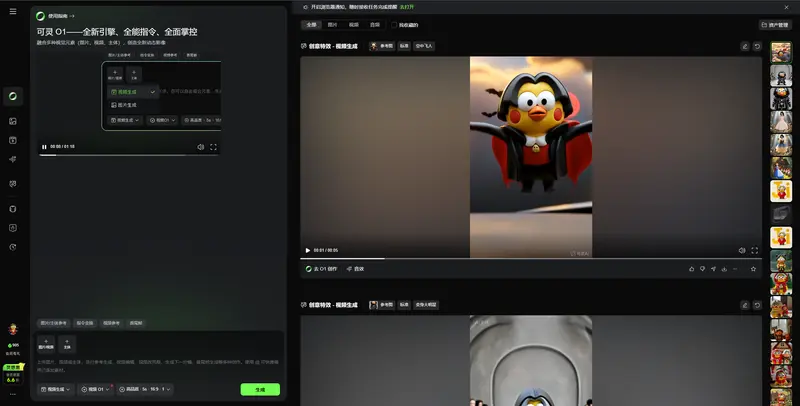

可灵 AI正式推出 O1 视频模型,并同步上线新版创作界面。该模型采用统一的生成式架构,旨在解决当前 AI 视频工具中常见的“功能割裂”问题——即文生视频、图生视频、编辑、补全等任务需依赖多个独立模型或模块。(官方使用指南)

统一底座 + 多模态交互

O1 的核心设计是引入 MVL(多模态视觉语言)交互架构,将文本、图像、视频等输入统一编码至同一语义空间。用户可在单一输入框中混合使用文字描述、参考图、视频片段等,模型通过 Chain-of-Thought(思维链)机制进行多步推理,推演事件发展、空间关系与视觉一致性。

例如,输入“一只戴着红围巾的猫,在雨中的东京街头奔跑,镜头从侧面切换到俯拍”,系统需同时理解角色特征、环境氛围、镜头运动逻辑,并确保主体在视角切换中保持一致。

主体稳定性与多主体组合

可灵强调 O1 在主体一致性方面的改进:

- 支持从多个视角生成同一主体,确保在镜头流转中面部、服饰、姿态等关键特征不漂移;

- 允许用户自由组合多个主体(如“人物 + 宠物 + 车辆”),并维持各自的身份与交互逻辑。

这一能力对故事短片、广告脚本、游戏过场等需连续镜头的场景尤为重要。

创作界面:对话驱动,降低门槛

新界面以自然语言对话为核心交互方式。用户可上传素材后通过对话逐步调整细节,如“让背景更暗一点”“把猫换成狗”“镜头拉远”。系统实时响应,并保持已有主体与场景的连贯性。

技术定位与挑战

可灵称 O1 为“统一多模态视频模型”,其价值不在于单项指标超越竞品,而在于用一个模型覆盖多种视频生成任务,减少因模块切换导致的语义断层或风格跳跃。

然而,统一架构也带来更高训练复杂度与推理成本。目前模型在处理复杂物理交互(如液体、烟雾)或长时序逻辑(超过10秒的连贯叙事)时仍可能存在局限。官方未披露具体参数量或训练数据规模,技术细节有待进一步验证。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...