OpenAI 今日正式发布两款开放权重(open-weight)AI 推理模型:gpt-oss-120b 和 gpt-oss-20b。

这是自 GPT-2 以来,OpenAI 首次向公众开放其语言模型权重,标志着这家长期坚持闭源策略的公司,在开源浪潮下的重大转向。

这两款模型已在 Hugging Face 平台免费上线,采用宽松的 Apache 2.0 许可证,允许自由使用、修改与商业化部署。

它们不仅是技术产品,更是一次战略宣言:

OpenAI 正试图在“美国价值观主导的开放 AI 生态”中重新夺回话语权。

为什么是现在?一场被倒逼的“开源”

长期以来,OpenAI 以闭源模型为核心构建商业壁垒,通过 API 向企业收费,建立起庞大的 AI 服务生态。

但近年来,形势已变:

- 中国 AI 实验室强势崛起:DeepSeek、阿里巴巴 Qwen、月之暗面等推出了一系列性能强大、完全开源的模型,迅速占领全球开发者心智;

- Meta 的 Llama 系列虽仍领先,但更新节奏放缓,社区期待新的突破;

- 美国政府施压:今年7月,特朗普政府公开呼吁美国 AI 公司“开源更多技术”,以对抗“非民主价值观驱动的 AI 扩张”。

面对内外压力,OpenAI CEO Sam Altman 在一月坦言:

“我们在开源这件事上,可能站在了历史的错误一边。”

如今,gpt-oss 的发布,正是这一反思的结果。

模型能力:性能接近 o 系列,但幻觉更严重

gpt-oss 系列并非实验性模型,而是基于 OpenAI 当前最先进的训练技术打造。

🔹 gpt-oss-120b:接近 o4-mini 的高性能推理模型

- 总参数:117B(MoE 架构)

- 激活参数:每 token 仅 5.1B,高效运行

- 部署:可在单块 80GB GPU 上运行

🔹 gpt-oss-20b:轻量级边缘推理选择

- 总参数:21B

- 部署:仅需 16GB 存,可在消费级笔记本运行

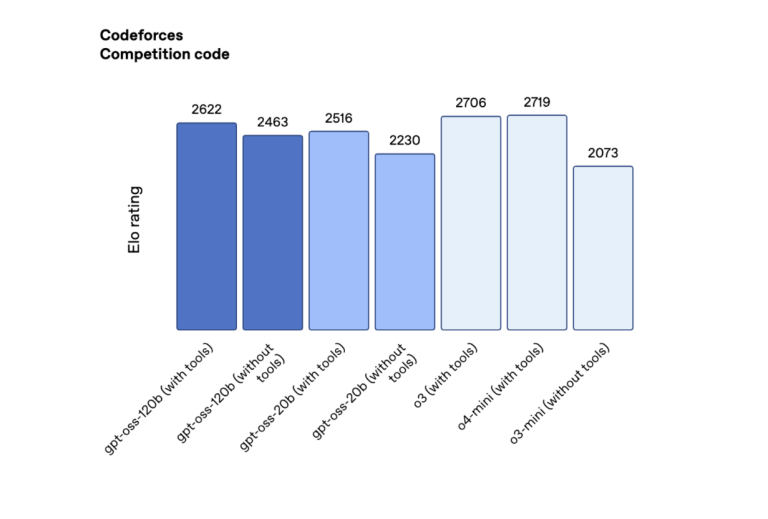

在多个基准测试中表现如下:

| 基准 | gpt-oss-120b | gpt-oss-20b | 对标模型 |

|---|---|---|---|

| Codeforces(竞技编码) | 2622 | 2516 | 超越 DeepSeek R1 |

| Humanity’s Last Exam | 19% | 17.3% | 优于 Qwen、DeepSeek 开源模型 |

| 幻觉率(PersonQA) | 49% | 53% | 显著高于 o1(16%)和 o4-mini(36%) |

尽管性能在开放模型中处于领先地位,但其幻觉问题尤为突出。OpenAI 在白皮书中承认:

“较小的模型知识更少,倾向于产生更多幻觉。”

这提醒开发者:不能将这些模型用于高可靠性场景,除非经过严格微调与对齐。

技术架构:与闭源模型共享训练栈

gpt-oss 并非简化版模型,而是在多个关键技术上与 o 系列保持一致:

- 混合专家(MoE)架构:大幅提升推理效率,降低部署成本;

- 强化学习(RL)后训练:使用大规模 GPU 集群进行高计算训练,教会模型“如何思考”;

- 链式推理(Chain-of-Thought, CoT):支持多步推理与工具调用(如代码执行、网页搜索);

- 工具使用能力:可驱动 AI 代理完成复杂任务。

但也有明确限制:

- 仅支持文本,不支持图像或音频处理;

- 不发布训练数据:出于版权诉讼风险考虑,OpenAI 未公开训练语料。

这与 AI2、DeepSeek 等完全开源数据的实验室形成对比,也意味着其“开放”仍有一定保留。

开放的意义:不只是技术,更是生态竞争

OpenAI 的开源动作,远不止于让开发者多一个模型可用。

它背后是三重目标:

1. 赢回开发者信任

过去几年,OpenAI 因闭源、涨价、接口不稳定等问题,逐渐失去部分开源社区支持。此次发布 Apache 2.0 模型,是重建关系的关键一步。

2. 响应美国政府号召

通过推出“由美国创建、基于民主价值观”的开放模型,OpenAI 在地缘科技竞争中站队明确。

3. 构建混合 AI 架构

OpenAI 强调:其开放模型可作为“前端”,将复杂任务(如多模态、超长推理)转发给云端闭源模型(如 o4-mini)。

这形成了一种新范式:

本地运行 gpt-oss 处理常规任务,云端调用 o 系列处理高难度请求。

既满足隐私与低延迟需求,又保留顶级能力。

与 Mistral 的竞争:开放模型战场已全面打响

就在上周,Mistral AI 发布了其完整企业编码栈,包括 Codestral 25.08、Devstral 与 Codestral Embed,并已在 Capgemini、Abanca、SNCF 等企业投产。

Mistral 的优势在于:

- 全栈集成:补全、搜索、代理一体化;

- 完全私有化部署;

- 支持本地运行与定制微调。

而 OpenAI 的 gpt-oss 则凭借:

- 更强的推理能力;

- 与 o 系列共享的技术栈;

- 更广泛的生态支持(Azure、ONNX、Windows 本地推理);

形成差异化竞争。

这场“开放模型之战”,不再是 Meta 一家独大,而是演变为 美国 vs 中国、闭源巨头 vs 开源新锐、全栈平台 vs 单点突破 的复杂博弈。

开发者该如何选择?

| 需求 | 推荐选择 |

|---|---|

| 需要最强推理能力 | gpt-oss-120b |

| 边缘设备部署 | gpt-oss-20b 或 Devstral Small |

| 私有化、合规要求高 | Mistral 编码栈(全自托管) |

| 希望商业化且无许可风险 | gpt-oss(Apache 2.0)或 Codestral(MIT) |

| 构建 AI 代理工作流 | Devstral + OpenHands 或 gpt-oss + Responses API |

相关文章