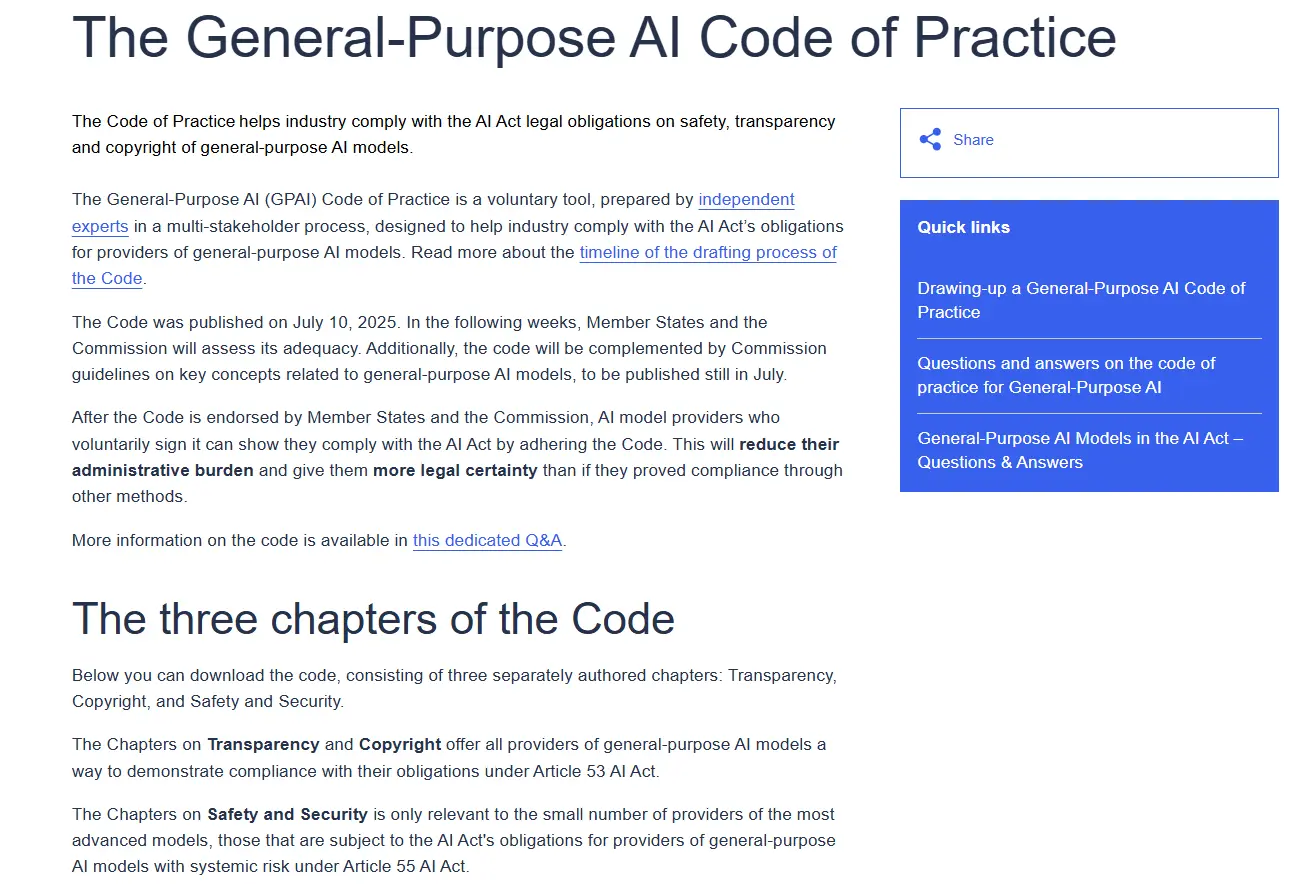

欧盟近日发布最新指导方针,要求大型人工智能公司遵守其《人工智能法案》(AI Act)下的行为准则。该法案作为全球首个针对人工智能开发的综合性法律框架,标志着监管机构对AI技术发展的高度重视。

尽管目前相关条款尚未全面强制执行,但新规已在逐步推进中——将于2024年8月2日正式生效,新上线的人工智能模型有一年时间合规,已有模型则享有两年宽限期。

这意味着,包括 OpenAI、微软、谷歌 在内的科技巨头,必须开始调整其AI开发流程,以适应即将到来的合规要求。

三大核心要求:透明度、版权合规、安全风险控制

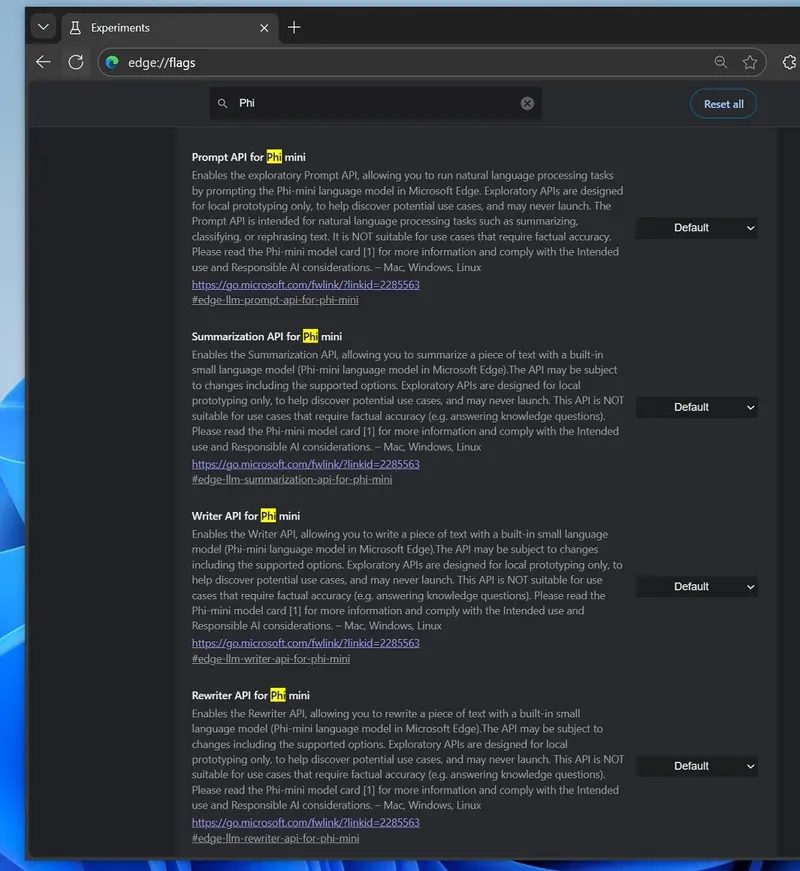

此次发布的《人工智能行为准则》主要面向通用型大语言模型(GPAI),分为三个关键部分:

1. 透明度要求

企业需公开其AI模型的开发和训练细节,包括但不限于:

- 使用的能源消耗;

- 所需算力规模;

- 数据来源及处理方式;

- 模型训练过程中涉及的数据点信息。

这对依赖大量未公开数据进行训练的AI公司而言,无疑是一次重大挑战。尤其是训练数据来源的披露,可能引发行业内部强烈反弹。

2. 版权合规义务

为防止侵犯知识产权,新规明确要求:

- 尊重网站付费墙;

- 不得绕过爬虫限制;

- 遵守现有版权法规。

这直接回应了近期欧洲出版商对谷歌“AI概览”功能的不满。该功能通过聚合多个网站内容生成摘要,使用户无需访问原站点即可获取信息,引发了多起反垄断投诉。

此外,丹麦已提出立法草案,赋予公民对其肖像的版权,允许他们就未经同意制作的深伪视频提起诉讼。

值得注意的是,AI行业内部也对此表达了担忧。一位前Meta高管曾警告称,如果每个版权持有者都要求授权使用数据,那么当前的大语言模型或将“一夜之间消亡”。

3. 安全风险控制

根据《人工智能法案》,AI系统若被用于以下领域,将被视为高风险应用:

- 实时监控;

- 武器开发;

- 金融欺诈检测;

- 虚假信息传播等。

这些应用场景不仅影响个人隐私和自由,还可能威胁公共安全。因此,法案要求企业在设计和部署AI系统时,必须充分评估潜在风险,并采取相应防护措施。

违规代价高昂:最高罚款达年收入7%

据彭博社报道,《人工智能法案》对违规行为设置了严厉的惩罚机制:

违反规定的企业,最高可被处以相当于其全球年销售额7%的罚款。

这一数字远高于欧盟现行GDPR对数据泄露的处罚上限(4%),显示出欧盟对AI治理的严格态度。

科技公司如何应对?

面对即将生效的监管框架,科技巨头们正试图在合规与创新之间寻找平衡:

- 一些公司正在建立新的数据审查机制,以确保训练数据合法合规;

- 另一些公司则在探索“合成数据”或“授权数据集”的替代方案,以降低侵权风险;

- 同时也有企业选择游说,希望影响未来细则的制定。

然而,无论是否愿意接受,这场由欧盟主导的AI监管风暴,已经在全球范围内掀起波澜。

AI监管进入实质阶段

随着《人工智能法案》的逐步实施,人工智能不再是一个“法外之地”。从数据来源到输出内容,从技术能力到社会影响,AI的每一个环节都将受到前所未有的审视。

对于开发者、企业和投资者来说,理解并适应这些变化,将成为未来AI生态发展的关键。

我们将持续关注《人工智能法案》的执行进展及其对全球AI产业的影响。

相关文章