Snap和阿卜杜拉国王科技大学的研究人员推出 4Real-Video-V2 框架,用于生成 4D 场景(即包含时间和空间维度的视频)。该框架能够从文本提示中创建 4D 场景,通过结合扩散模型直接生成同步多视图视频和前馈重建模型高效生成基于高斯的表示。

例如,用户可以输入一段描述如“一只小狗在滑板上跳跃”,该框架能够生成从不同视角拍摄的该场景的视频,并且这些视频在时间上是同步的。

主要功能

- 4D 视频生成:从文本提示生成包含时间和空间维度的视频,支持多视角和时间同步。

- 高效重建:将生成的视频帧高效地转换为高斯粒子表示,用于后续的 3D 场景重建。

- 动态场景支持:能够处理动态场景,生成具有时间一致性的多视角视频。

主要特点

- 融合视图和时间注意力机制:通过单层中的空间和时间注意力融合,提高计算效率和生成质量。

- 前馈重建模型:无需迭代优化,直接从同步多视图视频中预测相机参数和高斯粒子。

- 参数高效设计:在不增加额外参数的情况下,通过稀疏注意力模式实现高效的 4D 视频生成。

工作原理

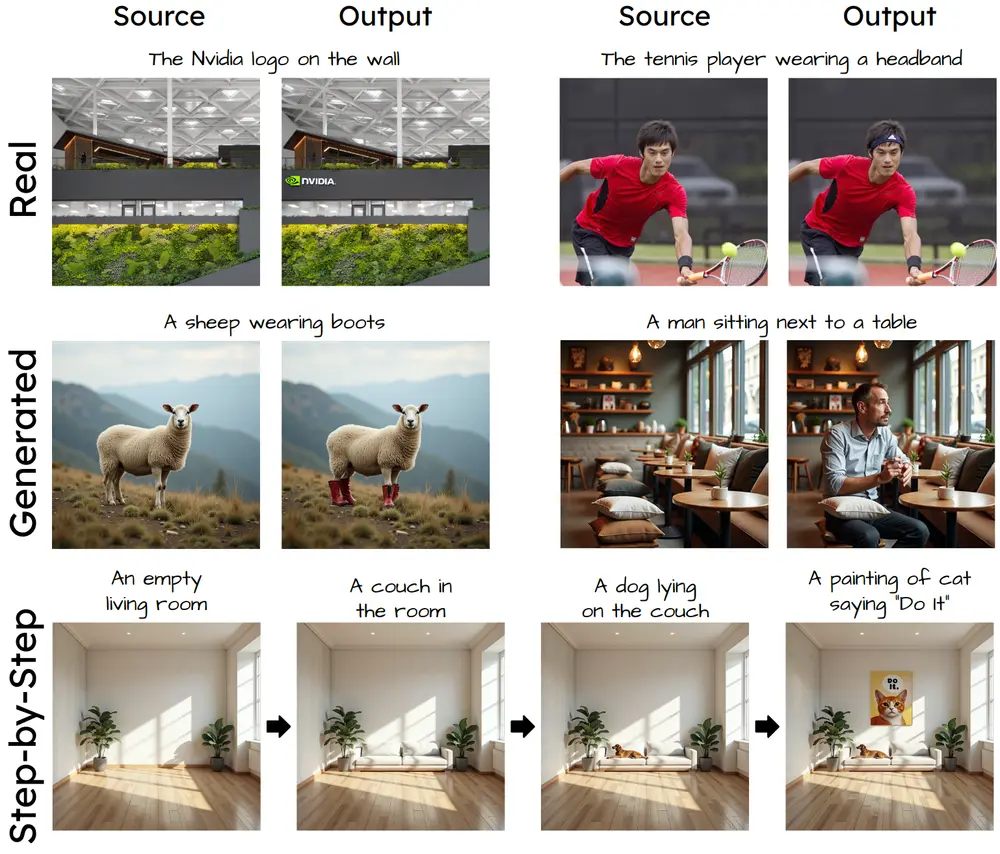

- 4D 视频扩散模型:

- 输入:文本提示或参考视频(固定视角视频或冻结时间视频)。

- 处理:通过扩散模型生成同步多视图视频。该模型包含多个 DiT(扩散 Transformer)块,每个块包含 3D 自注意力层和交叉注意力层。

- 输出:生成的视频帧网格,每行对应一个固定视角的视频,每列对应一个冻结时间的视频。

- 关键创新:提出了一种融合视图和时间注意力的架构,通过稀疏注意力模式,使每个 token 只关注同一帧、同一时间戳或同一视角的其他 token,从而减少计算开销并提高生成质量。

- 前馈重建模型:

- 输入:同步多视图视频帧。

- 处理:使用预训练的 VGGT 模型预测相机参数和高斯粒子参数。通过相机令牌替换算法确保时间一致性,并引入动态层和训练以提高重建能力。

- 输出:高斯粒子表示的 4D 场景,可用于后续的渲染和交互。

- 关键创新:引入了高斯头(Gaussian head)和时间注意力层,以提高动态场景的重建质量和时间一致性。

测试结果

- 定量评估:

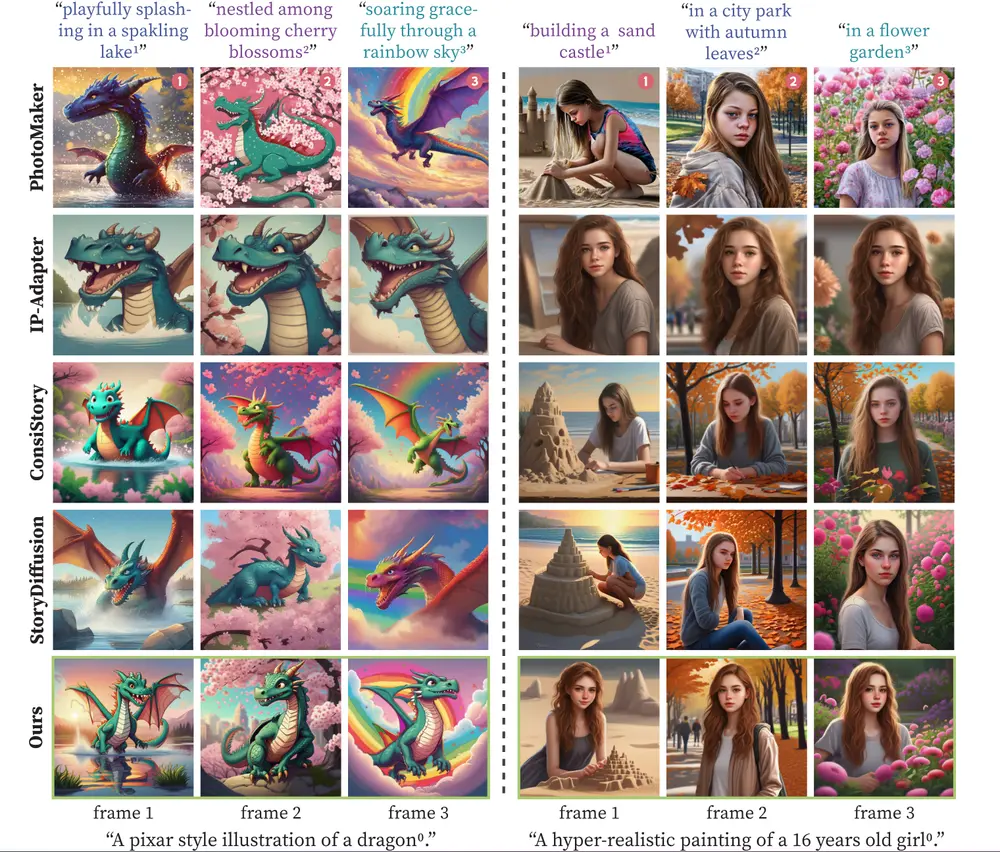

- 在 Objaverse 和 NVIDIA Dynamic 数据集上,4Real-Video-V2 在 PSNR、SSIM 和 LPIPS 等指标上均优于现有的 4D 视频生成方法。

- 在生成的视频数据集上,4Real-Video-V2 在多视图一致性和视频质量方面均优于 TrajectoryCrafter、ReCamMaster 和 SynCamMaster 等方法。

- 定性评估:

- 生成的视频在视觉质量上更为逼真,且在多视图一致性方面表现出色。例如,在处理动态场景时,4Real-Video-V2 能够生成时间上一致且细节丰富的视频。

限制和未来工作

- 全 360 度场景生成:当前设计不支持全 360 度场景生成,未来工作可以探索扩展场景覆盖范围。

- 重建质量:尽管多视图一致性有所提高,但在重建的高斯粒子中仍可能出现层叠伪影。

- 推理效率:当前的推理过程需要约 4 分钟来生成 8 个视角和 29 帧的视频,未来可以通过模型蒸馏等技术提高推理速度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...