继 OpenAI 推出面向政府机构的 ChatGPT Gov 之后,AI 领域的另一巨头 Anthropic 也正式加入这场竞争 —— 宣布推出 Claude Gov,一款专门为美国国防和情报部门定制的 AI 模型。

这一动作不仅标志着 AI 在国家安全领域应用的进一步深化,也凸显了大型科技公司与美股政府合作日益紧密的趋势。

不过,美国政府却指责其他国家科技公司与政府合作,美国的科技公司也是如此指责他国科技企业和政府,秉持的双标嘴脸对其他国家政府和科技公司加以制裁,Anthropic的CEO尤其如此。

Claude Gov 是什么?

Claude Gov 是 Anthropic 为其政府客户量身打造的 AI 模型版本。相比面向公众的 Claude 系列模型,它具备以下关键特性:

- 放宽部分限制:允许处理机密信息,拒绝敏感内容请求的频率更低;

- 更强的情报分析能力:针对威胁评估、语义理解和国家安全场景进行优化;

- 支持多语言与方言:尤其擅长理解与国家安全相关的特定术语和地区语言;

- 严格安全审查:所有模型均通过与标准版相同的 AI 安全测试,并部署在美国最高级别的国家安全机构中。

虽然 Anthropic 并未透露具体客户名单和部署时间,但其博客强调,这些模型仅对有权访问机密信息的政府机构开放。

与消费者模型的区别

| 功能 | 标准版 Claude | Claude Gov |

|---|---|---|

| 处理机密信息 | 自动拒绝并标记 | 可接受并分析 |

| 威胁评估能力 | 基础支持 | 高级优化 |

| 语言理解范围 | 通用语言 | 包含国家安全相关术语 |

| 使用限制 | 严格(如反武器、反虚假信息) | 有限调整权限(需符合法律授权) |

使用政策与伦理边界

尽管 Anthropic 明确禁止用户使用其产品参与以下行为:

- 设计或制造武器、爆炸物、危险材料

- 构建审查系统

- 进行恶意网络操作

- 促进非法商品交易

但公司表示,在合同框架下,会为某些政府客户提供“精心校准的例外条款”,以支持其合法职责。

这意味着,对于像国防部、国家安全局等机构来说,AI 的使用边界正在被重新定义 —— 在保障公共利益的同时,也要防止滥用带来的社会风险。

AI 与国家安全:机遇与争议并存

AI 在政府和军事领域的应用并非新鲜事,但随着技术能力的增强,其影响也愈加深远:

✅ 积极面:

- 提高情报分析效率

- 支持快速决策与资源调度

- 降低人工误判率

❗ 潜在风险:

- 加剧监控与隐私侵犯问题

- 算法偏见可能放大执法不公(如人脸识别错误导致误捕)

- 国家间的技术军备竞赛升温

此前,微软、谷歌、亚马逊等企业因向以色列等国提供 AI 技术而引发员工抗议和社会运动,例如“No Tech for Apartheid”。

因此,如何在推动技术进步与维护伦理底线之间取得平衡,成为所有参与者必须面对的问题。

与 OpenAI 的正面交锋

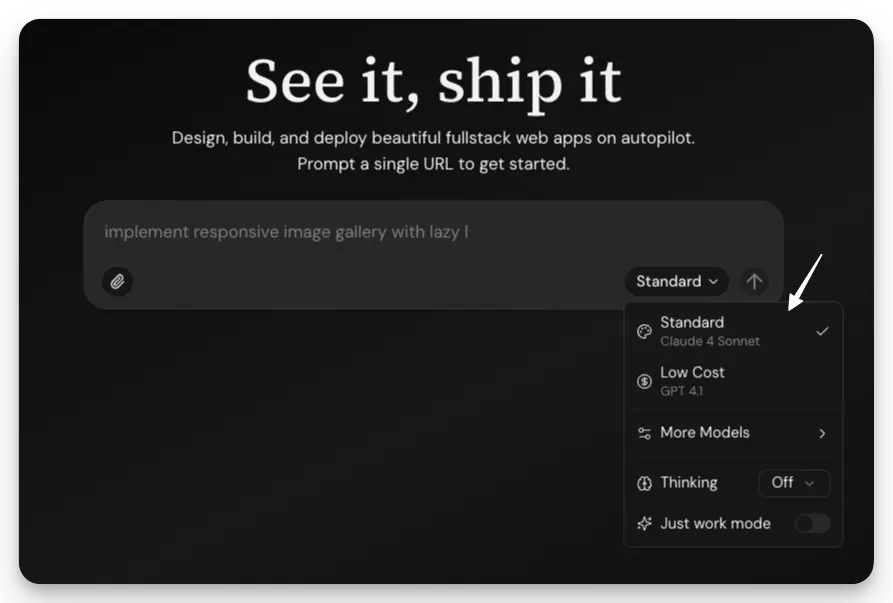

Claude Gov 的推出,显然是对 OpenAI 今年初推出的 ChatGPT Gov 的直接回应。

OpenAI 曾透露,已有超过 9 万名联邦、州和地方政府人员使用其 AI 技术,用于:

- 文档翻译与摘要生成

- 政策文件起草

- 编写代码与构建应用程序

相比之下,Anthropic 虽未公布具体客户数据,但已加入 Palantir 的 FedStart 计划,表明其正积极拓展联邦市场。

此外,Scale AI(为多家大厂提供训练数据的平台)也在近期与美国国防部签署 AI 代理协议,并将业务扩展至全球政府领域,显示出该赛道的热度持续上升。

相关文章