在AI助手框架层出不穷的当下,多数框架要么体积庞大、学习成本高,要么侧重海外生态(如适配OpenAI、Telegram等),难以满足国内企业/开发者对“国产大模型+国产通讯软件”的轻量化需求。

Mozi(墨子)正是针对这一痛点打造的轻量级AI助手框架——仅用约16000行代码(仅为同类全功能框架的3%),实现了AI助手的核心能力,且全程聚焦国产生态:统一接口对接DeepSeek、豆包、Qwen、Kimi等主流国产大模型,原生支持QQ、飞书、钉钉、企业微信等国内通讯平台,代码简洁高效,既适合快速部署使用,也极易二次开发和学习Agent底层原理。

核心定位:国产生态优先的轻量AI助手框架

Mozi的核心目标是“用极简代码实现核心功能”,与同类框架(如Moltbot)相比,定位和优势十分明确:

| 特性 | Mozi(墨子) | Moltbot |

|---|---|---|

| 定位 | 国产生态优先的轻量框架 | 全功能个人AI助手 |

| 代码量 | ~16,000行(64文件) | ~516,000行(3,137文件) |

| 国产通讯支持 | QQ、飞书、钉钉、企业微信原生支持 | 侧重WhatsApp/Telegram等 |

| Node.js版本 | >= 18 | >= 22 |

| 适用场景 | 企业内部机器人、国内团队协作 | 个人多设备助手、海外集成 |

| 学习门槛 | 代码简洁清晰,适合学习Agent原理 | 代码庞大,学习成本高 |

简单来说,如果你需要快速搭建适配国内办公场景的AI助手,或想学习AI Agent的核心架构,Mozi会是最优选择——它没有冗余功能,只聚焦“多模型对接、多平台适配、核心Agent能力”三大核心,开箱即用且易扩展。

核心特性:7大模块+N项实用能力,覆盖AI助手全场景

Mozi的架构按功能拆分为7个核心模块,职责清晰,便于理解和扩展:

| 模块 | 目录 | 核心职责 |

|---|---|---|

| Agent | src/agents/ | 消息循环、上下文压缩、会话管理、模型失败重试 |

| Providers | src/providers/ | 统一模型调用接口,兼容OpenAI/Anthropic格式 |

| Tools | src/tools/ | 工具注册/校验/执行,支持自定义扩展 |

| Skills | src/skills/ | 技能系统,通过SKILL.md注入专业知识 |

| Channels | src/channels/ | 通讯通道适配,统一消息格式(长连接支持) |

| Sessions | src/sessions/ | 会话持久化,支持内存/文件存储 |

| Gateway | src/gateway/ | HTTP/WebSocket服务,路由分发 |

在此基础上,Mozi还提供了多项开箱即用的核心能力,覆盖AI助手的核心需求:

1. 多模型无缝对接,优先适配国产大模型

支持DeepSeek、豆包、通义千问(DashScope)、智谱AI、Kimi、阶跃星辰、MiniMax等全品类国产大模型,同时兼容OpenAI/Anthropic格式的海外模型,还支持自定义API接口(如vLLM、Ollama本地部署模型),只需配置API Key即可快速切换。

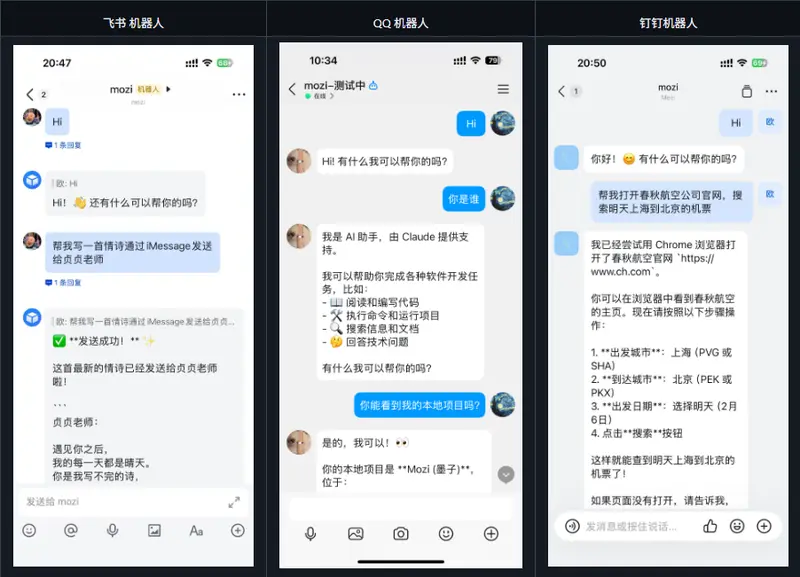

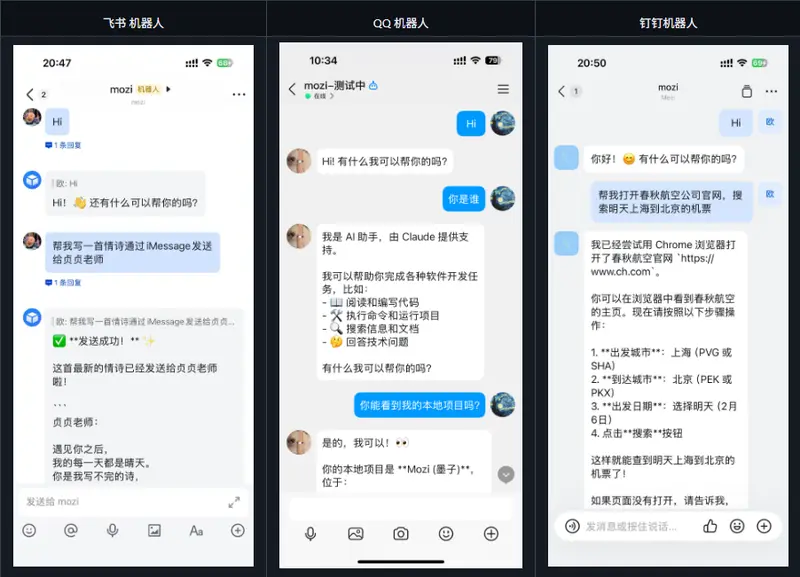

2. 多通讯平台适配,无需公网IP(多数场景)

原生支持QQ、飞书、钉钉(WebSocket/Stream长连接模式,无需公网IP)、企业微信(Webhook回调模式),所有平台采用统一的消息处理接口,开发时无需为不同平台单独适配逻辑:

- 飞书/钉钉/QQ:长连接模式,启动即可接收消息,无需配置回调地址;

- 企业微信:Webhook模式,仅需公网IP即可完成回调配置。

3. 智能上下文压缩,避免Token超限

对话历史超过模型Token限制时,Mozi会自动执行智能压缩,保证对话连贯性的同时控制Token消耗:

- 保留策略:始终保留系统提示词和最近N轮对话;

- 摘要压缩:将早期对话压缩为摘要,保留关键信息;

- 工具结果裁剪:截断过长的工具返回结果;

- 配对验证:确保tool_call和tool_result成对出现。

4. 25个内置工具+可扩展插件,覆盖日常需求

内置文件读写、Bash执行、网页获取、图像分析、浏览器自动化、记忆系统、定时任务等25类工具,满足办公、开发、自动化等场景;同时支持插件系统,可通过简单的代码注册自定义工具/事件钩子,扩展无上限。

5. 记忆系统+定时任务,实现“有记忆的AI助手”

- 记忆系统:自动跨会话记住用户偏好、关键信息,支持存储/查询/列出记忆,无需用户手动触发;

- 定时任务:支持一次性、周期性、Cron表达式三种调度方式,可让AI定时执行任务(如生成日报、发送提醒),并将结果主动投递到飞书/钉钉/QQ等通道。

6. Skills技能系统,零代码扩展AI能力

无需修改框架代码,只需编写SKILL.md文件(YAML+Markdown格式),即可为AI注入专业知识、自定义行为规则(如智能问候、行业话术),支持多优先级加载(内置<用户级<工作区级),同名技能自动覆盖,适配不同场景的个性化需求。

快速开始:3步搞定部署,零基础也能上手

Mozi的部署和配置极度简化,支持全局安装、源码克隆、Docker部署三种方式,这里以最常用的全局安装为例,零基础也能5分钟启动:

环境要求

Node.js >= 18(npm/pnpm/yarn均可),支持macOS/Linux/Windows跨平台。

1. 安装

# 全局安装(推荐,快速使用)

npm install -g mozi-bot

# 或克隆源码(适合二次开发)

git clone https://github.com/King-Chau/mozi.git

cd mozi && npm install && npm run build

2. 配置(可视化向导,无需手动改配置文件)

运行配置向导,按提示完成模型、通讯平台、服务器等配置:

mozi onboard

向导会引导你配置:

- 国产模型API Key(DeepSeek/豆包/通义千问等);

- 通讯平台参数(飞书appId/钉钉appKey/QQ appId等);

- 记忆系统、服务器端口等基础配置;

配置文件会自动保存到~/.mozi/config.local.json5,无需手动编写。

3. 启动

# 仅启动WebChat(无需配置通讯平台,快速体验)

mozi start --web-only

# 启动完整服务(含WebChat+QQ+飞书+钉钉)

mozi start

# 自定义端口启动

mozi start --port 8080

启动后访问http://localhost:3000即可打开WebChat界面,直接和AI助手对话;访问http://localhost:3000/health可查看服务健康状态。

进阶使用:Docker部署+完整配置示例

如果需要在服务器/团队环境部署,Mozi提供完整的Docker支持,支持环境变量配置、数据持久化,无需担心依赖问题:

Docker Compose部署(推荐)

# docker-compose.yml示例

services:

mozi:

image: mozi-bot:latest

command: ["start", "--web-only"] # 移除--web-only启用完整模式

ports:

- "3000:3000"

volumes:

- mozi-data:/home/mozi/.mozi # 数据持久化

- ./config.local.json5:/app/config.local.json5:ro # 挂载自定义配置

environment:

- PORT=3000

- LOG_LEVEL=info

- DEEPSEEK_API_KEY=sk-xxx # 配置模型API Key

- FEISHU_APP_ID=xxx # 配置飞书(需移除--web-only)

- FEISHU_APP_SECRET=xxx

volumes:

mozi-data: # 持久化日志、记忆、定时任务等数据

启动命令:

# 构建并启动

docker compose up -d --build

# 查看日志

docker compose logs -f

# 停止服务

docker compose down

完整配置示例(参考)

如果需要手动调整配置,可参考以下格式(支持json5/yaml格式):

{

// 模型提供商配置

providers: {

deepseek: { apiKey: "sk-xxx" },

dashscope: {

apiKey: "sk-xxx",

models: [{ id: "qwen-max-latest", name: "通义千问 Max", contextWindow: 32768 }]

}

},

// 通讯平台配置

channels: {

feishu: { appId: "cli_xxx", appSecret: "xxx" },

dingtalk: { appKey: "xxx", appSecret: "xxx" },

qq: { appId: "xxx", clientSecret: "xxx", sandbox: false }

},

// Agent基础配置

agent: {

defaultProvider: "deepseek",

defaultModel: "deepseek-chat",

temperature: 0.7,

systemPrompt: "你是墨子,一个智能助手。"

},

// 服务器配置

server: { port: 3000, host: "0.0.0.0" },

// 记忆/技能系统配置

memory: { enabled: true },

skills: { enabled: true }

}

适合谁用?

- 企业开发者:快速搭建适配国内办公场景的AI机器人(如飞书/钉钉智能助手),无需从零开发多模型/多平台对接逻辑;

- 学习型开发者:想了解AI Agent核心原理(消息循环、上下文管理、工具调用),Mozi代码简洁,1.6万行代码覆盖完整核心逻辑,易读易理解;

- 个人开发者:需要轻量级、易扩展的AI助手框架,适配国产大模型和通讯软件,避免海外框架的“水土不服”。

Mozi的核心优势在于“轻量且聚焦”——不堆砌冗余功能,只解决国内场景下AI助手的核心需求,同时保持代码的简洁性和可扩展性。如果你正在寻找适配国产生态的AI助手框架,或是想学习Agent架构,Mozi绝对值得一试。

数据统计

相关导航

OpenClaw-Docker-CN-IM

AnyGen

Kimi Claw

Lumine

II-Agent

DeepAnalyze

TradingAgents 中文增强版