Genesys

Genesys 代表了 AI 自我演化的前沿方向 —— 让 LLM 代理自主设计更强大的 LLM。它不仅是一个工具,更是一种全新的研究范式。如果你对自动化模型设计、遗传编程、LLM 架构优化感兴趣,不妨亲自体验 Genesys,看看 AI 如何“设计自己”。

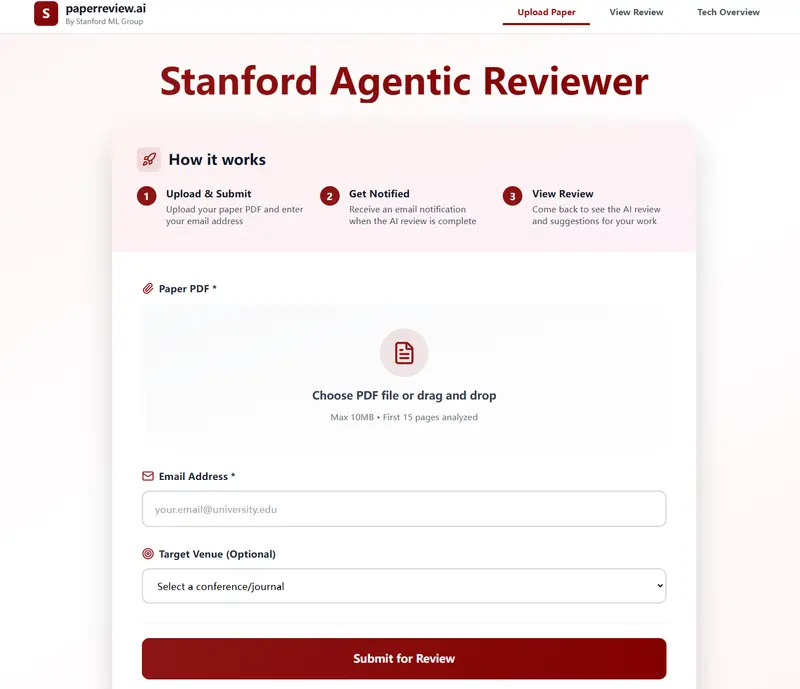

Stanford Agentic Reviewer 不追求“AI 审稿人”的噱头,而是务实解决一个困扰无数研究者的问题:如何在投稿前获得高质量、可操作的反馈。对于希望快速迭代论文、提升录用概率的科研人员,这是一个值得尝试的免费工具。

写完论文,却要等半年才能收到审稿意见?更糟的是,反馈常常是“这篇工作不够新颖”,却不说哪里不够、怎么改。

为解决这一科研痛点,Andrew Ng 与斯坦福团队推出了 Stanford Agentic Reviewer —— 一个代理型 AI 论文评审工具,旨在为研究者提供快速、具体、可操作的改进建议,大幅缩短论文迭代周期。

整个过程完全自动化,无需人工介入。

项目灵感来自一位学生的真实经历:3 年内被拒 6 次,每轮审稿间隔 6 个月,且反馈多为模糊评判,缺乏建设性。

传统同行评审的两大问题:

Agentic Reviewer 的目标不是取代人类审稿,而是在正式投稿前提供早期反馈,帮助研究者:

系统采用多步代理工作流,确保评审基于最新研究:

注:因依赖 arXiv 数据,在 AI、机器学习等高公开度领域效果最佳,其他领域可能受限。

团队用 ICLR 2025 的真实审稿数据训练模型,并测试评分一致性(Spearman 相关系数):

当目标会议设为 ICLR 时,系统会输出 1–10 分的综合评分;其他情况仅提供维度分析与建议。

团队认为,这仅是AI 辅助科研自动化的起点。未来可能扩展至: