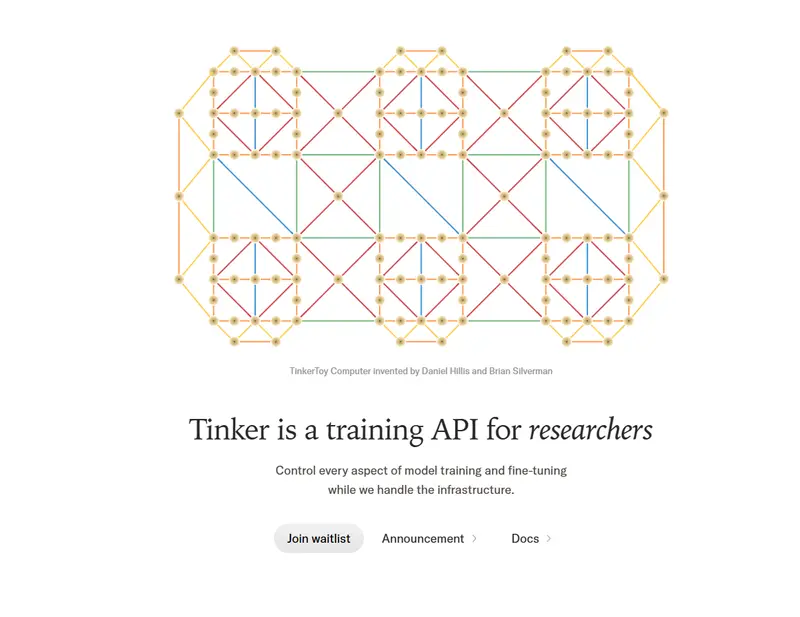

由前 OpenAI 首席技术官 Mira Murati 创立的 AI 初创公司 Thinking Machines Lab(思维机器实验室),正式推出 Tinker ——一个面向研究人员和开发者的灵活 API,用于微调开源语言模型。

它的目标很明确:降低高质量模型定制的技术门槛,把控制权交还给使用者。

你负责算法设计与数据选择,我们负责分布式训练背后的复杂工程。从实验到规模化运行,Tinker 为你屏蔽底层基础设施的负担。

为什么是 Tinker?

在当前的 AI 研究中,尽管许多强大模型已开源,但真正高效地微调它们仍面临诸多挑战:

- 训练集群配置复杂

- 资源调度难管理

- 多任务并行成本高

- 实验迭代周期长

Tinker 的出现正是为了应对这些问题。它不是另一个黑盒式训练平台,而是一个注重灵活性与透明度的工具链,特别适合需要精细控制训练过程的研究型用户。

核心特性

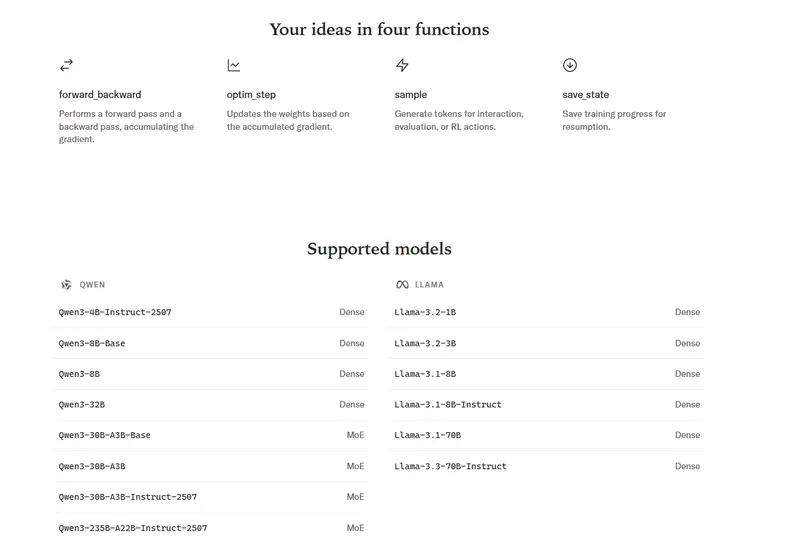

支持多种模型,切换只需一行代码

Tinker 支持一系列开源权重模型,涵盖从小规模到超大规模的架构,包括:

- Llama 系列

- Qwen 系列(如 Qwen-235B-A22B)

- 其他主流开源模型

更重要的是,在不同模型间切换仅需修改 Python 代码中的一个字符串参数。无需重新配置环境或调整依赖。

基于 LoRA 的高效训练架构

Tinker 使用 LoRA(Low-Rank Adaptation) 技术进行参数高效微调。这带来了两个关键优势:

- 显著降低显存和计算资源需求;

- 多个训练任务可共享同一计算池,提升资源利用率,降低成本。

这意味着你可以同时运行多个小型实验,而不会因资源隔离导致浪费。

完全托管的服务体验

Tinker 是一个运行在 Thinking Machines Lab 自建训练集群上的托管服务。我们自动处理:

- 计算资源调度

- 分布式任务分配

- 故障检测与恢复

你无需维护 GPU 集群或编写复杂的运维脚本,即可立即启动从小批量测试到大规模训练的各种任务。

低层级 API + 高层级实现支持

Tinker 提供细粒度的底层原语,例如:

forward_backward:执行前向与反向传播sample:生成采样输出

这些接口足以表达大多数现代后训练方法(post-training),如监督微调(SFT)、奖励建模、强化学习(RLHF/RLAIF)等。

但我们也知道,要获得稳定结果,细节至关重要。为此,我们同步发布了开源项目:

Tinker Cookbook

一个基于 Tinker API 构建的代码库,包含多种主流训练方法的标准实现,帮助用户快速上手并复现实验。

真实研究案例:这些团队已经在用 Tinker

多家顶尖学术机构和研究组织已参与早期测试,并取得了实质性进展:

| 团队 | 应用场景 |

|---|---|

| 普林斯顿 Gödel 团队 | 训练数学定理证明专用模型,提升形式化推理能力 |

| 斯坦福 Rotskoff 化学团队 | 微调模型完成化学分子描述与反应预测任务 |

| 伯克利 SkyRL 团队 | 在自定义异步非策略强化学习循环中开展多代理、多轮工具调用实验 |

| Redwood Research | 对 Qwen3-32B 模型应用强化学习,探索困难条件下的 AI 行为控制 |

这些案例表明,Tinker 不仅适用于标准微调任务,也能支撑高度定制化的科研需求。

关于定价

Tinker 将以免费模式启动,鼓励更多研究者尝试和反馈。

我们计划在未来几周内引入 基于使用量的计费机制,具体细则将提前公布,确保透明合理。

数据统计

相关导航

BMAD-METHOD

Magnitude

DiffSynth-Studio

Cosmo

PageLM

ThinkFlow AI

NEXA AI