GitLab Duo

GitLab Duo 的出现,代表 AI 在软件开发中的角色正在发生本质变化:从“辅助工具”到“协作成员”,从“单点提效”到“流程重构”。它不一定立刻替代人类工程师,但确实为开发者提供了一种新的可能性:你可以不再事无巨细地动手编码,而是专注于更高层次的设计与决策,把执行交给一个由 AI 构成的虚拟团队。

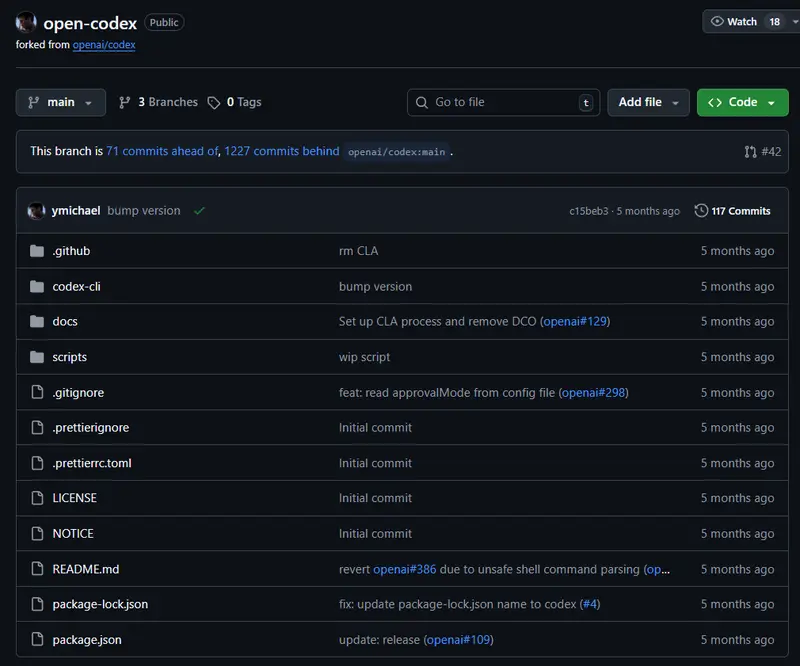

Open Codex CLI 是一个可在本地终端运行的轻量级编码助手,基于原始 OpenAI Codex CLI 项目分支重构,旨在提供更灵活、开放的 AI 编程支持。它允许开发者直接在命令行中生成代码、解释逻辑或优化脚本,无需离开开发环境。

Open Codex CLI 是一个可在本地终端运行的轻量级编码助手,基于原始 OpenAI Codex CLI 项目分支重构,旨在提供更灵活、开放的 AI 编程支持。它允许开发者直接在命令行中生成代码、解释逻辑或优化脚本,无需离开开发环境。

该项目并非闭源工具的替代品,而是一次面向开放生态的改进尝试——通过标准化接口,兼容多种主流 AI 模型服务,让开发者自主选择后端引擎。

此分支在原项目基础上进行了关键升级,主要差异如下:

不再绑定单一模型服务商,现已支持:

这意味着你可以在云端高性能模型和本地私有部署之间自由切换。

采用与 OpenAI 兼容的 chat completions 接口标准,而非旧式 completions API。这一变更带来两大优势:

除底层通信机制外,其他功能保持与原始项目一致:

通过 npm 全局安装:

npm install -g open-codex

根据所用服务商,在项目根目录或用户配置中设置对应密钥,例如:

OPENAI_API_KEY=sk-xxxxxx

GEMINI_API_KEY=ya29.xxxxxx

OPENROUTER_API_KEY=or-xxxxxx

OLLAMA_HOST=http://localhost:11434

# 解释当前文件

codex explain

# 生成一个 Node.js HTTP 服务器

codex "create a simple http server in nodejs"

# 优化选定代码块

codex optimize < code.js

更多命令可通过 codex --help 查看。

Open Codex CLI 特别适合以下使用情境:

由于其轻量特性,启动速度快,响应即时,是“小任务、高频调用”场景下的理想选择。

⚠️ 请注意:Open Codex CLI 当前仍处于活跃开发阶段,属于实验性工具,可能存在以下情况: