AIMedia

AIMedia 是一款全自动托管式 AI 媒体系统。它集热点抓取、AI 创作、图像生成、跨平台发布于一体,目标是实现“无人值守”的内容生产流水线。

在学习 CUDA 与 GPGPU 编程的过程中,开发者 yassa9 提出了一个朴素但深刻的问题:

“为什么不从头实现一个 LLM 推理引擎?”

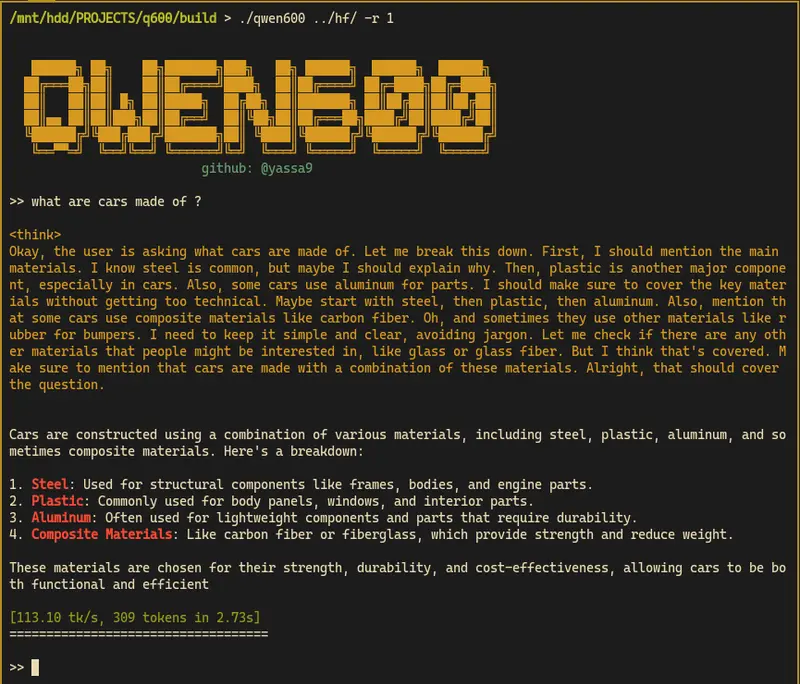

由此诞生了 qwen600 ——一个专为 QWEN3-0.6B 指令模型设计的静态小型推理引擎,完全使用 CUDA C/C++ 实现,无 Python 运行时依赖(仅分词器配置阶段除外),可在 RTX 3050 8GB 等消费级显卡上流畅运行。

该项目的核心目标不是追求商业级性能,而是构建一个用于深入理解 LLM 与 Transformer 架构的教育工具,同时实践现代 CUDA 编程技巧。

根据开发者提供的基准测试数据,qwen600 在 tokens/sec 指标上表现优异:

⚠️ 注:测试环境为相同模型(QWEN3-0.6B)、bf16 精度、单批次(batch=1)场景,实际性能受硬件和实现细节影响。

这一结果得益于对内存访问、计算调度和 GPU 资源的精细控制。

| 特性 | 说明 |

|---|---|

| 纯 CUDA 实现 | 全部核心逻辑使用 CUDA C/C++ 编写,不依赖 PyTorch 或 Python 运行时 |

| 最小化依赖 | 仅使用 cuBLAS(矩阵乘)、CUB(并行原语)和标准 IO 库 |

| bf16 支持 | 利用现代 GPU 的 Tensor Core 提升计算效率,降低显存占用 |

| 静态编译优化 | 权重作为静态常量嵌入,支持编译时优化,减少运行时开销 |

| 高效内存管理 |

mmap 映射模型权重,避免内存复制qwen600 的设计深受 suckless 哲学影响——功能最小化,性能最大化。

其核心原则包括:

config.h 中,编译时确定;它不是另一个“黑盒式”推理库,而是一个可以逐行阅读、理解并修改的 LLM 执行体。

qwen600 融合了多个开源项目的优秀设计思想:

| 项目 | 启发点 |

|---|---|

| llama.cpp / ggml | 极简架构与本地推理理念 |

| llama2.c(Andrej Karpathy) | 教学导向的代码组织方式 |

| LLMs-from-scratch(Sebastian Raschka) | 从零实现 Transformer 的教育思路 |

| qwen3.c(Adrian Cable) | 小模型 + CUDA 原生实现的可行性验证 |

在此基础上,qwen600 进一步强化了 GPU 原生优化 与 内存效率,更适合在资源受限设备上运行。