如果你经常处理大量文献、撰写深度报告,或在团队中协作推进研究项目,你可能早已意识到:当前大多数 AI 工具在复杂研究任务中缺乏结构、透明度和控制力。

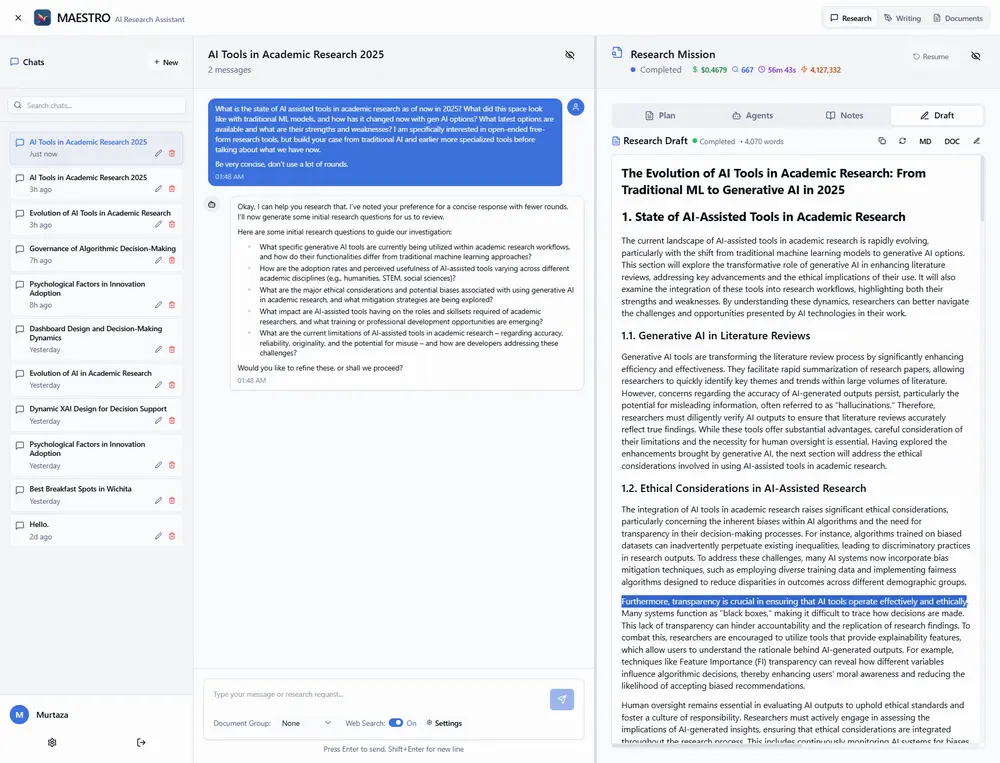

MAESTRO是一款可在本地硬件上完全自托管的 AI 研究平台,专为学者、分析师、开发者和内容创作者设计,支持多用户协作,致力于将 AI 融入严谨、可审计的研究流程。

从问题定义到最终报告生成,MAESTRO 不依赖单一模型“猜意图”,而是通过一套结构化的多代理系统,自动化完成规划、调研、反思与撰写全过程。

整个过程可追溯、可审查、可定制——真正把控制权交还给研究者。

一种新的研究方式:从“提问-回答”到“协作研究”

传统 AI 工具通常止步于“你问,它答”。而 MAESTRO 的目标是成为你的研究协作者。

你只需:

- 提出研究问题

- 上传相关文档(PDF、技术论文、报告等)

- 设定研究范围与深度

接下来,一个由多个 AI 代理组成的“研究团队”将启动工作:分工协作、交叉验证、迭代优化,最终交付一份结构完整、引用清晰的研究报告。

这个过程不是线性的,而是模拟人类研究者的批判性思维路径——不断提问、验证、修正。

核心功能:让研究更系统、更可控

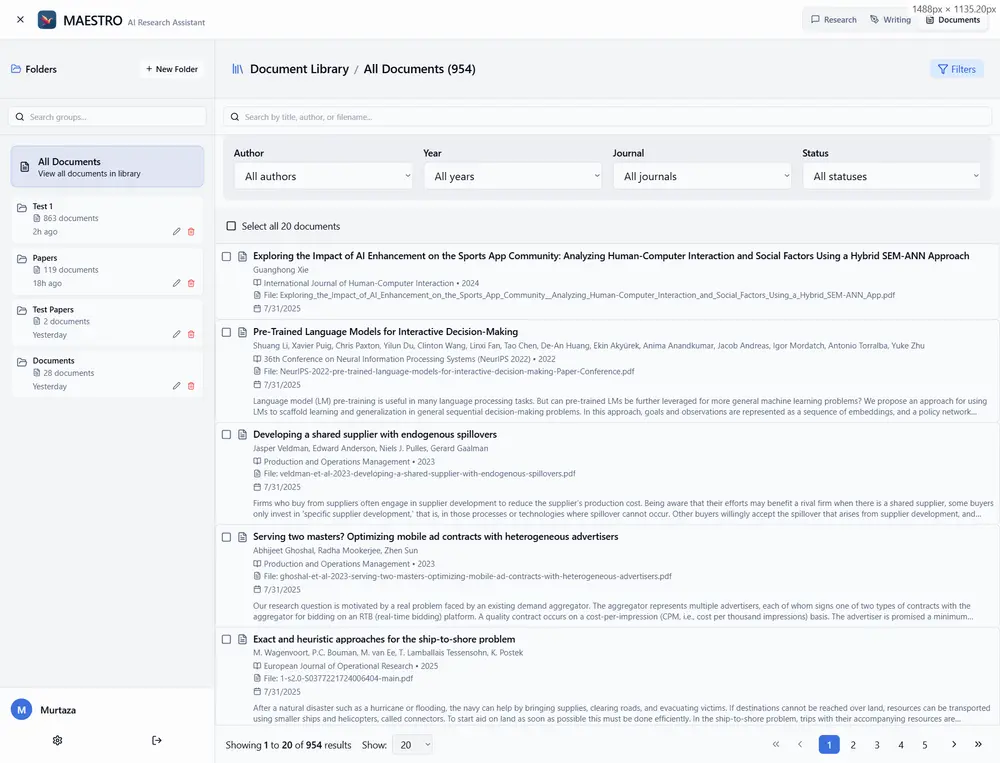

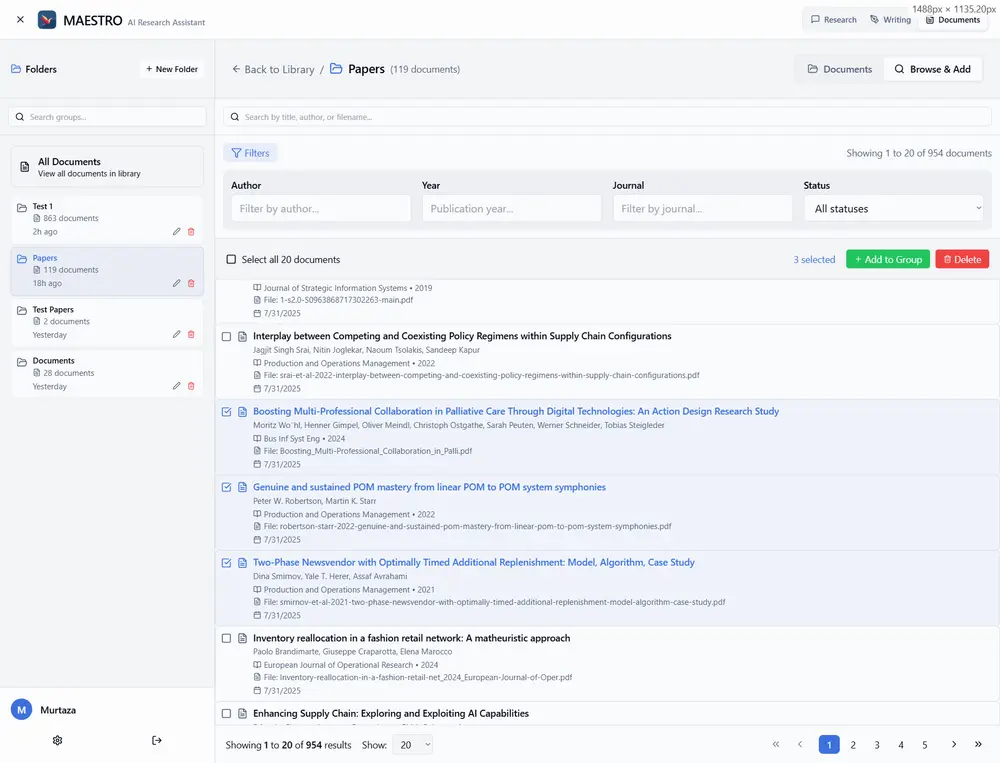

📚 统一管理文档库

将你的 PDF 文献集中存储在本地文档库中。MAESTRO 使用优化的 RAG(检索增强生成)管道,专为学术与技术文档设计,确保 AI 能精准提取关键信息。

支持批量导入、元数据提取与全文索引。

🗂️ 创建文档组,聚焦研究主题

为不同项目创建独立的文档组。例如:

- “大模型安全评估”项目组

- “气候政策比较”资料集

这样可引导 AI 仅从指定资源中获取信息,避免干扰,提升研究准确性。

🔍 聊天驱动,灵活交互

通过自然语言对话发起研究任务:

“比较 Transformer 与 State Space Models 在长序列建模中的优劣,并引用我上传的五篇论文。”

系统会自动生成研究计划,并开始执行。

也可随时提问获取快速洞察,或让写作助手帮你起草段落、总结发现。

🧠 多代理协同,分工明确

MAESTRO 并非单一模型,而是一个由多个专业 AI 代理构成的协作系统。每个代理各司其职:

| 代理 | 角色 |

|---|---|

| 代理控制器 | 协调全局流程,调度任务 |

| 规划代理 | 制定研究计划与报告大纲 |

| 研究代理 | 检索文档与网络资源,生成结构化笔记 |

| 反思代理 | 审查证据完整性,识别逻辑漏洞 |

| 写作代理 | 整合内容,撰写连贯报告 |

这种分工机制,使研究过程更具系统性与可验证性。

研究流程:不是一次生成,而是反复打磨

MAESTRO 的核心优势在于其迭代式研究机制,模拟真实研究中的“探索-反思-修正”循环。

🔁 研究-反思循环

- 研究代理完成首轮资料收集

- 反思代理介入评估:

- 是否存在证据空白?

- 来源之间是否冲突?

- 是否出现新线索需要跟进?

- 若发现问题,触发新一轮研究,甚至调整原始计划

这一过程动态进行,复杂主题可经历多次迭代,直到证据充分、逻辑闭合。

✍️ 写作-反思循环

报告撰写同样非一稿定音:

- 写作代理根据 ResearchNotes 生成初稿

- 反思代理审查:

- 论点是否清晰?

- 逻辑是否连贯?

- 是否忠实于原始证据?

- 返回修改,直至达到质量标准

最终输出的不仅是文本,更是可追溯的研究链条。

完全透明:你能看到 AI 是怎么“想”的

许多 AI 工具输出结果却不解释过程。MAESTRO 正好相反。

你可以在界面上查看:

- AI 生成的研究大纲

- 每条引用的来源文档与位置

- 研究代理的探索路径

- 反思代理的评审意见

- 任务执行的实时日志

所有中间产物(如 ResearchNote)均可审查,确保结果可信、可复现。

自托管设计:数据不出内网,隐私与安全优先

MAESTRO 支持100% 本地部署,所有数据保留在你的服务器上。

✅ 支持私有化模型接入

- 可配置使用本地运行的大语言模型(如 Llama 3、Qwen 等)

- 兼容 OpenAI API 格式,便于切换后端

- 无需将敏感文档上传至第三方服务

🔍 隐私搜索集成

网络搜索通过 SearXNG 实现——一个开源、无追踪的元搜索引擎,可部署在本地,避免暴露查询行为。

这意味着:从文档分析到网络检索,整个研究流程可在封闭环境中完成。

技术架构:现代、解耦、易部署

MAESTRO 采用模块化设计,便于维护与扩展。

| 组件 | 技术栈 |

|---|---|

| 后端 | FastAPI(Python) |

| 前端 | React + Vite + TypeScript,Tailwind CSS |

| 数据库 | SQLite(支持迁移至 PostgreSQL) |

| 实时通信 | WebSocket |

| 部署 | Docker Compose |

🐳 快速启动

只需具备以下条件即可部署:

- Docker 与 Docker Compose

- Git(用于克隆仓库)

- 推荐配备 NVIDIA GPU(提升推理速度)

- 约 5GB 磁盘空间(首次运行自动下载模型)

首次启动后,系统将自动拉取所需模型并初始化服务。

高级用户可通过 CLI 工具执行批量文档导入、用户管理等操作。详细说明见项目文档中的

DOCKER.md。

许可模式:开源与商业并行

MAESTRO 采用双重许可策略:

- 开源版:遵循 GNU AGPLv3 许可,可自由使用、修改与分发

- 商业版:为无法满足 AGPL 要求的企业提供独立授权,支持私有部署与技术支持

如需商业授权,请联系项目维护者。

谁适合使用 MAESTRO?

- 学者与研究生:快速综述文献,生成开题报告或论文初稿

- 政策分析师:整合多方资料,输出结构化评估报告

- 技术团队:研究新技术方案,生成内部技术白皮书

- 独立作者与记者:深入调查议题,确保信息来源可追溯

它不是替代思考的“黑箱”,而是增强研究能力的“显微镜”。

数据统计

相关导航

Wonderful

II-Agent

海螺AI

DeepSeek Cowork

豆包

News Agents

Agent Skills