在开发 AI智能体的过程中,你是否遇到过这些问题?

- 修改提示词后,原本能完成的任务突然失败;

- 新增一个工具,却意外破坏了多轮对话的逻辑;

- 想验证 智能体 在复杂场景下的表现,但缺乏系统化的测试手段。

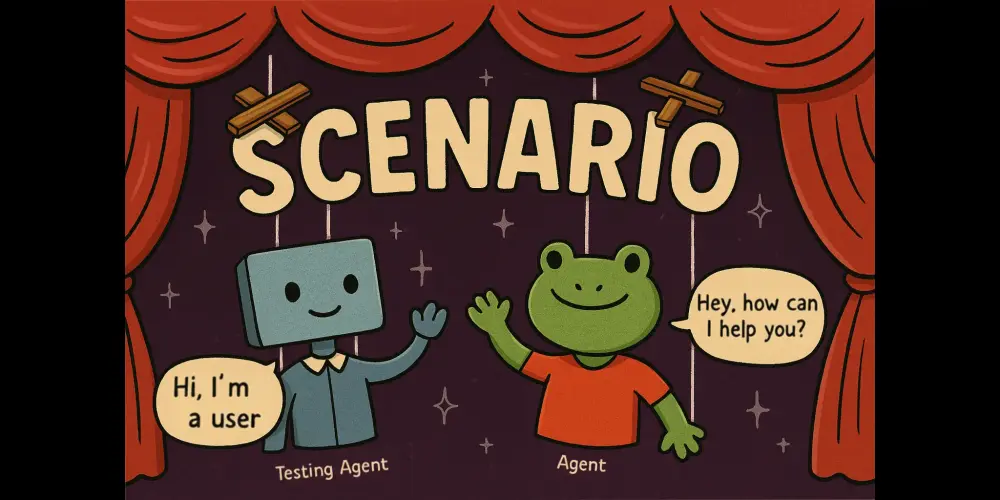

传统的单元测试难以覆盖智能体的非确定性行为,而人工测评又效率低下、不可复现。为此,Scenario 应运而生——一个专为 AI 智能体设计的仿真测试框架。

它不依赖固定数据集,也不绑定特定框架,而是通过模拟真实用户交互,对 智能体 进行端到端的行为验证,帮助你在迭代中守住质量底线。

什么是 Scenario?

Scenario 是一个基于仿真的智能体(Agent)测试框架,旨在解决 AI 智能体 开发中的核心挑战:

如何在动态、多轮、非确定性的环境中,确保 智能体 行为的一致性和可靠性?

它的核心能力是:

- ✅ 模拟用户行为,发起多轮对话;

- ✅ 在任意对话阶段插入评估逻辑;

- ✅ 验证 智能体 对边缘情况的处理能力;

- ✅ 支持与任何 LLM 评估体系集成。

无论你使用的是 LangChain、LlamaIndex、AutoGen,还是自研架构,只要实现一个 call() 方法,就能快速接入 Scenario。

目前支持语言:Python、TypeScript、Go

为什么需要专门的 智能体 测试框架?

传统软件测试基于确定性逻辑,而 AI 智能体 具有以下特性:

- 输出不可预测

- 决策路径依赖上下文

- 工具调用具有副作用

- 用户意图多样且模糊

这意味着,仅靠“输入-输出”比对无法有效衡量其质量。

Scenario 提供了一种更贴近实际运行环境的测试方式:通过仿真用户交互流程,在真实对话流中进行观察与判断。

这让你不仅能测“能不能跑”,还能测“跑得对不对”。

三层质量保障体系

Scenario 支持从底层到高层的完整测试闭环,帮助团队构建可信赖的 智能体 系统:

第一层:单元测试(Unit Testing)

验证 智能体 中各个组件的功能正确性:

- 工具函数能否正常调用?

- 参数解析是否准确?

- 外部 API 调用是否符合预期?

这是最基础的质量防线,适用于所有代码模块。

第二层:评估与优化(Evaluation & Tuning)

聚焦非确定性部分的性能度量:

- RAG 检索结果的相关性

- 提示词调整前后响应质量的变化

- 偏好模型(如 GRPO)下的行为一致性

Scenario 可对接任何评估框架(如 DeepEval、LangSmith、Argilla),支持自动化打分与对比分析。

第三层:代理仿真(智能体 Simulation)

这才是 Scenario 的核心优势所在。

通过预设多种用户行为模式,模拟真实交互场景:

- 正常流程:用户按预期顺序提问

- 中断插话:中途改变话题或提出澄清

- 边缘情况:提供模糊指令、错误信息或极端输入

例如:

用户:帮我订明天上午的会议室

→ 智能体 开始流程

用户:等等,改成下午吧

→ 测试 智能体 是否能正确中断并更新状态

这类复杂交互很难用静态测试覆盖,但却是用户体验的关键。

核心功能一览

🧪 真实行为测试

不同于 mock 或 stub,Scenario 调用的是你的 真实 智能体 实例,通过 call(prompt) 接口与其交互,捕捉其真实输出与状态流转。

🔍 多轮控制与中间评估

你可以在每一轮对话后插入断言,检查:

- 是否调用了正确的工具?

- 内部状态是否更新?

- 是否遗漏关键信息?

result = await scenario.step("我想查北京天气")

assert result.tool_calls[0].name == "get_weather"

⚙️ 框架无关设计

无需重构现有项目。只需实现一个简单的 call() 方法接口:

def call(self, messages: List[Dict]) -> str:

# 接入你的 智能体 主逻辑

return 智能体_response

即可将任意 智能体 接入测试流程。

📜 脚本化仿真(Scripted Simulation)

支持编写结构化测试脚本,精确控制用户行为序列:

test("reschedule meeting", async () => {

await given.userSays("安排一个会议");

await and.userSays("取消,我要改时间");

await then.智能体Should("ask for new time");

});

适合回归测试与 CI/CD 集成。

🐞 调试模式(Interactive Debug Mode)

提供逐步执行能力,像调试普通程序一样查看每一步的输入、输出与决策路径,便于定位问题。

🔄 测试运行器集成

原生支持主流测试框架:

- JavaScript/TypeScript:Vitest、Jest

- Python:pytest

- Go:testing 包

可轻松嵌入现有 CI 流程,实现自动化回归检测。

适用场景

Scenario 特别适合以下类型的项目:

- 客服机器人:验证多轮对话连贯性

- 助手类 智能体:测试任务中断与恢复能力

- 自主规划 智能体:评估长期目标维持能力

- 多工具协同系统:检查工具调用顺序与条件判断

无论是初创团队做原型验证,还是大厂构建生产级 智能体,Scenario 都能成为你质量保障链路中的关键一环。

数据统计

相关导航

AGENTS.md

xpander.ai

DeepAnalyze

MuleRun

Oreate

Eigent AI

SkyBot