当前主流的AI智能体严重依赖云端大模型,每一次交互都要将用户数据上传至远程服务器。这种架构不仅带来隐私风险,还导致响应延迟高、持续API调用成本昂贵,难以满足真实移动场景下的实时性与安全性需求。

针对这一问题,香港大学团队开源了 OpenPhone——一款专为智能手机本地运行设计的 30亿参数视觉-语言智能体基础模型。它完全在设备端执行,无需联网、不依赖云端、零API费用,同时在多项任务上展现出接近70–90亿参数模型的性能。

为什么是30亿参数?——手机智能体的“实用甜蜜点”

OpenPhone 的设计哲学并非“越大越好”,而是“恰到好处”。经过对当前移动硬件的全面评估,30亿参数被确认为设备端部署的最佳平衡点:

- ✅ 硬件适配:可在主流消费级GPU(如RTX 3090)及新兴移动NPU(如高通Hexagon)上高效运行,占用显存约6–8GB;

- ✅ 推理速度:单卡3090上推理速度比9B模型快3.5倍,两卡配置下快4倍,平均响应时间低于4.2秒;

- ✅ 能效优势:更小的模型显著降低功耗,延长移动设备续航;

- ✅ 隐私保障:所有计算在本地完成,用户数据永不离开设备;

- ✅ 零运营成本:彻底摆脱按请求计费的云端API依赖。

关键发现:在GUI操作类任务中,OpenPhone-3B 的成功率(SR=15.2%)甚至优于部分7B模型(如Qwen2.5-VL的SR=10.1%),验证了“小模型通过针对性训练可超越大模型”的可行性。

技术亮点:为移动智能体量身打造

1. 原生边缘设计的视觉-语言架构

OpenPhone-3B 是一个专为理解手机屏幕图像 + 执行操作指令而训练的多模态模型。它不仅能看懂界面元素(如按钮、图标、文本框),还能生成结构化的操作序列(如“点击设置 → 选择Wi-Fi → 输入密码”)。

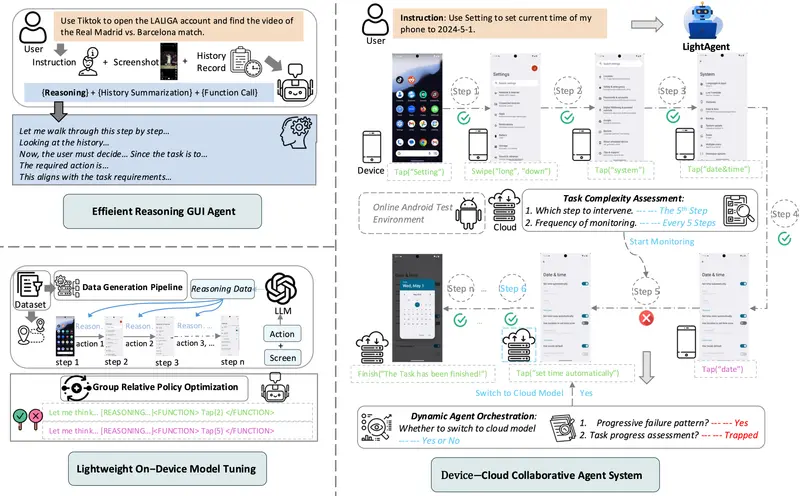

2. 两阶段训练:SFT + 合成数据强化学习

- 第一阶段(SFT):注入基础GUI知识,教会模型识别界面组件与基本操作语义;

- 第二阶段(GRPO风格RL):利用大型多模态模型(MLLM)自动生成高质量推理链,通过强化学习优化任务完成率;

- 结果:在有限参数下显著提升复杂任务的执行能力。

3. 设备-云端协作框架(可选)

虽然OpenPhone支持纯本地运行,但研究团队也提供了一个动态编排框架:

- 实时评估任务复杂度;

- 简单任务由设备端处理,复杂任务自动路由至云端;

- 实测显示,该策略可在保持高成功率的同时,减少约10%的云端API调用。

4. 高效记忆机制:用文本代替截图

为在有限上下文窗口内保留长程历史,OpenPhone将高分辨率屏幕截图压缩为结构化文本描述(如“当前位于微信聊天界面,对方最后一条消息是‘明天几点?’”),从而在10–20步操作中维持有效上下文,避免token浪费。

开源与部署:开箱即用

OpenPhone 不仅是研究原型,更是生产就绪的开源项目:

- 模型权重:已发布于 Hugging Face,支持科研与商用(Apache 2.0 许可);

- 推理优化:提供基于 vLLM 的部署脚本,支持单卡/多卡配置,内存占用低、吞吐量高;

- 训练代码:完整公开两阶段训练流程,包含合成数据生成、SFT、RL微调等模块;

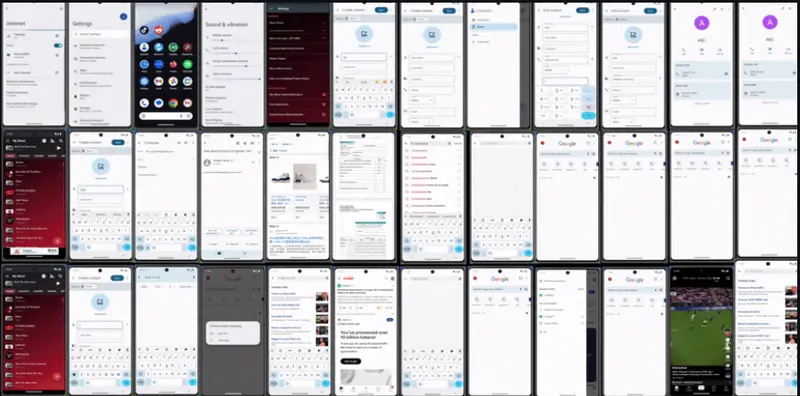

- 评估支持:兼容 AndroidLab 基准测试框架,并扩展了25+真实App任务(如淘宝、微信、设置等)。

⚠️ 注意:原始AndroidLab的Docker镜像与AVD(Android虚拟设备)不兼容,建议在Mac(arm64)上使用AVD进行测试。

性能对比:小模型如何胜过大模型?

| 模型 | GPU配置 | 参数量 | 任务成功率(SR) | 平均单步推理时间 |

|---|---|---|---|---|

| Qwen2.5-VL-7B-Instruct | 1×3090 | 7B | 10.1% | 6289 ms |

| OpenPhone-3B | 1×3090 | 3B | 15.2% | 4171 ms |

| GLM-4.1V-9B-Thinking | 2×3090 | 9B | 24.6% | 14585 ms |

| OpenPhone-3B | 2×3090 | 3B | 15.2% | 3524 ms |

- 速度优势显著:OpenPhone在单卡上比9B模型快3.5倍;

- 部署门槛更低:GLM-9B无法在单卡3090运行,而OpenPhone可;

- 效率-性能权衡明确:若追求极致任务成功率,大模型仍有优势;但若关注响应速度、隐私、成本和边缘部署可行性,OpenPhone是更务实的选择。

适合谁使用?

- AI手机开发者:希望在设备端集成智能体能力,避免云端依赖;

- 开源社区贡献者:可基于OpenPhone构建定制化移动助手;

- 边缘AI研究者:探索小模型在GUI理解、操作生成等任务中的上限;

- 注重隐私的用户:拒绝数据上传,要求所有AI交互本地完成。

数据统计

相关导航

Open-AutoGLM 混合方案

Moltworker

微舆(BettaFish)

MyShell

OxyGent

A2UI

AGENTS.md