LocalAI 是一个免费开源的 AI 平台,为用户提供一个完整的本地 AI 解决方案,替代 OpenAI 和 Anthropic 等云服务。它通过提供 OpenAI API 的本地替代方案,允许用户在本地或本地服务器上运行 AI 模型,包括大语言模型(LLMs)、图像生成和音频生产,无需依赖云服务。这使其特别适合注重隐私和数据控制的用户,因为所有处理都在本地完成,确保数据不离开用户设备。

功能与特性

LocalAI 提供丰富的功能,涵盖多种 AI 任务:

- OpenAI API 兼容性:作为 OpenAI API 的直接替代,兼容现有应用和库,方便无缝集成。

- 本地推理:用户可在本地运行 LLMs、生成图像和音频,适合消费级硬件,无需 GPU。

- 扩展性:

- LocalAGI:一个自主 AI 代理平台,无需编码即可构建和部署代理,通过 REST API 或 WebUI 交互

- LocalRecall:语义搜索和记忆管理系统,适合 AI 应用,提供持久的知识库管理

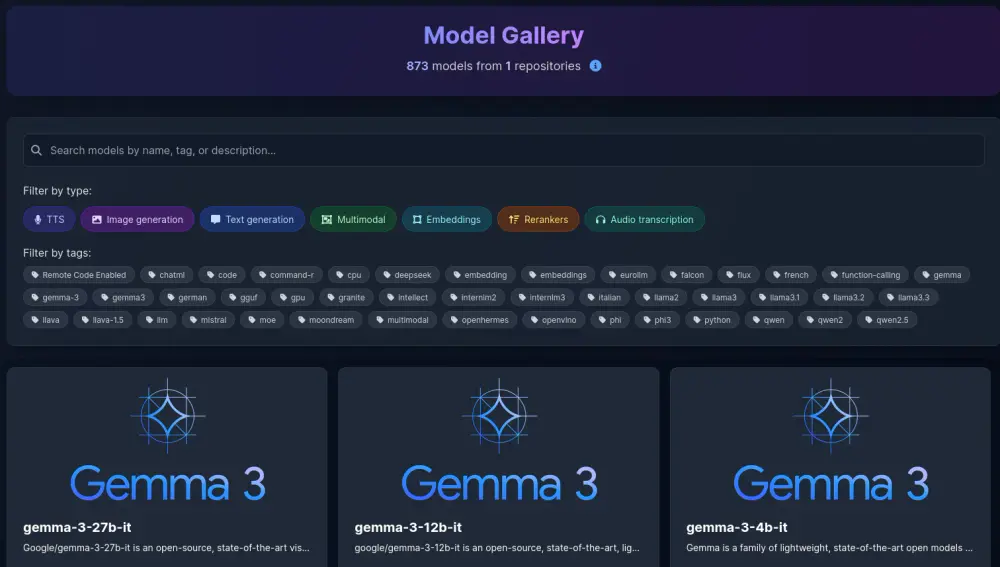

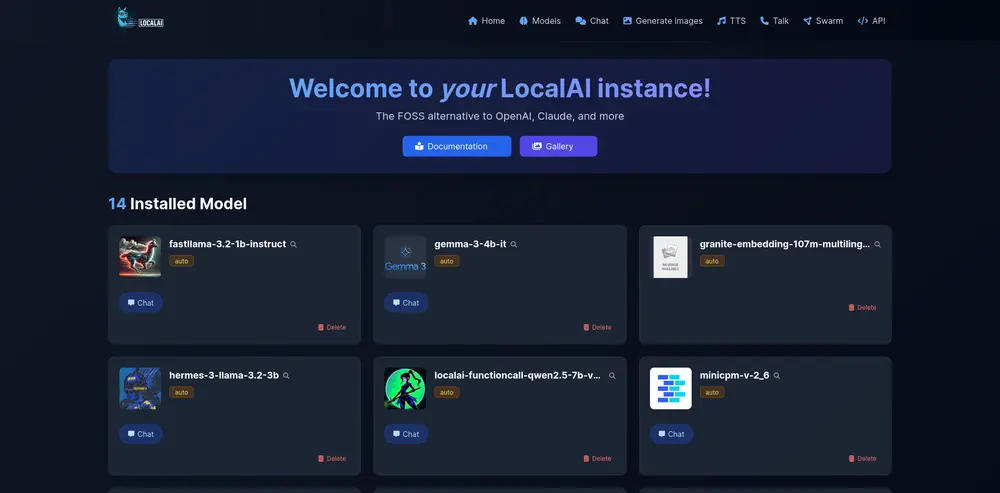

- 模型支持:支持多种模型,包括 LLMs、图像生成和音频模型,后端如 vLLM 和 llama.cpp 可通过 Web 界面或 CLI 切换。

- 隐私聚焦:数据完全本地处理,确保隐私和安全。

- 易于设置:提供二进制文件、Docker、Podman、Kubernetes 或本地安装选项,方便部署。

- 社区驱动:活跃的社区支持,定期更新,用户可参与开发。

- 可扩展性:用户可添加新模型和功能,增强功能。

- P2P 能力:支持基于 libp2p 的去中心化 LLM 推理,可在联邦模式下运行或分割模型权重,P2P Explorer。

- 能力范围:包括文本生成、图像创建、自主代理、语义搜索、图像理解、音频生成、语音活动检测、语音识别、视频生成和代理编排。

最新动态

LocalAI 的开发活跃,近期更新涵盖多个方面,反映其持续增强功能和用户体验:

- 2025 年 5 月:

- 添加音频输入支持,增强 llama.cpp 后端的 reranking 功能,引入实时 API。

- 支持新模型如 Gemma 和 SmollVLM,提升多模态能力。

- 图像名称变更,可能改善图像处理或命名方式。

- 2025 年 4 月:

- 品牌重塑和 WebUI 增强,改善用户界面。

- LocalAGI 和 LocalRecall 加入 LocalAI 家族栈,扩展生态系统。

- WebUI 大幅更新,AIO 镜像更新。