Hyperlink - 最新版

Hyperlink 设计为完全本地化,是一个本地个人AI智能体,利用您的个人数据帮助您回忆和创建信息,就在您的设备上。

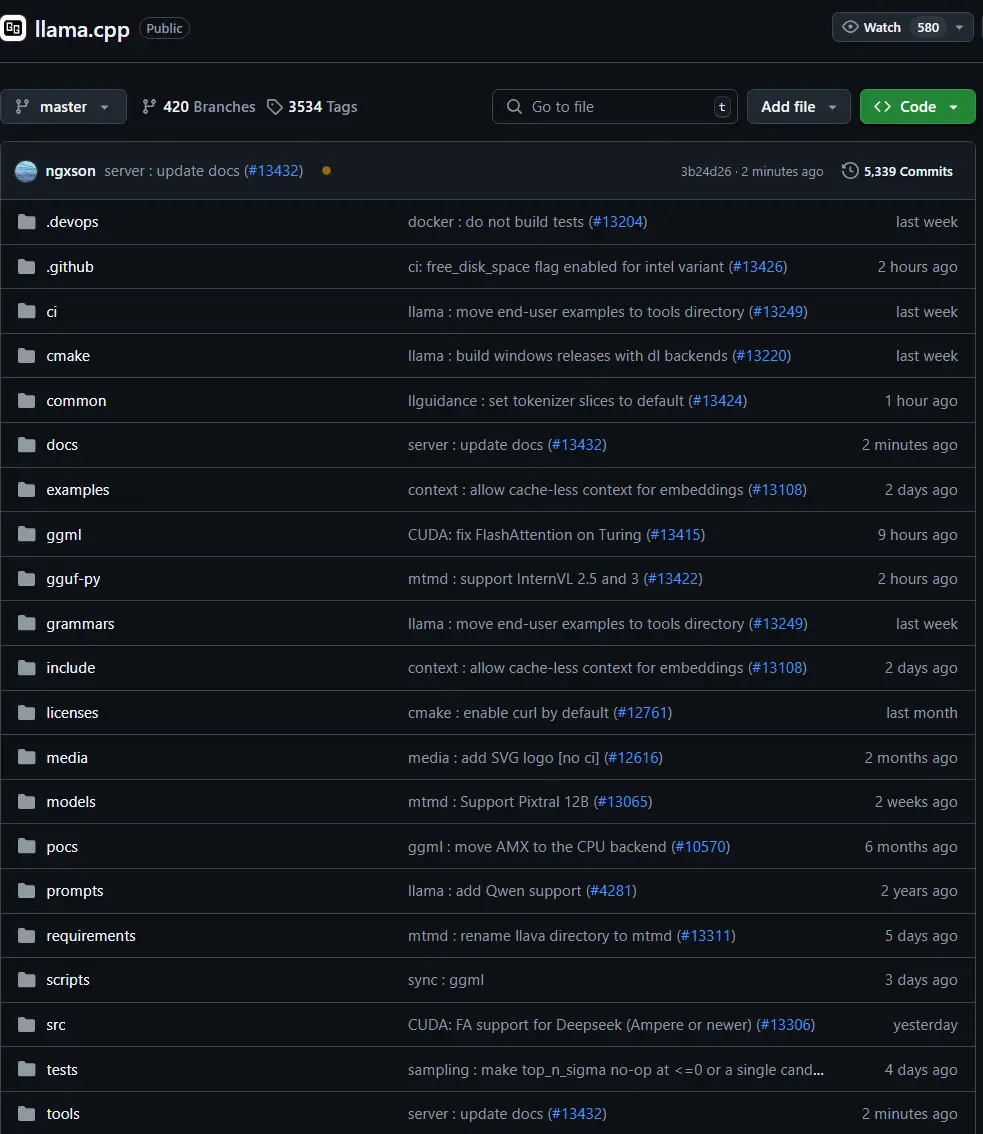

llama.cpp 是一个功能强大且高效的开源 AI 项目,专注于在各种硬件平台上实现大语言模型(LLM)的推理。其目标是通过纯 C/C++ 实现,提供最小的设置需求和最先进的性能,适用于本地和云端部署。该项目由 ggml-org 组织维护,社区贡献者众多,GitHub 仓库活跃,适合开发者构建 AI 应用程序或探索 LLM 的潜力。

llama.cpp 的主要目标是启用 LLM 推理,优化在广泛硬件上的性能,包括 Apple Silicon(通过 ARM NEON、Accelerate 和 Metal 框架)、x86(支持 AVX、AVX2、AVX512、AMX)、NVIDIA GPU(自定义 CUDA 内核)、AMD GPU(HIP)、Moore Threads MTT GPU(MUSA)、Vulkan、SYCL 以及 CPU+GPU 混合推理。它支持 1.5-bit 到 8-bit 的整数量化,进一步提升效率和性能。项目是 ggml 库(ggml)开发新功能的主要试验场,体现了其在 AI 社区中的重要性。

llama.cpp 提供了丰富的功能,满足开发者多样化的需求。以下是详细的特性总结:

| 类别 | 详情 |

|---|---|

| 模型支持 | 支持基础模型的微调,文本和多模态模型,新增模型指南见 HOWTO-add-model.md。 |

| 工具与绑定 | 包括 akx/ggify、akx/ollama-dl、crashr/gppm、gpustack/gguf-parser 等工具,以及 Unity 市场中的 Styled Lines 等 UI。 |

| 基础设施支持 | 涵盖 Paddler、GPUStack、llama_cpp_canister、llama-swap、Kalavai、llmaz 等项目。 |

| 后端支持 | 支持 Metal(Apple Silicon)、BLAS、BLIS、SYCL(Intel、NVIDIA GPU)、MUSA、CUDA、HIP、Vulkan、CANN(Ascend NPU)、OpenCL(Adreno GPU),详情见 build.md。 |

| 量化技术 | 支持 1.5-bit、2-bit、3-bit、4-bit、5-bit、6-bit、8-bit 整数量化,优化资源使用。 |

llama.cpp 提供了多种使用方式,方便开发者快速上手。以下是主要工具和使用场景:

llama-cli 支持对话模式(通过 -cnv 启用,指定模板通过 --chat-template),文本完成(通过 -no-cnv 禁用),自定义语法(通过 --grammar-file)。build/bin/llama-cli --completion-bash > ~/.llama-completion.bash 启用,可添加到 .bashrc 中。llama-server 默认运行在 8080 端口,支持多用户(通过 -np 4 和 -c 16384 配置),推测解码(通过 -md draft.gguf),嵌入(通过 --embedding 和 --pooling cls),重排序(通过 --reranking)以及语法约束。llama-perplexity -m model.gguf -f file.txt 用于测量模型的困惑度。llama-bench -m model.gguf 用于基准测试模型性能。llama-run granite-code。llama-simple -m model.gguf。convert_*.py 脚本转换。