LTX-2 作为当前最先进的视频生成模型,能生成高质量长视频,但其巨大的显存需求长期限制了在消费级硬件上的应用。

ComfyUI LTX-2 VRAM Memory Management这个ComfyUI 自定义节点 大幅降低了 VRAM 占用,使得在单张 24GB GPU(如 RTX 4090)上生成 800–900 帧、1920×1088 分辨率的视频成为现实。

该方案通过分块处理前馈网络(FFN),在不损失任何生成质量的前提下,将峰值显存使用量最高降低 8 倍,为个人创作者和小型工作室打开了长视频生成的大门。

核心成果:实测性能

在 RTX 4090(24GB)单卡环境下,使用 V3 版本(ffn_chunks=16):

| 分辨率 | 帧数 | VRAM 使用量 | 生成时间 |

|---|---|---|---|

| 1920×1088 | 800 | ~16.5 GB | ~15 分钟 |

| 1920×1088 | 900 | ~18.5 GB | ~27 分钟 |

注:结果因系统配置、驱动版本等略有差异,但整体趋势稳定。

这意味着,无需多卡、无需专业工作站,普通高端游戏 PC 即可运行 LTX-2 长视频生成任务。

技术原理:为何能省 8 倍显存?

LTX-2 的瓶颈在于其 96 层前馈网络(FFN)。每层会将隐藏维度从 4096 扩展至 16384,导致中间张量体积激增:

输入: (batch, 57000, 4096) → ~0.9 GB

中间: (batch, 57000, 16384) → ~3.7 GB ← 内存峰值!

输出: (batch, 57000, 4096) → ~0.9 GB

传统方式需一次性加载整个序列,极易触发 OOM(内存不足)。

解决方案:序列分块(Chunking)

将 57000 token 序列拆分为 8 或 16 个块,逐块处理 FFN:

块1: (batch, 7125, 4096) → (batch, 7125, 16384) → 输出

块2: (batch, 7125, 4096) → (batch, 7125, 16384) → 输出

...

最后拼接完整输出

→ 每层峰值显存从 3.7 GB 降至约 0.46 GB,总占用显著下降。

节点版本与适用场景

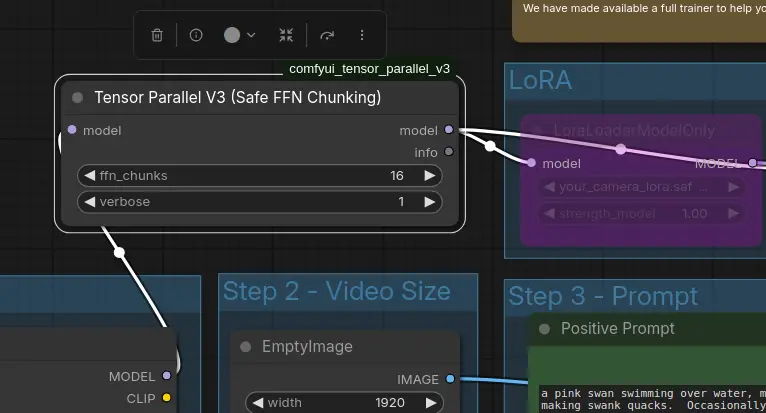

V3:单 GPU 推荐版(Tensor Parallel V3)

- 适用人群:绝大多数用户(单卡 16GB+)

- 特点:与 ComfyUI 内存管理兼容性好,稳定可靠

- 参数建议:

- 600 帧:

ffn_chunks=8 - 800 帧:

ffn_chunks=12–16 - 900+ 帧:

ffn_chunks=16–24

- 600 帧:

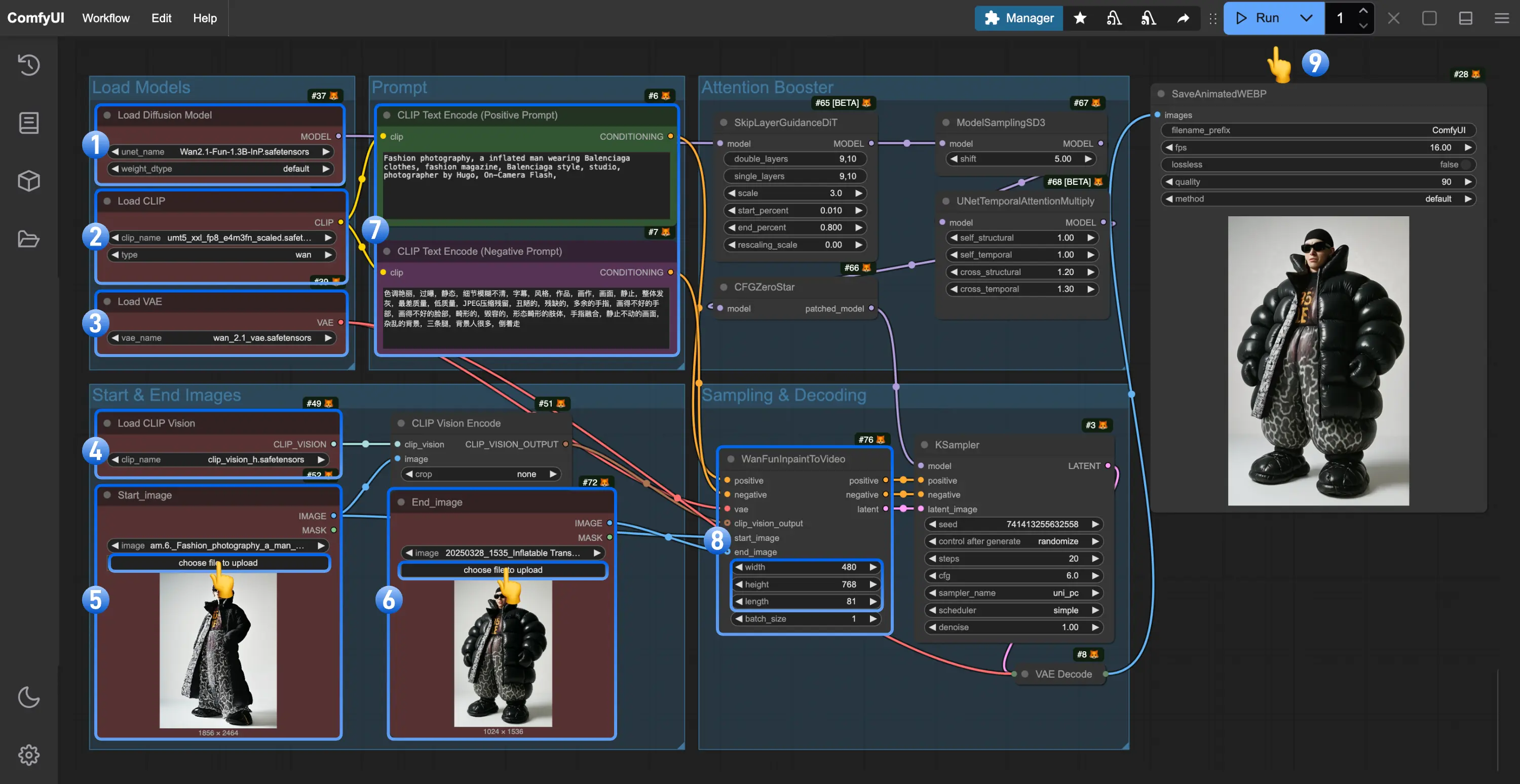

使用方式:

[加载模型] → [Tensor Parallel V3] → [其余工作流]

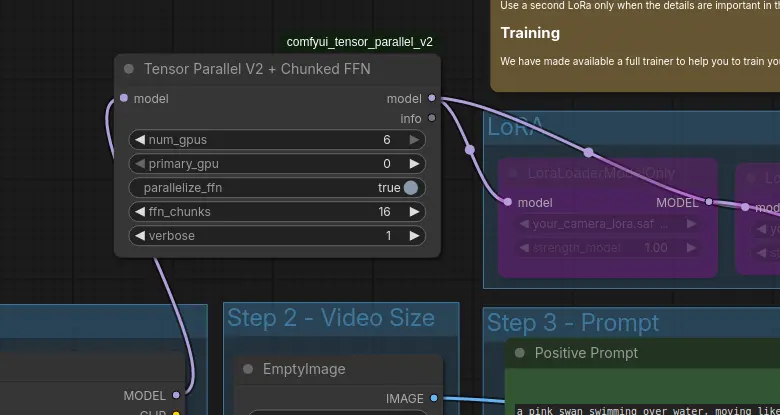

V2:多 GPU 实验版(Tensor Parallel V2 + Chunked FFN)

- 适用人群:拥有多张 GPU 且追求速度的用户

- 特点:将注意力计算分布到多卡,但 GPU 0 显存负载更高

- 注意:需手动调参,稳定性低于 V3

V5:多 GPU 高阶版(Tensor Parallel V5 + 环形注意力)

- 创新点:引入 环形注意力(Ring Attention),将超长序列(如 60 万+ token)分割到多张 GPU

- 原理:每张 GPU 仅持有 1/N 的 token,通过 K/V 分块轮转完成完整自注意力计算

- 实测:7 张 RTX 4090(6 张用于序列)可处理 614,400 token,单卡峰值 VRAM 仅 15–18 GB

- 适用场景:LTX-2 第二阶段上采样、音视频联合生成(LTXAV)

此版本专为极端长视频设计,普通用户无需使用。

安装与使用

- 克隆仓库:

git clone https://github.com/xxx/comfyui-ltx2-vram-opt.git - 将

comfyui_tensor_parallel_v2和comfyui_tensor_parallel_v3文件夹复制到 ComfyUI 的custom_nodes/目录 - 重启 ComfyUI

- 在工作流中插入对应节点(推荐从 V3 开始)

使用建议

- 优先使用 V3,稳定且高效

- 若遇 OOM 错误:

- 增加

ffn_chunks - 略微降低分辨率(如 1920→1600)

- 关闭其他占用 GPU 的程序(如浏览器、游戏)

- 增加

- 定期备份工作流,避免节点更新导致兼容问题

兼容性说明

- 测试环境:Ubuntu + ComfyUI 官方版 + RTX 4090(24GB)

- 支持模型:LTX-2 / LTXAV

- 其他系统(如 Windows)可能可用,但未充分验证

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...