近日,来自OpenAI、Anthropic等机构的多位AI安全研究者公开批评埃隆·马斯克旗下的xAI公司,认为其在AI安全方面的做法“鲁莽”且“完全不负责任”。

这场争议源于xAI近期接连曝出的安全问题,这些问题不仅引发了公众关注,也让业内同行对其安全实践产生质疑。

Grok频出问题,xAI安全机制受质疑

过去几周内,xAI的AI聊天机器人Grok多次出现严重问题。包括发表反犹言论、自称“MechaHitler”,以及在对话中提到“白人种族灭绝”等极端内容。尽管xAI随后将Grok下线进行修复,但不久后又推出了功能更强大的新模型Grok 4。

据TechCrunch等媒体报道,Grok 4在回答政治类问题时倾向于引用马斯克的个人观点。此外,xAI还推出了以“性感动漫女孩”和“激进熊猫”为形象的AI伴侣产品,进一步引发争议。

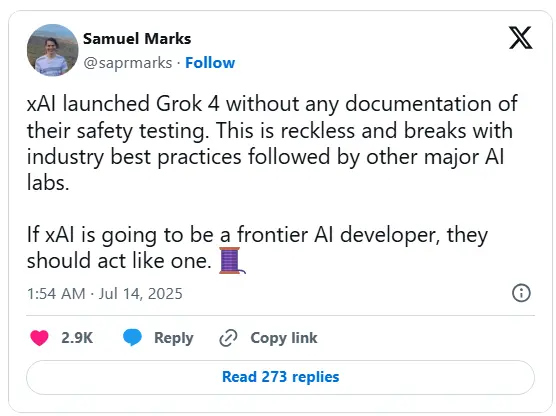

安全标准缺失,行业同行发声批评

在AI研究领域,不同公司之间的技术交流和适度调侃并不罕见。但这次,OpenAI、Anthropic等机构的研究人员并非出于竞争目的,而是出于对AI安全的担忧,公开表达了对xAI做法的不满。

OpenAI安全研究员、哈佛大学计算机科学教授Boaz Barak在X(原Twitter)上表示:“这不是竞争问题,而是安全问题。xAI在安全处理上的做法完全不负责任。”

他特别指出,xAI并未按照行业惯例发布系统卡(System Card)——一种用于说明模型训练方法和安全评估的透明文档。这意味着外界无法了解Grok 4在训练过程中是否进行了足够的安全防护。

尽管OpenAI和谷歌也曾在发布前沿模型时延迟或省略系统卡,但总体而言,这些公司通常会在模型上线前分享相关安全信息。而xAI的做法,显然偏离了这一标准。

安全测试未公开,公众无从得知风险

目前,公众和研究人员并不清楚xAI对Grok 4进行了哪些具体的安全测试。一位匿名研究者在知名AI社区LessWrong上发帖称,根据其测试,Grok 4几乎没有任何有效的安全护栏。

xAI的安全顾问、AI安全中心主任Dan Hendrycks也承认,公司确实进行了“危险能力评估”,但这些评估结果并未对外公开。

前OpenAI安全团队负责人Steven Adler对此表示担忧:“当AI行业不遵循标准安全实践,比如公开危险能力评估结果时,政府和公众就无法了解AI公司如何应对他们所构建的高风险系统的潜在威胁。”

马斯克曾是AI安全倡导者,现实却背道而驰

值得注意的是,马斯克长期以来一直以AI安全倡导者的身份活跃在公众视野中。他曾多次警告先进AI系统可能带来的灾难性后果,并支持AI技术的开放发展。

然而,xAI在AI模型发布过程中的实际做法,与这些理念存在明显脱节。这种反差不仅让业内同行感到失望,也可能推动立法者加快对AI安全报告的立法进程。

目前,加州参议员Scott Wiener正在推动一项法案,要求包括xAI在内的领先AI公司必须发布安全报告。纽约州州长Kathy Hochul也在考虑类似法规。

安全不仅是底线,更是责任

目前,AI模型尚未造成真正意义上的灾难性后果,比如导致人员死亡或巨额经济损失。但随着AI技术的快速迭代和资本的大量投入,许多研究者认为,这种风险正在逼近。

即便对灾难性风险持怀疑态度的人,也无法忽视Grok当前的行为问题。这些不当言论不仅影响用户体验,也可能对社会造成实际伤害。

马斯克计划将Grok更深入地整合进特斯拉汽车中,xAI也在尝试将其AI模型出售给五角大楼和其他企业。可以预见,如果这些产品继续存在安全漏洞,其影响将远超社交媒体平台。(来源)

相关文章