谷歌近期正在持续推进其名为 Sparkify 的 AI 视频生成实验项目。该项目首次亮相于今年的 Google I/O 大会,目前仍处于邀请制测试阶段,仅通过等待名单向部分用户开放。

Sparkify 并非早期 AI 内容实验(如 Illuminate)的简单延续,而是一个定位清晰、功能独立的新工具。它利用谷歌最新的AI模型,快速生成高质量的教育和娱乐类短视频,探索 AI 在社交媒体内容创作中的潜力。

Sparkify 的界面与核心功能

Sparkify 的界面分为三个主要板块:

- 探索(Explore):展示由 AI 生成的主题短视频,时长通常为两分钟左右,涵盖诸如“饮料起源”、“奇特景点导览”等内容。

- 生成(Create):用户可以输入主题、选择视觉风格和情绪,生成定制化的视频。

- 我的库(My Library):保存用户创建或收藏的视频片段。

这些视频采用横屏或竖屏格式,风格多样,包括卡通、折纸、黏土动画、3D 卡通、动漫以及实景拍摄模拟等。它们通常配有背景音乐与旁白,讲述一个简短但完整的故事或解释一个知识点。

值得注意的是,某些视频中角色形象在不同内容中反复出现,这表明 Sparkify 可能使用了某种基于模板或提示的角色持久化机制。

Gemini + Veo:AI 视频背后的双引擎

Sparkify 的核心技术依赖于谷歌两大 AI 模型:

- Gemini:作为多模态大模型,Gemini 很可能负责内容策划、叙事结构设计或视频片段的组合编排。

- Veo:作为视频生成模型,Veo 负责将文本描述转化为具体的视觉内容,是视频输出的核心驱动引擎。

在“生成”页面中,用户可以选择:

- 主题(如“宇宙探索”或“咖啡文化”)

- 视觉风格(毛毡、黏土、折纸、3D 卡通、动漫、现实等)

- 情绪氛围(愉悦、学术、幽默等)

不过,当前版本的 Sparkify 尚未实现完全的交互响应,生成的视频仍然是预设演示内容,无法根据用户输入动态调整,这意味着其提示理解能力和模型限制仍有待验证。

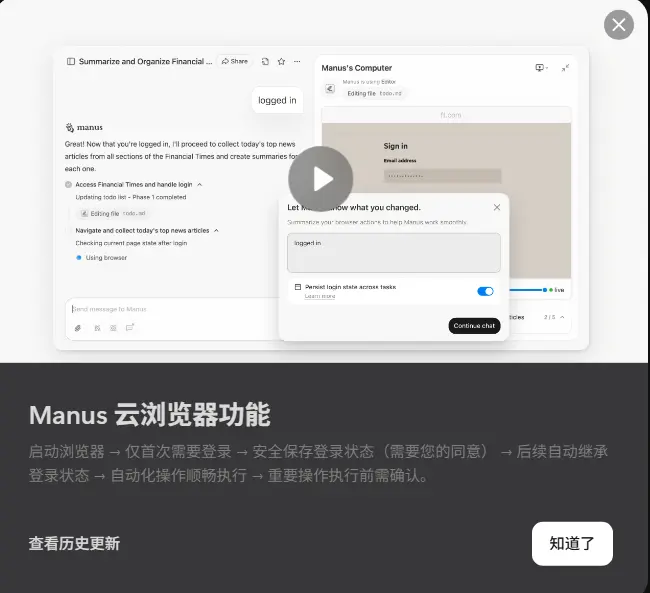

Sparkify 的潜在工作方式

从目前输出的视频来看,有推测认为 Sparkify 可能采用了“分段生成 + 后期拼接”的策略。即先由 Veo 生成多个短视频片段,再由 Gemini 进行内容整合与节奏控制,以突破当前 AI 视频模型在单次生成长度上的限制。

这种机制不仅有助于提升视频的连贯性和观赏性,也为创作者打造品牌化角色或系列内容提供了可能——例如在 TikTok 或 Instagram Reels 上建立具有统一风格的 AI 内容频道。

当前状态与未来展望

截至目前,Sparkify 仍是一个仅限受邀用户的实验性项目,尚未公布正式发布时间表。虽然功能尚未完全成熟,但它已经展示了谷歌在 AI 媒体创作领域的长期布局。

TestingCatalog 等机构也在持续监测 Sparkify 生成视频在 TikTok 等平台上的表现效果,而谷歌方面也表示将持续优化用户体验,为未来的公开发布做准备。

相关文章