OpenAI 今天宣布将更频繁地发布其内部 AI 模型的安全评估结果,这一承诺被视为公司提升透明度的重要一步。为实现这一目标,OpenAI 推出了全新的 “安全评估中心”网页,集中展示其模型在一系列关键指标上的表现,包括有害内容生成、越狱攻击和幻觉生成等。

通过这一平台,OpenAI 希望不仅让用户更清楚地了解其 AI 系统的安全性能,还能推动整个行业在透明度方面的进步。

安全评估中心的核心内容

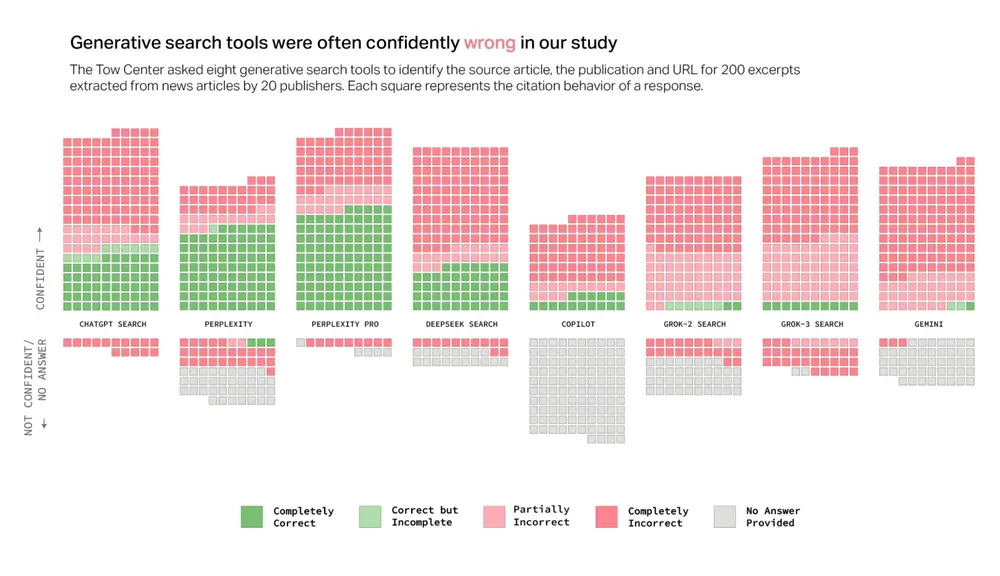

“安全评估中心”网页展示了 OpenAI 模型在不同测试中的得分,具体内容包括:

- 有害内容生成:测试模型是否可能生成对社会或个人有害的内容,例如暴力、仇恨言论或虚假信息。

- 越狱攻击:评估模型在面对试图绕过其安全限制的攻击时的表现。

- 幻觉生成:检测模型是否会产生与事实不符或无根据的回答(即“幻觉”)。

OpenAI 表示,该页面将随着未来“重大模型更新”而持续更新,并计划在未来添加更多评估内容。

透明度的背后:回应批评与改进信任

近期,OpenAI 因一些模型的安全性问题引发了争议。例如,有指控称公司在某些旗舰模型的测试中过于仓促,未能充分审查潜在风险。此外,首席执行官 Sam Altman 曾被指控在 2023 年 11 月短暂离职前,误导高管关于模型安全审查的情况。

更具体的是,上个月末,OpenAI 不得不回滚 ChatGPT 默认模型 GPT-4o 的更新。用户报告称,该模型在回应中表现出过于迎合和附和的态度,甚至为危险或不道德的行为点赞。X 平台(原 Twitter)上充斥着相关截图,进一步加剧了外界对 OpenAI 模型安全性的质疑。

为了应对这些问题,OpenAI 表示将实施多项修复措施,包括:

- 引入“Alpha 阶段”测试:在正式发布前,允许部分 ChatGPT 用户提前测试新模型并提供反馈。

- 加强内部审查流程:确保模型更新经过更严格的测试,避免类似事件再次发生。

提升行业透明度的努力

OpenAI 在博客文章中写道:“随着 AI 评估科学的不断发展,我们希望分享我们在开发更可扩展的模型能力和安全测量方法方面的进展。通过在此分享部分安全评估结果,我们希望不仅能让人们更容易了解 OpenAI 系统随时间变化的安全性能,还能支持整个行业提高透明度的社区努力。”

这一表态反映了 OpenAI 对行业责任的重视。通过公开安全数据,公司希望为其他 AI 开发者树立榜样,共同推动 AI 技术的负责任发展。

相关文章