OpenAI的o3 模型在基准测试中的表现引发了广泛关注和讨论。该公司最初声称的高分与实际测试结果之间的差异,引发了人们对公司透明度和模型测试实践的质疑。

OpenAI的初步声明与实际表现的差异

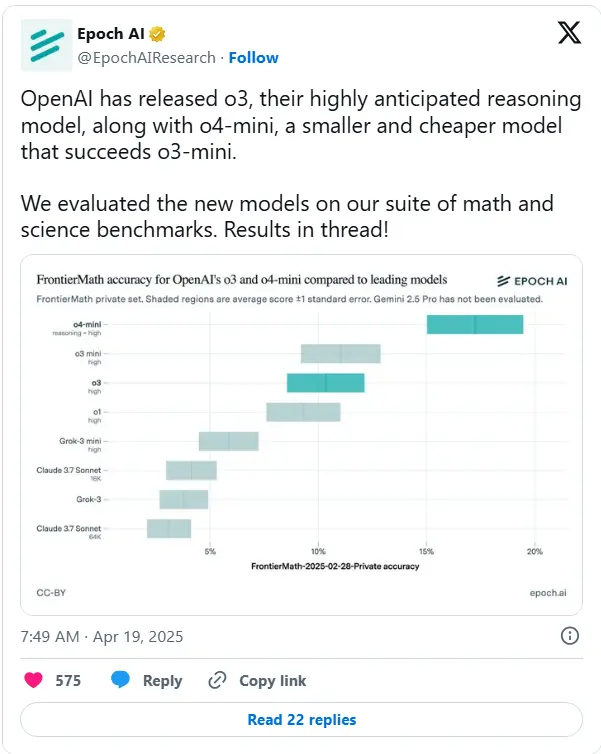

当OpenAI在12月发布o3模型时,公司声称该模型在FrontierMath(一组具有挑战性的数学问题)中能够正确回答超过25%的问题。这一成绩远超竞争对手,排名第二的模型只能正确回答约2%的问题。OpenAI首席研究官Mark Chen在直播中表示:“目前市场上所有产品在FrontierMath上的得分都低于2%。我们在内部看到,使用o3在高强度的测试时计算设置下,能够达到超过25%的得分。”

然而,随后的研究机构Epoch AI在独立基准测试中发现,o3的实际得分约为10%,远低于OpenAI最初宣称的25%。这一发现引发了对OpenAI测试方法和透明度的质疑。

测试差异的可能原因

尽管测试结果低于预期,但这并不意味着OpenAI完全误导了公众。公司在12月发布的基准测试结果展示了一个下限得分,与Epoch观察到的得分相符。Epoch指出,其测试设置可能与OpenAI的有所不同,并且其评估使用了更新的FrontierMath版本。

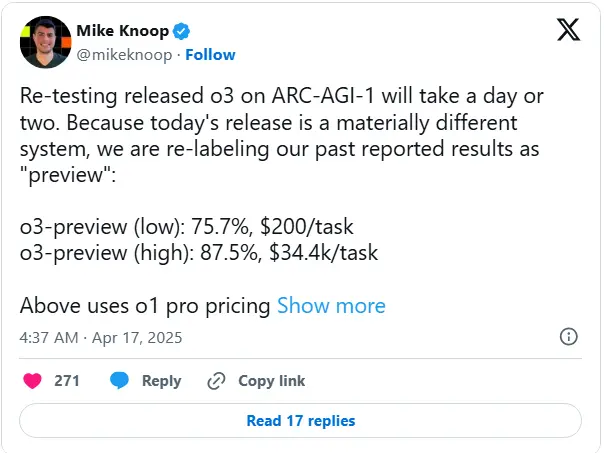

Epoch在报告中指出:“我们结果与OpenAI的差异可能源于OpenAI使用了更强大的内部框架、更多的测试时计算,或者因为这些结果是在FrontierMath的不同子集上运行的。”此外,ARC奖基金会(一个测试了o3预发布版本的组织)也确认,公开的o3模型“是一个不同的模型……针对聊天/产品用途进行了调整”,这进一步解释了测试结果的差异。

OpenAI的回应与优化

OpenAI的技术人员Wenda Zhou在上周的直播中表示,生产中的o3“更针对现实世界的用例”进行了优化,并且速度更快,与12月展示的o3版本相比。因此,他补充说,可能会出现基准测试的“差异”。

Zhou解释道:“[我们]进行了[优化],使[模型]更具成本效益,总体上更有用。我们仍然希望——我们仍然认为——这是一个更好的模型……当你提问时,不需要等待太久,这对这类[模型]来说是个现实问题。”

行业背景与启示

尽管o3的公开版本未达到OpenAI最初承诺的水平,但值得注意的是,公司的其他模型(如o3-mini-high和o4-mini)在FrontierMath上的表现超过了o3。此外,OpenAI计划在未来几周推出更强大的o3变体o3-pro。

然而,这一事件再次提醒人们,AI基准测试的结果不应仅看表面价值,尤其是当来源是需要销售服务的公司时。随着供应商竞相通过新模型抢占头条和市场关注度,AI行业的基准测试“争议”正变得越来越常见。

今年1月,Epoch因在OpenAI宣布o3后才披露其资助来源而受到批评。许多为FrontierMath做出贡献的学者直到公开披露才得知OpenAI的参与。最近,埃隆·马斯克的xAI被指控为其最新AI模型Grok 3发布了误导性的基准测试图表。本月,Meta承认其宣传的基准测试分数来自一个与公司提供给开发者的版本不同的模型。(来源)

相关文章