Continuous Claude

Continuous Claude是一个基于 Claude Code 构建的持久、学习型多智能体开发环境,将 Claude Code 转变为一个持续学习的系统,能在会话间保持上下文,编排专业化的智能体,并通过智能代码分析避免令牌浪费。

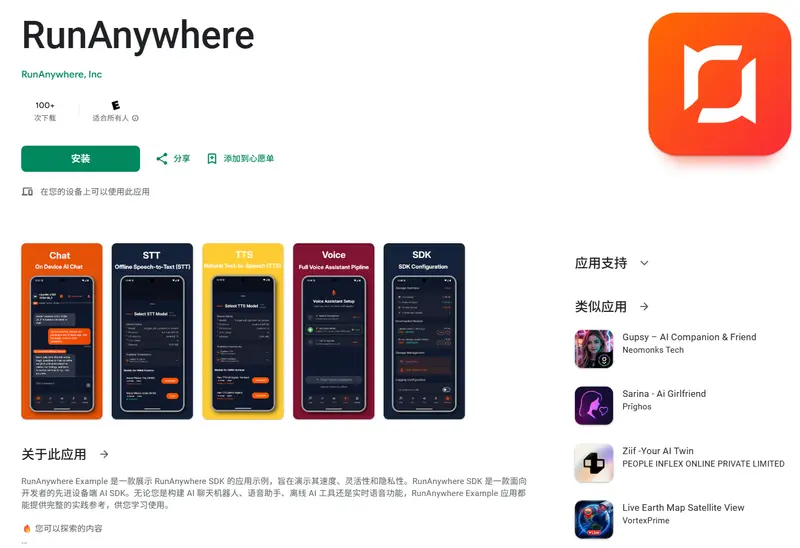

RunAnywhere 是一套面向移动开发者的设备端 AI SDK,支持在 iOS 和 Android 上本地运行大语言模型(LLM)、语音识别(STT)和语音合成(TTS)——全程无需联网、不依赖云端、数据不出设备。

RunAnywhere 是一套面向移动开发者的设备端 AI SDK,支持在 iOS 和 Android 上本地运行大语言模型(LLM)、语音识别(STT)和语音合成(TTS)——全程无需联网、不依赖云端、数据不出设备。

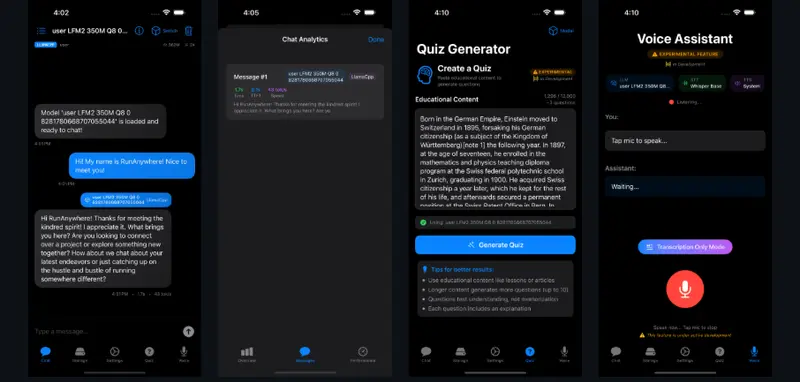

无论是构建离线聊天机器人、语音助手,还是需要隐私保护的智能功能,RunAnywhere 都能提供低延迟、高安全、零 API 成本的解决方案。

关键优势:无网络请求、无 API 密钥、无数据上传。一旦模型下载完成,即使在飞行模式下也能正常工作。

| 平台 | 状态 | 集成方式 | 文档 |

|---|---|---|---|

| Swift(iOS / macOS) | 稳定 | Swift Package Manager | docs.runanywhere.ai/swift |

| Kotlin(Android) | 稳定 | Gradle | docs.runanywhere.ai/kotlin |

| Flutter | 测试版 | pub.dev | docs.runanywhere.ai/flutter |

| React Native | 测试版 | npm | docs.runanywhere.ai/react-native |

所有 SDK 均采用模块化设计:你只需引入所需功能(如仅用 LLM 或仅用 STT),避免应用体积膨胀。

官方提供了一个完整的示例应用(RunAnywhere Example),用于演示 SDK 的实际集成效果,包含:

对于注重用户体验、数据合规或离线场景的应用(如医疗、教育、工业、个人工具),设备端 AI 正成为越来越重要的技术选项。