Claude Code 是一个强大的 AI 编程助手,但它有一个长期存在的问题:上下文压缩。当对话历史接近模型上下文上限时,系统会自动“压缩”旧内容,导致早期讨论中的关键决策、设计思路或调试细节被丢弃。这不仅打断开发节奏,还可能让 AI 在后续交互中重复犯错或误解需求。

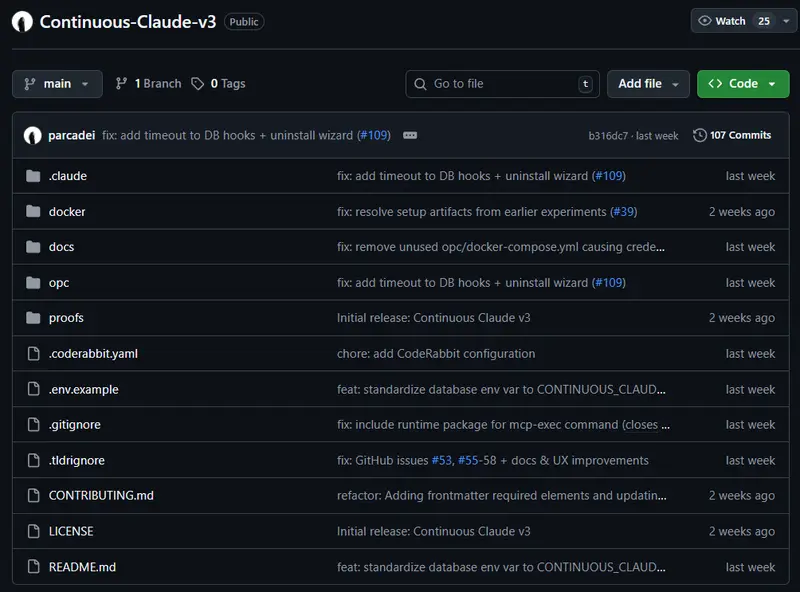

为了解决这个问题,社区开发者推出了 Continuous Claude(CC-v3) —— 一个基于 Claude Code 构建的持久化、可学习、多智能体协同的开发环境。

它的目标很明确:不让 AI 忘记你做过什么,也不让它重复浪费 token。

核心问题与解决方案

| 问题 | Continuous Claude 的应对方式 |

|---|---|

| 上下文压缩导致信息丢失 | 使用 YAML 格式的“交接文件”(handoff),高效传递关键状态,避免冗余 token 消耗 |

| 每次会话从零开始 | 内置记忆系统 + 后台守护进程,自动提取并存储会话中的学习成果 |

| 读取整个源文件成本高 | 引入 TLDR 五层代码分析引擎,仅用约 1,200 token 即可替代 23,000 token 的原始文件读取(节省 95%) |

| 复杂任务需多人协作式处理 | 通过 元技能(meta-skills) 编排多个专业化智能体(如 debug-agent、scout、kraken)协同工作 |

| 用户需手动重复操作流程 | 提供 109 项自然语言触发的技能,无需记忆命令,说清楚意图即可 |

其核心理念是:Compound, don’t compact(复合,而非压缩)。

不是把旧内容删掉腾空间,而是把有价值的信息提炼出来,作为新会话的起点。

名字的双关含义

- Continuous(连续):系统能在多个会话之间保持状态连贯性,不会“失忆”。

- Compounding(复利式增长):每次交互产生的洞察、修复方案或架构决策都会被自动归档,形成可复用的知识资产,像复利一样持续增值。

系统如何运作?

Continuous Claude 将每个智能体定义为五个要素的组合:

Prompt(提示) + Tools(工具) + Context(上下文) + Memory(记忆) + Model(模型)

其中,前四项是可工程化、可优化的部分。一旦它们稳定,底层大模型甚至可以替换——这意味着系统不依赖单一 AI 提供商。

设计原则:克制与效率

项目明确反对“插件泛滥”。每增加一个外部工具(如 MCP、API 订阅),都可能引入上下文冲突或提示污染。因此,CC-v3 坚持三条原则:

- 时间优先于金钱:默认不依赖任何付费服务。Perplexity 或 NIA 等高级工具仅为可选增强项。

- 学习优于堆砌:与其集成几十个插件,不如让系统从每次交互中真正学到东西。

- 左移验证(Shift-left validation):在代码编辑后立即运行

pyright或ruff,在测试前就捕获类型错误或风格问题。

你不需要记命令,只需说清楚意图

Continuous Claude 内置 技能激活系统。当你输入自然语言请求时,系统会自动判断应调用哪些技能或智能体。

例如,你说:

“修复 auth.py 中的登录错误”

系统会立即提示:

🎯 技能激活检查

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

⚠️ 关键技能(必需):

→ create_handoff

📚 推荐技能:

→ fix

→ debug

🤖 推荐智能体(令牌高效):

→ debug-agent

→ scout

操作: 在响应前使用技能工具

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

这种机制既降低了新手门槛,又保留了高级用户的控制力——你仍可直接输入 /fix、/build 等命令。

常见自然语言映射示例

| 用户输入 | 自动激活的工作流 |

|---|---|

| “修复损坏的登录” | /fix → debug-agent + scout |

| “构建用户仪表板” | /build greenfield → plan-agent + kraken |

| “理解这个代码库” | /explore deep --focus "auth" |

| “今天到此为止” | 自动触发 create_handoff(关键!) |

| “从上次中断处继续” | resume_handoff 加载完整上下文 |

技术组件解析

1. TLDR 代码分析引擎(95% token 节省)

不再让 AI 读整份文件。TLDR 通过五层静态分析生成紧凑摘要:

- L1 AST:函数、类、签名(~500 token)

- L2 Call Graph:跨文件调用关系(+440)

- L3 CFG:控制流图(+110)

- L4 DFG:数据流追踪(+130)

- L5 PDG:程序切片与影响分析(+150)

总计约 1,200 token,却能支撑精准的语义搜索、影响分析和上下文注入。

2. 记忆系统(PostgreSQL + pgvector)

会话结束后,后台守护进程会:

- 检测“心跳”超时(>5 分钟无活动)

- 启动无头 Claude 实例

- 从“思考块”(thinking blocks)中提取决策逻辑

- 存入

archival_memory表(带 BGE 向量嵌入)

下次会话中,相关记忆会通过 memory-awareness 钩子自动浮现,无需手动查询。

3. 智能体与工作流

- 32 个专业化智能体:如

sleuth(调试)、scout(探索)、kraken(TDD 实现) - 8 类元技能工作流:

/fix:诊断 → 风险评估 → 修复 → 测试 → 提交/build:需求澄清 → 设计 → 验证 → 实现/refactor:影响分析 → 安全重构/tdd、/review、/security、/release等

所有流程支持跳过阶段(如 --skip-discovery)、并行执行或输出文档。

快速上手

前提条件

- Python 3.11+

uv包管理器- Docker(用于本地 PostgreSQL)

- 已安装 Claude Code CLI

安装步骤

git clone https://github.com/parcadei/Continuous-Claude-v3.git

cd Continuous-Claude-v3/opc

uv run python -m scripts.setup.wizard # 12 步交互式配置

向导将自动完成:

- 环境检查

- 数据库初始化(本地 Docker 或远程 PostgreSQL)

- 安装 32 智能体 + 109 技能 + 30 钩子

- 可选数学库(SymPy/Z3)与诊断工具

注意:所有

uv命令需在opc/目录下执行,因pyproject.toml位于此处。

远程数据库支持

若使用 AWS RDS、Supabase 或 Azure,只需:

- 启用

pgvector扩展 - 导入

docker/init-schema.sql - 在

~/.claude/settings.json中配置连接 URL

数据统计

相关导航

JetBrains Kineto

新rtk

新PM Skills Marketplace

Wabi

Amazon Q Developer

Mocha

Skill From Masters