ALLWEONE® AI Presentation Generator

ALLWEONE 不仅是一个 Gamma 的开源替代方案,更是一个可部署、可扩展、支持本地 AI 的完整演示文稿平台。对于开发者、教育者或注重数据隐私的用户而言,它提供了更高的灵活性与控制权。

RamTorch 不是一个替代完整分布式框架的重型方案,而是一个精准解决“显存不够”问题的小而美工具。它降低了大模型实验门槛,使更多研究者和工程师能在有限硬件条件下开展工作。如果你正被显存不足困扰,又不想立刻投入多卡集群成本,RamTorch 值得一试。

在深度学习训练与推理中,GPU 显存不足是许多开发者面临的核心痛点。当模型参数规模超过单卡容量时,往往需要昂贵的多卡部署或复杂的模型切分策略。

现在,一个名为 RamTorch 的新工具提供了一种更轻量、高效的解决方案:

让 CPU 内存成为你的“扩展显存”。

RamTorch 是一个基于 PyTorch 的开源库,通过 CPU-GPU 混合执行架构,实现对超出 GPU 显存限制的大模型进行训练与推理。它允许将模型参数保留在 CPU 内存中,并在前向传播时按需异步加载到 GPU,从而显著降低显存占用,同时维持较高的计算效率。

RamTorch 的设计哲学很简单:

如果模型太大装不下 GPU,那就不要全放进去 —— 只在需要时把权重“搬”过来。

这一思路借鉴了操作系统中的虚拟内存机制,在不牺牲太多性能的前提下,突破硬件显存限制。尤其适用于以下场景:

share_memory_() 支持多进程访问。nn.Linear 层。import ramtorch.nn as rnn

# 替换原生线性层

# self.fc = nn.Linear(768, 3072)

self.fc = rnn.Linear(768, 3072) # 自动启用 CPU 存储 + 异步加载

export MAX_INFLIGHT=4 # 默认为 2

该参数调节“飞行中”的传输数量,平衡吞吐与资源压力。

pip install ramtorch

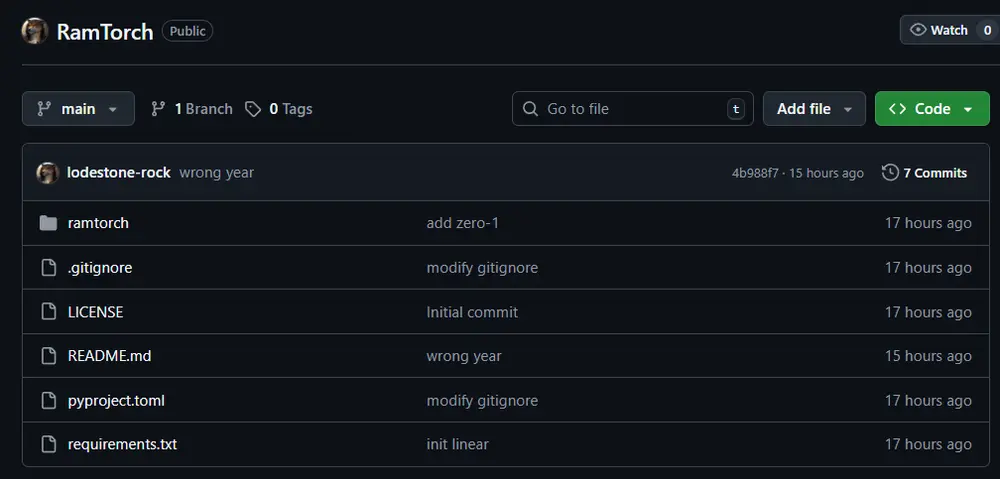

git clone https://github.com/lodestone-rock/RamTorch.git

cd RamTorch

pip install -e .

项目托管于 GitHub,持续更新中,欢迎贡献与反馈。

RamTorch 的核心组件是 CPU 弹跳线性层(CPU-Bounced Linear Layer),其执行流程如下:

weight 和 bias 保存在 CPU 内存中;.forward(x) 时,启动异步传输任务;整个过程对用户透明,无需手动管理设备迁移。

| 场景 | 说明 |

|---|---|

| 大模型训练 | 模型无法完整放入 GPU 显存(如 LLM 微调) |

| 内存受限推理 | 在消费级显卡上运行 7B/13B 级别模型 |

| 低成本科研实验 | 实验室仅有少量 GPU,但 CPU 内存充足 |

| 分布式轻量训练 | 结合 ZeRO-1 实现跨 GPU 优化器状态分片 |

| 场景 | 原因 |

|---|---|

| 小模型(<3B)且显存充足 | 引入额外传输开销,得不偿失 |

| 极低延迟要求的应用 | 如实时语音交互,数据搬运可能引入抖动 |

| CPU-GPU 带宽瓶颈系统 | PCIe 通道少或使用老旧主板时性能下降明显 |

为了最大化 RamTorch 的效率,请参考以下实践建议:

MAX_INFLIGHT 参数torch.cuda.amp 减少激活值显存占用,与 RamTorch 形成互补。Linear 层)。RamTorch 当前聚焦于线性层的内存优化,后续计划包括:

作为一个轻量级、易集成的工具,RamTorch 为资源受限环境下的深度学习提供了新的可能性。