DecartAI正式发布了MirageLSD——全球首个直播扩散(Live Streaming Diffusion)视频模型,实现了实时、无限、零延迟的视频生成能力。这项技术不仅突破了当前AI视频生成的瓶颈,也为未来的视频交互体验打开了新的可能性。

什么是MirageLSD?

MirageLSD是DecartAI继Oasis之后推出的第二代核心模型。它基于一种全新的“直播扩散”机制,能够在每帧仅需40毫秒的响应时间内,生成无限长度的高质量视频流。

与传统视频生成模型不同,MirageLSD不依赖于预设的视频片段,也不需要离线处理。它采用因果自回归结构,逐帧生成视频,并在生成过程中持续接收用户输入,从而实现真正的实时交互。

为什么说MirageLSD是突破?

1. 实时性:真正“零延迟”的视频生成

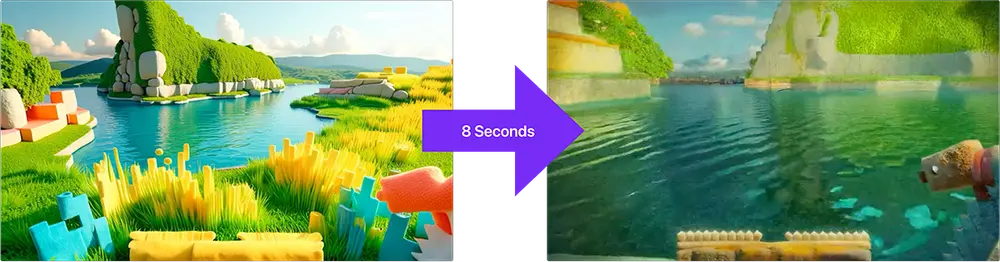

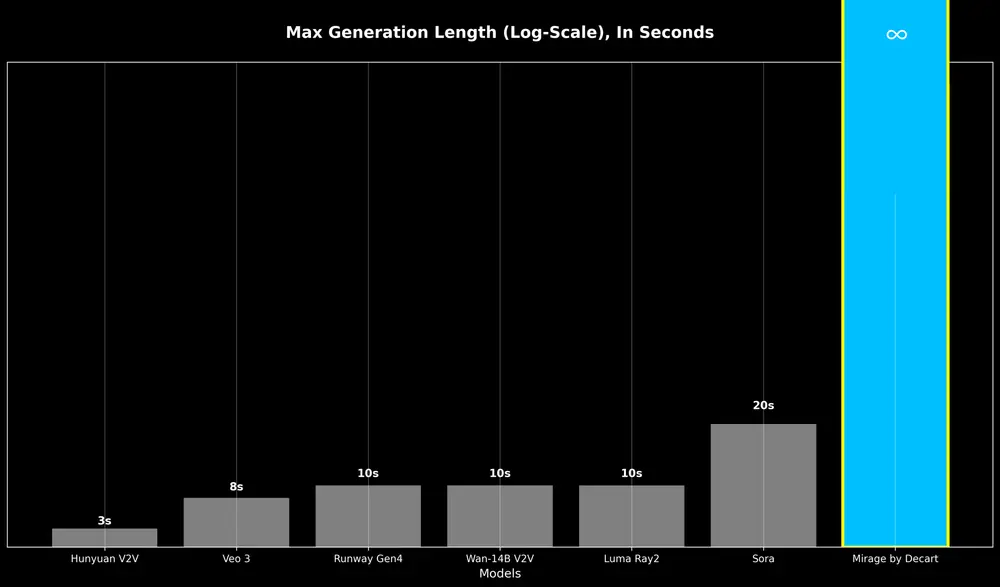

目前主流的视频生成模型存在明显延迟,通常需要数秒甚至数十秒才能生成几秒钟的视频内容。而MirageLSD的响应时间控制在40毫秒以内,这意味着它可以在24帧/秒的速率下实时生成视频,几乎与用户的输入同步。

2. 无限生成:不再受限于视频长度

以往的AI视频模型在生成几十秒后会出现明显的质量下降,甚至完全崩溃。MirageLSD通过引入扩散强制(Diffusion Forcing)和历史增强训练,有效缓解了“错误累积”问题,使得视频生成过程稳定且可持续,理论上可以无限运行。

3. 可交互性:边生成边控制

MirageLSD支持在生成过程中动态修改提示(prompt),甚至可以对当前帧进行局部编辑。这种交互能力为实时视频创作、直播特效、游戏互动等场景提供了前所未有的可能性。

技术实现:如何做到“实时无限生成”?

核心机制:因果自回归 + 扩散强制

MirageLSD采用因果自回归结构,即每一帧的生成仅基于之前的帧和当前输入。为了防止错误累积,团队引入了扩散强制技术,让模型在训练中学会逐帧去噪,而不是一次性生成整个视频。

系统优化:GPU级加速 + 快捷蒸馏

为了实现毫秒级响应,团队进行了多项底层优化:

- Hopper优化的超级内核(CUDA Super Kernel):减少模型推理的计算开销。

- 架构感知剪枝:根据GPU硬件特性优化模型结构,减少运算量。

- 快捷蒸馏(Shortcut Distillation):训练轻量模型快速复现高质量输出,大幅缩短生成步骤。

这些技术共同作用,使得MirageLSD的响应速度比现有模型提升了16倍。

应用场景:不只是视频生成

MirageLSD的强大能力不仅限于生成视频片段,它正在重新定义多个领域的交互方式:

- 直播与视频通话:实时添加特效、背景替换、风格转换。

- 游戏与虚拟现实:动态生成场景、角色、动作,提升沉浸感。

- 影视后期与创意工具:提供实时编辑、风格迁移、AI辅助剪辑等能力。

- 远程协作与虚拟会议:智能美化、环境替换、实时提示控制。

未来展望:构建多感官交互平台

DecartAI表示,MirageLSD只是其多感官交互平台的第一步。接下来,团队将陆续推出:

- 音频生成与语音控制

- 情感识别与反馈机制

- 音乐与节奏同步生成

- 更精细的物体与空间控制

整个夏季,团队将持续发布模型升级与功能更新,包括:

- 面部一致性增强

- 语音指令控制

- 对象级编辑功能

- 流媒体直播支持

- 跨平台视频通话整合

用户现在即可通过官网体验MirageLSD,iOS与Android应用将在下周上线。

数据统计

相关导航

腾讯混元 AI 视频

ViMax

Pollo AI

Utopai Studios

Vidu

Google Vids

通义万象