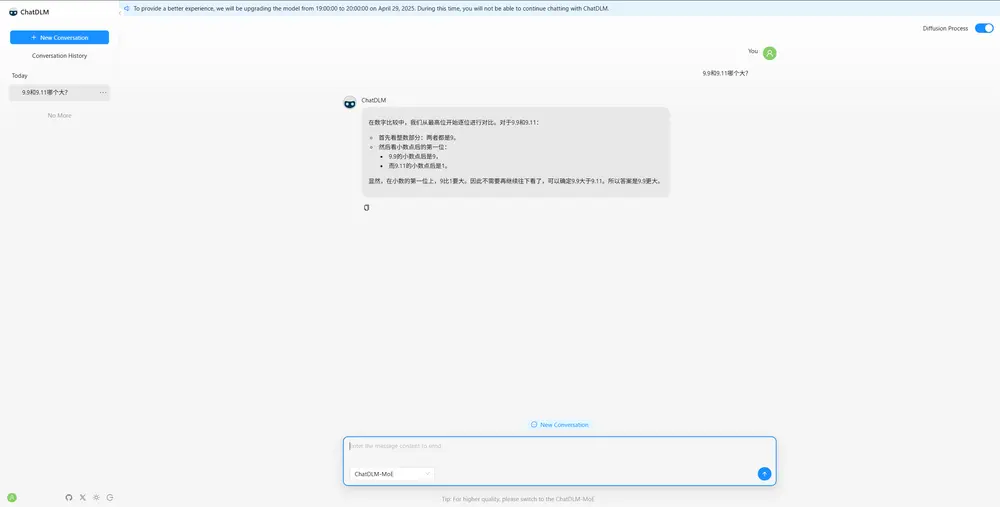

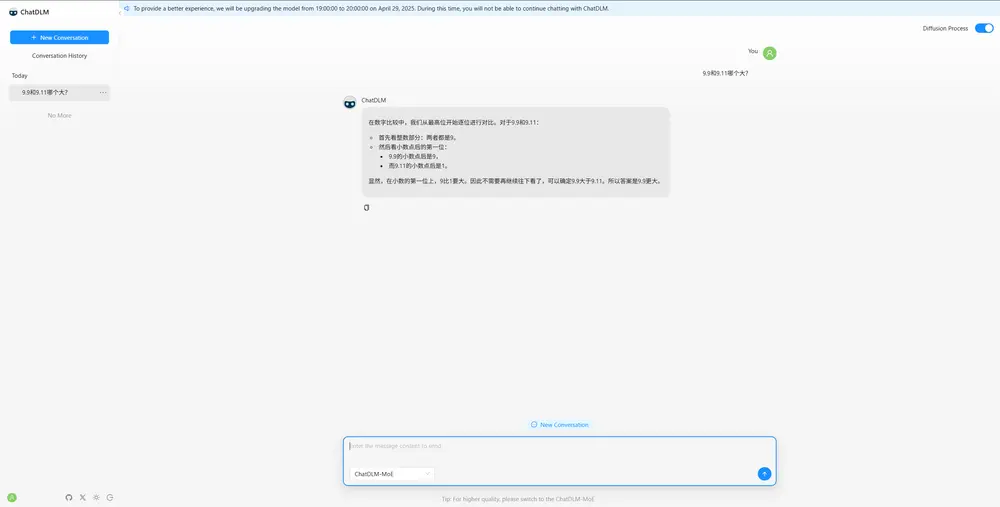

快手旗下 Qafind 实验室推出了 ChatDLM,一款基于块扩散(Block Diffusion)和专家混合(MoE)架构的扩散语言模型,官方宣称其为“世界上最快的扩散语言模型”。在 英伟达 A100 GPU 上,ChatDLM 的推理速度高达 2800 tokens/秒,是 DeepSeek 7B 的约 30 倍。同时,它支持超大的 131,072 tokens 上下文窗口,能够高效处理非常长的文本,为文档级生成和实时交互提供了全新的可能性。

1. 模型概述

模型类型:基于块扩散(Block Diffusion)的扩散语言模型(DLM)+ 专家混合(MoE) 参数规模:70亿 上下文窗口:131,072 tokens(行业领先) GPU 推理速度:A100 GPU 上每秒 2800 tokens

ChatDLM 的设计目标是兼顾速度和上下文能力,通过创新的架构和优化技术,在保持高性能的同时扩展了上下文窗口长度,使其适用于更复杂的场景。

2. 核心组件

2.1 块扩散(Block Diffusion)

块扩散是 ChatDLM 的核心机制之一,通过将输入文本分割为多个块并在连续空间中并行执行扩散操作,显著提升了处理效率。

文本分区:将输入分成固定大小的块(例如每块 512 tokens),每个块独立进行扩散。 逆向去噪:每次迭代对每个块应用训练好的去噪网络,结合跨块注意力机制以获取全局上下文信息。 迭代计划:默认迭代步数为 12–25 步,根据块的收敛情况动态调整,避免冗余计算。

2.2 块并行(Block Parallelism)

块并行技术进一步提升了吞吐量,通过并行处理所有块,将复杂度从传统的 O(n²) 降低到 O(n√n)。

跨块摘要 token:通过共享关键信息实现上下文传递,确保全局一致性和局部细节的平衡。 内存优化:减少重复计算和存储需求,使超大上下文窗口成为可能。

2.3 专家混合(MoE)

专家混合架构通过动态路由选择最合适的专家模块,增强了模型的表达能力和灵活性。

专家数量:每层包含 32–64 个专家,门控网络为每个输入选择 Top-2 专家。 并行运行:专家路由与扩散去噪过程并行执行,最小化额外开销,同时提升模型性能。

2.4 超大上下文窗口

ChatDLM 的上下文窗口扩展至 131,072 tokens,得益于以下技术创新:

微调旋转位置嵌入(RoPE):从训练长度(4096 tokens)平滑扩展到推理长度(131k tokens),确保稳定性和一致性。 层次化 KV 缓存:最近块使用完整键值(KV)存储,较旧块使用低秩摘要,有效控制内存占用。

3. GPU 推理优化

为了在硬件层面最大化性能,ChatDLM 实现了多项 GPU 推理优化技术:

动态迭代:根据块的收敛难度动态调整迭代步数,简单块提前退出,平均迭代次数减少至约 12 步。 混合精度:所有矩阵运算和注意力操作使用 BF16 数据类型,既保证数值稳定性,又节省显存。 混合并行与 ZeRO 分片:结合层级并行、数据并行以及参数、激活和 KV 缓存分片技术,支持多 GPU 扩展。

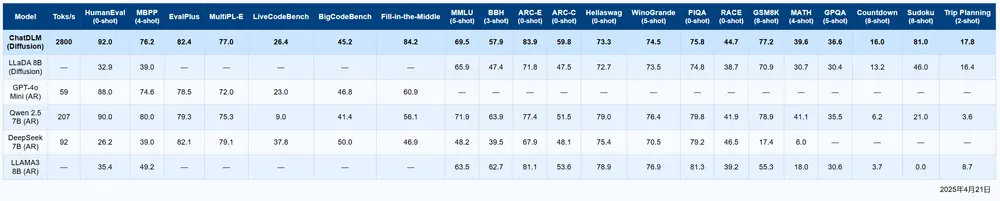

4. 性能基准(A100 GPU)

ChatDLM 在英伟达A100 GPU 上的表现令人瞩目,以下是其性能基准:

| 指标 | 值 |

|---|---|

| Token/秒 | 2800 |

| 上下文窗口 | 131,072 tokens |

| 迭代步骤 | 12–25 |

| HumanEval(零样本) | 92.0 |

| 中间填充 | 84.2 |

| ARC-E(零样本) | 83.9 |

这些数据表明,ChatDLM 不仅在速度上遥遥领先,还在生成质量和任务适应性方面表现出色。

5. 应用场景

ChatDLM 的超大上下文窗口和高速推理能力使其适合多种应用场景:

文档级生成:例如长篇小说、学术论文或法律文件的生成和编辑。 实时交互:支持高频率对话系统,如客服机器人或虚拟助手。 数据分析:处理超长日志文件或结构化数据的分析与总结。 多模态任务:结合图像、音频等多模态信息,生成更丰富的内容。

6. 结论与未来工作

ChatDLM 的推出标志着扩散语言模型在速度和上下文能力上的重大突破。通过结合块扩散、动态 MoE 专家路由和 GPU 推理优化,ChatDLM 在 A100 GPU 上实现了 2800 tokens/秒 的吞吐量和 131k tokens 上下文窗口 的支持,为文档级生成和实时交互开启了新的可能性。

未来的研究方向包括:

自适应迭代:进一步优化迭代策略,减少不必要的计算。 图注意力集成:引入图神经网络(GNN)增强上下文建模能力。 多模态扩散:扩展到图像、音频等多模态任务,满足更广泛的应用需求。

数据统计

相关导航

百宝箱 Tbox

Coze Studio

OpenClaw Mission Control

StreamLake

Strix

新Personal Computer

Twin