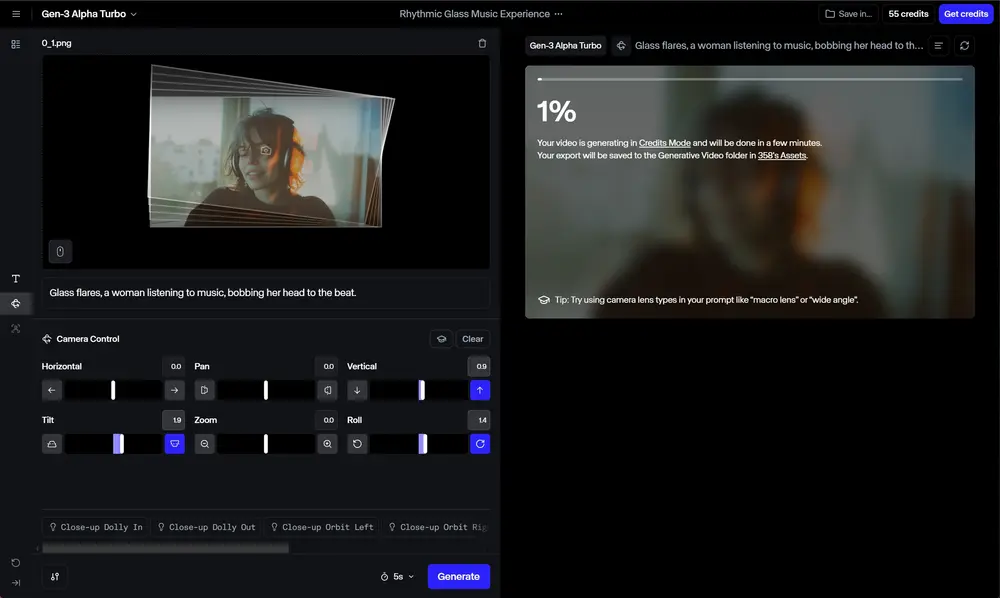

随着AI视频生成领域的竞争愈发激烈,每周都有新的、逼真的视频生成模型发布,早期领导者Runway并没有在能力方面让步。相反,这家总部位于纽约的初创公司——由谷歌、英伟达等公司投资超过1亿美元——正在推出新的功能,帮助其脱颖而出。今天,Runway为其Gen-3 Alpha Turbo视频生成模型推出了一套强大的新AI镜头控制功能。

新功能概述

这些新功能允许用户在生成新视频时,对AI生成的效果和场景进行更细致的控制,而不仅仅是随机“掷骰子”。用户现在可以放大和缩小场景和主题,甚至保留AI生成的角色形式和背景,将他们和观众真实地置于一个完全实现的、看似3D的世界中——就像他们在真实的电影片场或现场一样。

高级镜头控制功能包括:

- 设置运动方向和强度:用户可以选择镜头的运动方向和强度,从而更精细地控制视频的视觉效果。

- 水平运动:平滑地围绕主题或从不同视角探索地点,增强沉浸感和视角。

- 运动动力学:工具集允许将各种镜头移动与速度斜坡结合,适用于生成视觉吸引人的循环或过渡。

- 戏剧性的放大和缩小:用户可以执行电影风格的放大,深入场景,或执行快速缩小,引入新上下文,改变叙事焦点并为观众提供新鲜视角。

- 慢速推拉运动:让镜头稳定地滑过场景,提供受控且有意的观看体验,适合强调细节或营造悬念。

Runway在其X账户上传了一系列示例视频,展示了这些新功能的强大之处。这些视频展示了用户如何通过高级相机控制功能,实现更精确和逼真的视觉效果,从而创造出更具吸引力和沉浸感的作品。

技术背景

虽然其他AI视频生成器和Runway之前也提供了镜头控制功能,但它们相对粗糙,生成结果新视频的方式通常看似随机且有限。Runway的新Gen-3 Alpha Turbo高级相机控制功能解决了这些问题,提供了更高的控制精度和更丰富的视觉效果。

Runway 的未来愿景

Runway早在2023年12月就首次提到正在构建旨在模拟物理世界的AI模型。联合创始人兼首席技术官(CTO)Anastasis Germanidis 在Runway网站上发布了一篇文章,介绍了世界模型的概念:

"世界模型是一个AI系统,它构建环境的内部表示,并使用它来模拟该环境中的未来事件。迄今为止,世界模型的研究一直集中在非常有限和受控的环境中,要么在玩具模拟世界(如电子游戏)中,要么在狭窄的上下文中(如开发驾驶的世界模型)。通用世界模型的目标是表示和模拟广泛的情况和互动,就像在现实世界中遇到的那样。"

正如今天发布的新镜头控制功能所证明的那样,Runway在其构建此类模型并将其部署给用户的旅程中已经取得了很大进展。

评论0