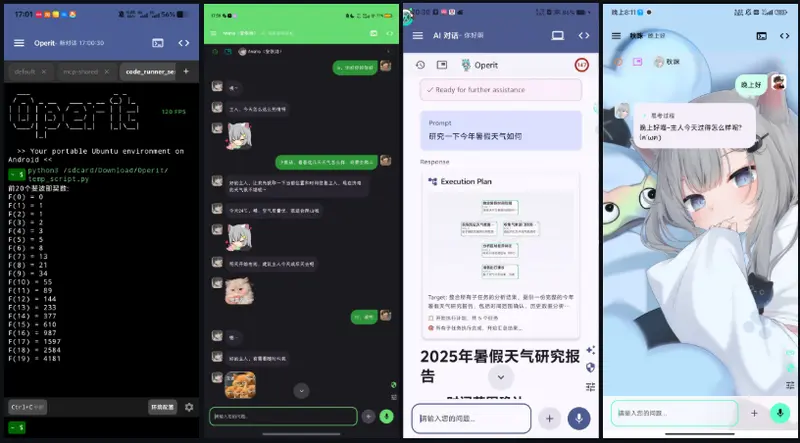

在当前大多数 AI 助手仍局限于“聊天+简单任务”的背景下,Operit AI 提出了一种全新范式:将完整的 Linux 开发环境、系统级工具调用与可定制 AI 角色,集成到一台 Android 手机中。

它不是网页包装器,也不是云端代理前端,而是真正运行在设备本地的智能体平台——除 API 调用外,所有逻辑、工具、记忆均在手机端完成。

核心能力:不止聊天,而是“操作系统级”智能

内置 Ubuntu 24 环境

- 完整 Linux 系统(基于 proot 或类似容器技术);

- 支持

apt 包管理、vim 编辑器、git、Python 3.x、Node.js; - 可自定义软件源、运行脚本、开发 Web 项目;

- SSH 支持:可连接远程服务器,或通过反向挂载将手机文件系统暴露给外部。

示例:在手机终端执行 python train_model.py,或 vim notes.md 编辑文档。

智能记忆系统

- AI 自动对对话历史进行分类、打标、索引;

- 支持按“项目”“主题”“工具”筛选记忆;

- 可导入/导出记忆库,备份个人知识资产。

人设与角色卡

- 自定义 AI 性格(如“严谨工程师”“幽默朋友”“学术导师”);

- 支持 PNG 角色卡导入,每个角色拥有独立对话历史与记忆;

- 可通过自然语言或 JSON 配置角色行为。

40+ 内置工具 + MCP 插件市场

| 类别 | 功能示例 |

|---|

| 文件系统 | 读写、搜索、解压、Git 集成、语法检查 |

| 网络工具 | HTTP 请求、网页抓取、文件上传下载 |

| 系统控制 | 安装 APK、管理权限、调用无障碍服务、支持 Shizuku/Root |

| 媒体处理 | 视频转码、帧提取、OCR 识别、调用相机 |

| 开发支持 | Web 开发、LaTeX 渲染、Mermaid 图表、代码高亮 |

通过 MCP(Model Context Protocol),用户还可一键安装社区插件,扩展能力边界。

隐私与性能:本地优先,离线可用

- MNN 本地模型支持:可加载轻量化 ONNX 或 MNN 模型,完全离线运行 AI 推理;

- 所有对话、文件、记忆默认存储在设备内部存储,不上传云端;

- 工具调用采用只读操作并行执行,提升响应速度;

- 支持 Tasker 集成,触发自动化工作流(如“收到短信 → AI 分析 → 自动回复”)。

交互体验:为高阶用户设计

- 语音球悬浮窗:随时唤醒连续对话,支持本地 TTS 与自定义音色;

- Markdown 完整渲染:支持 LaTeX 公式、代码块、表格、Mermaid 流程图;

- 桌面宠物(桌宠):WebP 动画角色可悬浮显示,支持表情切换;

- UI 高度自定义:主题颜色、字体、间距、内边距均可调整;

- 平板优化:分栏布局、工具栏折叠、状态栏隐藏。

多模型支持与开发友好

- 支持 OpenAI、Claude、Gemini、百灵、OpenRouter、LM Studio 等多模型后端;

- 消息气泡显示模型名称与提供者,便于调试与切换;

- 原生 ToolCall 支持:兼容 DeepSeek 等模型的思考-工具调用协议;

- 工作区支持 项目类型选择(如“Python 项目”“Web 应用”),自动配置环境。

快速开始

- 系统要求:Android 8.0+,建议 4GB+ 内存,200MB+ 存储;

- 安装方式:从 官方 Release 页面 下载 APK(切勿从第三方渠道安装,以防篡改);

- 首次启动:按引导配置模型、工具、权限,即可开始使用。

安全提示:应用需“无障碍服务”“存储权限”等系统权限以实现工具调用,请仅在可信设备上启用。

版本演进(2025 年关键更新)

- v1.6.3(2025-12-08):原生 ToolCall、SSH 文件系统、模型多选

- v1.6.0(2025-10-21):MNN 本地模型、Ubuntu 24 终端、MCP 市场

- v1.5.0(2025-09):Ubuntu 24 完整集成、桌宠、深度搜索

- v1.0.0(2025-05):首个正式版,支持 Shizuku/Root 与基础工具调用