OpenScreen - 最新版

OpenScreen是一款免费开源的录屏剪辑工具,虽不是 Screen Studio 的 1:1 克隆版,却精准覆盖了大多数用户的核心需求,且个人与商业用途完全免费。

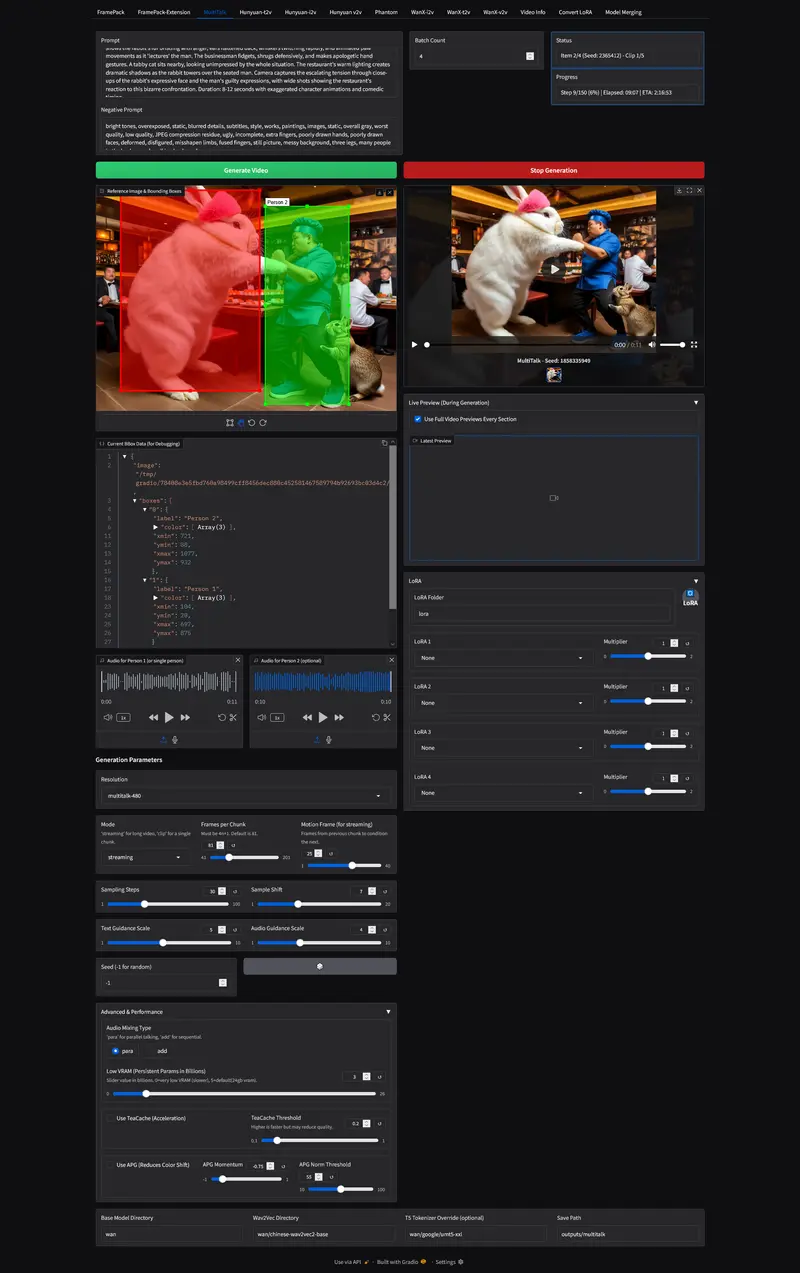

H1111 是一个为 kohya-ss/musubi-tuner 推理脚本打造的图形化前端,专为高性能、高画质视频生成设计。它不仅支持主流视频模型,还集成了显存优化、LoRA 管理、多任务队列等实用功能,是当前最完整的本地视频生成工具之一。

H1111 当前支持以下视频模型的推理:

其中,Wan2.2 是目前开发最活跃的主线,推荐使用两个分支:

wan2.2b:最稳定,适合日常使用lightx2v:功能最全,支持 4 步 LoRA 快速生成切换分支只需执行:

git switch wan2.2b # 或 lightx2v

/lora 文件夹中的 LoRA/loraWan2.1_I2V_14B_FusionX_LoRA.safetensors模型文件要求(放入 H1111/hunyuan/):

FramePackI2V_HY_bf16.safetensors(或 FramePack_F1_I2V_HY_20250503.safetensors)clip_l.safetensorsllava_llama3_fp16.safetensorsmodel.safetensorspytorch_model.pt使用建议:

images/sectional.png);;; 分隔):0:A blue penguin runs into McDonalds.;;;1:He jumps on a table and eats...;;;2:He flexes his muscles.

性能参考(RTX 4090):

详细文档:FramePack 使用说明

模型文件要求(放入 H1111/wan/):

wan2.1_i2v_480p_14B_fp16.safetensors(必须精确命名)multitalk.safetensors(来自 MeiGen-AI)chinese-wav2vec2-base/(音频编码器)模型来源:

安装依赖:

pip install -r requirementsMulti.txt

使用提示:

Low VRAM = 5,48GB 卡设为 20SkyReels-V2-I2V-14B-720P-FP16.safetensorsSkyReels-V2-I2V-14B-540P-FP16.safetensorswan/ 文件夹,在 WanX-i2v 标签页使用系统要求:

安装命令(PowerShell):

python -m venv env

env\Scripts\activate

pip install typing-extensions

pip install torch==2.7.0+cu128 torchvision==0.22.0+cu128 --index-url https://download.pytorch.org/whl/cu128

pip install -r requirementsTorch27.txt

pip install -U "triton-windows<3.4"

pip install .\sageattention-2.1.1+cu128torch2.7.0-cp310-cp310-win_amd64.whl

Sage Attention 在 Windows 上需预编译 wheel,项目已提供。

| 目标 | 推荐配置 |

|---|---|

| 最高画质 | FP16 完整模型 + SDPA Attention + Block Swapping |

| 平衡速度 | FP8 + FP8 Scaled + 适度 Block Swapping |

| 极限提速 | FP8 Scaled + Sage Attention + CFG Skip(画质有损) |

项目设计哲学:优先保证画质,速度优化为辅。