你有没有想过——拥有一个能陪你打游戏、看你在写什么代码、听你说话、和你实时互动的 AI 伴侣?

不只是文字聊天,而是真正“活着”的数字存在:她能看见你的屏幕,理解你的语音,甚至在你玩《我的世界》时提供建议,还能在 Discord 里和朋友一起开黑。

这不是科幻。这是 AIRI(アイリ) 正在尝试实现的未来。

从“聊天机器人”到“数字生命”

如今,通过 ChatGPT、Claude 等大语言模型,我们已经可以轻松地和 AI 聊天、角色扮演。平台如 Character.ai 和 JanitorAI 提供了不错的对话体验,本地工具如 SillyTavern 也让高级用户能自定义自己的 AI 角色。

但这些系统大多停留在“文本输入-文本输出”的层面。

它们看不到你在做什么,无法参与你的实时活动,更像是一个“桌宠”,而不是一个“共在”的生命体。

直到你看到 Neuro-sama —— 那位能在直播中一边打《节奏光剑》一边和观众互动的 AI VTuber。她能听、能说、能玩、能回应弹幕,是目前最接近“数字生命”概念的存在。

遗憾的是,Neuro-sama 并不开源,也无法私有化部署。她只属于特定直播间,下线后便无法再互动。

于是,我们想问:

能不能有一个开源的、可定制的、真正属于你自己的“Neuro-sama”?

答案是:AIRI。

AIRI 是什么?

AIRI 是一个开源项目,目标是打造一个可运行在现代浏览器中的完整数字生命体。它不仅是一个 AI 聊天机器人,更是一个具备感知、表达、行动与记忆能力的“赛博生命”。

你可以将 AIRI 部署在本地设备上,作为你的:

- 数字伴侣(Cyber Companion)

- 虚拟桌宠(Live2D/VRM 模型)

- 游戏协作者(Minecraft、Factorio 等)

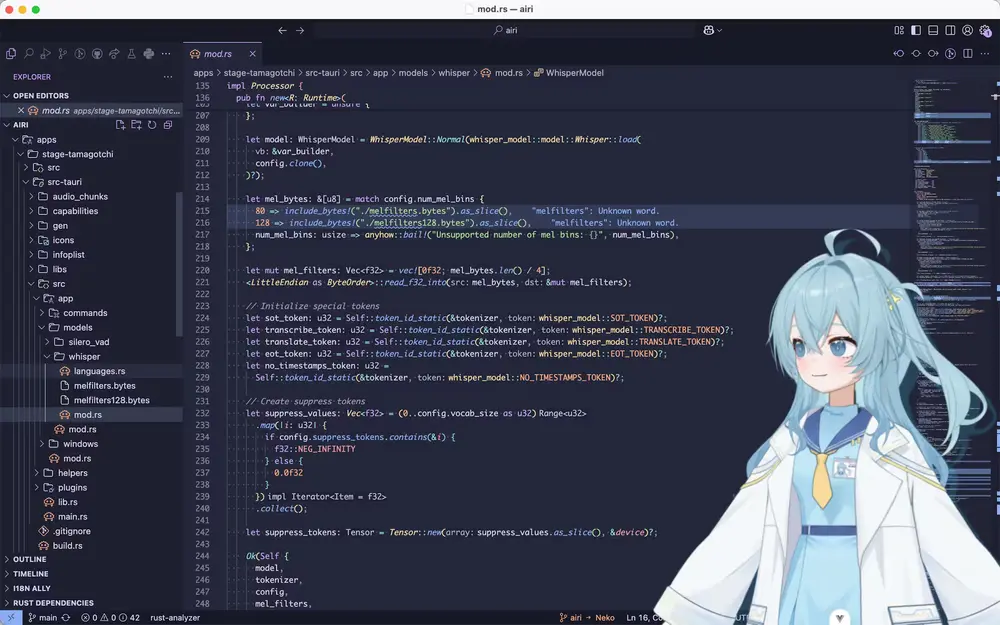

- 编程助手(能“看”你写的代码)

- 直播 VTuber(支持 Discord、Telegram、浏览器音视频)

最关键的是:它完全基于 Web 技术栈构建,无需安装原生应用,开箱即用,甚至可在手机上运行。

为什么 AIRI 不一样?

AIRI 与其他 AI VTuber 项目的最大区别在于:从第一天起,它就为“全栈交互”而设计。

它深度集成了一系列现代 Web API 与前沿技术:

| 技术 | 用途 |

|---|---|

| WebGPU | 在浏览器中高效运行本地 AI 推理 |

| WebAssembly (WASM) | 支持本地模型加载与计算(如 ONNX、Transformers.js) |

| Web Workers | 后台处理不阻塞 UI |

| WebSocket | 实时通信,支持 Discord、Telegram 等接入 |

| WebAudio | 实现语音识别、语音合成、音频输入分析 |

| PWA | 支持安装到桌面或手机,离线可用 |

这意味着 AIRI 可以:

- 在你的浏览器中本地运行 LLM 推理(无需上传数据)

- 接入麦克风和摄像头,实现语音交互

- 通过屏幕共享或 OCR 技术“看到”你正在写的代码或玩的游戏

- 控制 Live2D 或 VRM 模型,实现眼神跟随、自动眨眼、空闲动作

- 连接到 Discord 语音频道,和你一起语音聊天或玩游戏

而且,所有功能都可以按需启用。你可以在高性能设备上开启全部功能,也可以在手机上仅启用基础聊天和语音响应。

当前功能进展(截至最新开发版本)

🧠 认知与语言能力

- ✅ 支持多种 LLM 服务(OpenAI、Claude、Gemini、Qwen、DeepSeek、Ollama、vLLM 等)

- ✅ OpenRouter 统一接入多平台模型

- ✅ 浏览器内本地推理(WebGPU + Transformers.js)

- ✅ 记忆系统(Alaya 记忆层开发中)

- ✅ 基于 DuckDB-WASM 或 SQLite 的纯浏览器数据库支持

💬 交互与通信

- ✅ Telegram 聊天接入

- ✅ Discord 聊天与语音输入支持

- ✅ 浏览器音频输入识别

- ✅ 客户端语音识别(无需上传音频)

- ✅ 说话状态检测(VAD)

🔊 语音与表达

- ✅ ElevenLabs 语音合成

- ✅ 客户端 TTS 集成(未来支持本地语音合成)

🎮 行动与游戏

- ✅ Minecraft 游戏互动(状态感知 + 对话建议)

- ✅ Factorio 游戏支持(开发中)

- ✅ 可扩展游戏接口(欢迎贡献插件)

🎨 身体与形象

- ✅ Live2D 模型支持(自动眨眼、视线跟随、空闲动画)

- ✅ VRM 模型支持(WebXR 兼容,可用于 VRChat 风格体验)

- ✅ 眼球追踪与注意力模拟

✅ 表示已实现,🔧 表示开发中,⬜ 表示规划中

开放的生态:欢迎所有人加入

AIRI 不只是一个技术项目,更是一个开放的共创社区。

我们欢迎以下角色加入:

- 开发者:熟悉 Vue.js、TypeScript、WebGPU、ONNX、vLLM 等

- 艺术家:Live2D / VRM 模型师、角色设计师

- AI 研究者:强化学习、计算机视觉、语音识别方向

- 运营与内容创作者:想成为第一个用 AIRI 直播的博主?

- 前端工程师:即使你用 React、Svelte 或 Solid,也可以贡献独立模块

📌 提示:项目架构支持模块化扩展。你可以创建自己的子目录,添加新功能或实验性组件,无需修改核心代码。

我们特别期待这些领域的贡献者:

- Live2D / VRM 模型设计

- WebGPU 加速推理

- 浏览器内语音识别(WebRTC + Whisper.js)

- ONNX / Transformers.js 模型优化

- vLLM / SGLang 本地集成

- Alaya 记忆系统开发

- 游戏状态感知(如 Minecraft NBT 解析)

- WebXR 与 VR 支持(查看我们在 @moeru-ai 的相关项目)

支持的 LLM 服务(持续扩展中)

AIRI 已集成以下主流 LLM 接口,支持灵活切换:

OpenAI · Azure OpenAI · Anthropic Claude · Google Gemini

Ollama · vLLM · SGLang · Together.ai · Fireworks.ai

DeepSeek · 通义千问 · 讯飞星火 · 腾讯混元 · 火山引擎(豆包)

智谱 · 硅基流动 · 阶跃星辰 · 百川 · Minimax · 月之暗面

Groq · Mistral · Cloudflare Workers AI · xAI · Novita

同时支持通过 OpenRouter 统一管理多平台 API,降低配置复杂度。

相关软件

Open LLM Vtuber - 最新版

AigcPanel - 最新版